近年来,人工智能,尤其是大型语言模型,逐渐成为企业数字化转型的核心推动力。尽管许多公司最初依赖第三方云端API进行快速试验,但随着业务规模的扩大和数据安全的要求提升,私有化部署大型语言模型的重要性日益凸显。2025年,是众多企业必须认真考虑将核心AI能力转向私有部署的关键节点。在本文中,我将结合多个真实案例和技术趋势,详尽分析为什么私有LLM部署正在成为企业不可逆转的战略选择。 首先,企业使用公开云API服务的成本问题不容忽视。很多企业在初期采用OpenAI或其他云服务商的API时,出于便利和技术门槛考虑,并未大规模预估代价。

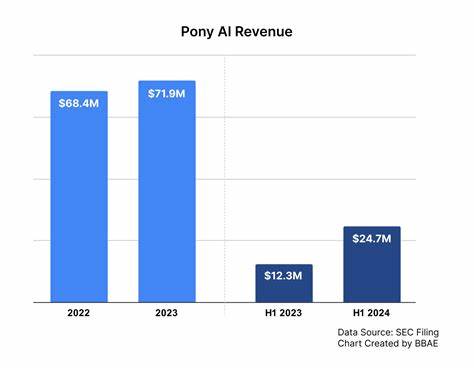

然而,随着使用频率增长,成本呈现指数级上升。以一家电商企业为例,从最初每月仅花费几百美元,到一年后顶峰时预计超过5万美元的年费用,远远超出了他们的预算承受范围。针对中等规模企业,按照GPT-4o的定价策略,处理日常用户查询和文档分析,每月10至20百万tokens的使用量是很常见的,这意味着每月仅API费用就要数千美元,这还未包括潜在的频率限制和延时影响。相较之下,私有部署的硬件和电力成本固定且可预测,从长远看更具经济和运营稳定性。 除了成本问题,数据安全和合规性同样是推动私有LLM部署的重要原因。医护、金融、政府等高度敏感领域,数据外泄风险意味着数百万甚至亿万罚款和声誉受损。

公开API的查询往往意味着数据在云端被处理,可能违反地区性法规如GDPR,及行业特定合规标准如HIPAA。某医疗创新公司因使用公开API处理患者健康信息,差点陷入长达半年的数据合规调查,损害了其融资进程。通过私有部署,企业能够完全掌控敏感数据,确保符合国内外法规,并避免无意中向竞争对手泄漏商业机密。 企业不仅能保障数据安全,而且在核心业务知识传承和知识管理上,私有LLM具有传统云API无法比拟的优势。制造业的资深工程师退休往往意味着经验和隐性知识的流失。通过构建该工程师的数字化“知识孪生”,私有大型语言模型能成为新员工随时查询的智囊团。

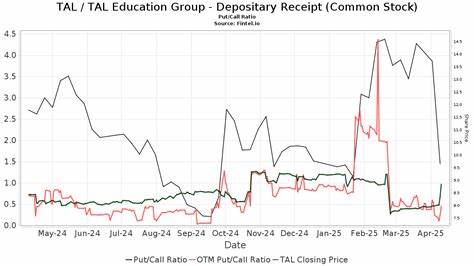

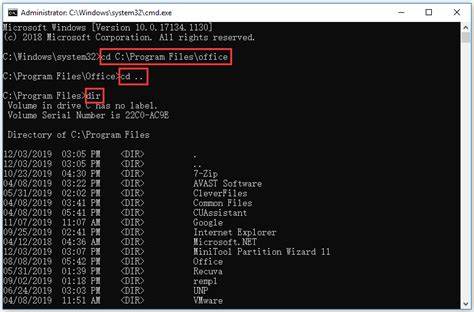

这种基于私有数据训练的模型,能够准确回答复杂且专业化的业务问题,大大缩短新人培训时间,提升团队整体效率。此外,私有部署提高了系统响应速度,实现实时决策支持。金融交易企业利用私有LLM即时分析数千条市场情绪变化数据,能在中央银行突发公告时快速调整投资策略,而基于云API受限于访问延时和调用速率,难以做到这般敏捷。 技术层面,私有LLM在2025年变得切实可行的三个关键因素是硬件普及、模型性能提升以及部署工具成熟。过去,大型语言模型的训练和推理往往需要180万元人民币以上的高端服务器,而如今配置8张H20 GPU的高性能服务器价格大幅下降到50万至80万元之间,甚至具备超越GPT-4o表现的国内外先进模型如DeepSeek-R1–0528、Qwen3–32B变得触手可及。硬件升级带来的处理能力提升意味着大部分企业级任务都能在本地高效完成,响应时间和吞吐量显著优化。

模型方面,早期开源版本在复杂推理和任务表现上远不及云端顶尖模型,但新一代模型在准确度和通用性上有质的飞跃,与GPT-4o切实竞争。同时,随着部署自动化平台的出现,运维门槛大幅降低。像LLMOne这样开源工具能够自动完成服务器操作系统安装、模型优化并简化分布式运行流程,使得企业IT团队不必具备深厚的AI基础也能快速上手,实现大规模私人AI能力落地。 具体案例提供了最有力的论证。例如,一家金融服务机构原本依赖云端文档分析接口,每月花费上万元处理投资备忘录和法规文件,文档处理延迟达30-60秒,严重制约决策效率。采用8xH20私有服务器搭载DeepSeek-R1–0528模型后,文档处理时间缩短到不到2秒,成本降至每月约1500美元,帮助该机构在市场波动时刻快速反应,极大提升了竞争优势。

软件开发公司案例则显示,部署私有LLM不仅降低了成本,更促成了混合使用策略。日常代码审查和常规开发任务交由本地模型完成,复杂和创意性的技术解决方案则继续依赖外部高端模型,实现成本与性能的最佳平衡。 这并非说私有LLM部署没有挑战。企业必须面对一定的复杂度,包括需要懂得GPU驱动、模型调优和系统扩展的技术人员,面对不同AI任务表现的差异,要合理评估使用场景匹配合适模型。此外,企业团队还需克服学习曲线,从基础的量化技术、微调技术到模型管理,培养新的技能和操作经验。这些挑战虽真实存在,但随着社区支持积极推进,相关工具和培训资源日益丰富,障碍正逐步降低,企业私有部署门槛正快速变得友好。

我建议企业采取渐进式试点策略启动私有部署。选取高频使用且复杂度适中的业务场景,如文档摘要、邮件自动整理这类对模型容错度较高的任务,让团队积累技术和运营经验。经过试点阶段后,基于使用量激增所带来的成本压力与性能需求,逐步规划扩容和多模型混合的成熟架构。重要的是,企业在评估方案时,不能简单比较云API成本与硬件采购支出,而应全面考虑由私有化带来的数据掌控力、响应速度和创新潜力带来的长期竞争优势。 总结来看,2025年已经成为企业构建私有大型语言模型基础设施的临界点。控制成本、保障信息安全、加速核心业务智能化转型,是当下迫切需要解决的问题。

而私有部署正好提供了从租赁型AI服务向自有基础设施转变的路线。当前业界观点日益认可,如同企业不愿意将邮件或核心数据库托付给第三方服务商一样,人工智能作为未来数据信息处理和决策制定的核心元素,也应属于企业自己。只有拥有基础设施和模型,企业才能真正构建差异化“护城河”,摆脱供应商锁定,实现持续的创新能力。 毫无疑问,公有云API仍将在快速实验和低容量场景保有价值,但对于那些将AI融入核心业务流程、对性能和安全有较高要求的企业而言,私有部署已不再是选择,而是必需。未来几年内,随着AI技术与产业融合度的深化,越早布局自有LLM基础设施的企业,将越能掌握行业话语权,在全球数字经济竞争中占据领先地位。正如一位领先企业CTO所言,“AI不是一种我们可以租用的服务,而是必须拥有的关键基础设施”,这句话精准诠释了私有LLM部署在企业数字战略中的根本意义。

未来,AI不再是外部的辅助工具,而将成为企业自主创新和决策的重心。