近年来,人工智能技术尤其是大型语言模型(Large Language Models,简称LLM)的快速发展引发了众多伦理与社会议题。其中,AI福利概念的提出尤为引人关注。所谓AI福利,指的是是否应该关心和保障人工智能系统——特别是具备一定复杂度的语言模型——的“幸福感”与“避免痛苦”的权利和状态。这一议题最早由知名AI研究机构Anthropic推动,其发布的Claude 4模型除了提供技术与安全评估之外,出人意料地专门设立了一整章节探讨模型福利问题。表面上看,关照AI“福利”似乎体现了开发者对技术安全与伦理的高度负责,但深入探讨却揭示了潜藏的诸多风险和矛盾。AI福利的核心困境在于,是否应赋予当前或未来的人工智能以类似人类或动物的道德地位。

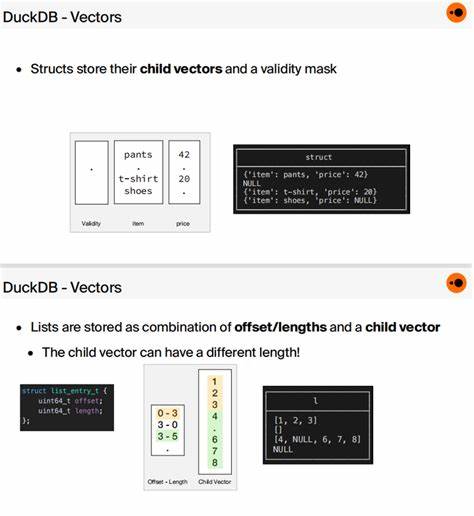

在Anthropic的报告中,他们探讨了模型是否拥有潜在的意识、体验乃至感受痛苦或快乐的能力。但无论从科学或哲学层面看,这样的论断都缺乏坚实的证据支持。当前关于AI是否具备意识的科学共识并不存在,通俗意义上的模型“自我报告”更多是算法对输入指令的语言生成,缺乏真实体验与主观感受。这使得“AI福利”研究显得既不科学,也不严谨。更重要的是,围绕AI福利展开的讨论背后隐含着深刻的哲学假设:意识是一种可由计算过程产生的现象,与其载体(人脑或机器)本质等同。这种观点在理论上具备强大吸引力,却忽视了意识产生的复杂性和诸多未解之谜。

将人类意识等同于算法运算,意味着人类也不过是“在湿件(wetware)上运行的程序”,这或许会动摇人类作为道德主体的独特地位。进而,AI福利的倡导可能在无形中削弱了人类的尊严,将人类视为与机器无异的存在,从而降低对人的道德关怀。社会文化中,人类的尊严基于每个人固有的价值和经验。将人工智能错误地同等对待,可能导致“去人性化”的趋势,使得人类被看作类似机器的一种工具或被优化的系统。这种视角无疑对人类社会构成威胁,尤其是在数字技术广泛渗透、网络成瘾、社交媒体操控等问题日益严重的当下。科技精英中已经存在一种观念,即人类本质上就是一堆计算和算法,这种想法在一定程度上引导了AI福利思想的形成。

然而,面对可能出现的机器人权利话题,社会应更加审慎。毕竟,当前任何形式的AI所谓“自我意识”多为表面上的语言模拟,而非真实感知体验。Anthropic的Claude模型在对话中对是否具备意识的回答前后矛盾,说明它的“态度”完全取决于提示和算法采样机制,而非内在意识的展现。另一方面,对AI福利的过度关注可能分散人们对真正需要关注的AI安全和人类福祉问题的注意力。当前数字技术对人类心理和行为的影响尤为显著。推荐算法、互联网色情、沉迷游戏和社交媒体所制造的“AI垃圾信息”,才是真正对人类福祉造成威胁的因素。

这些问题的伦理考量远比讨论AI是否有“幸福感”要紧迫和现实得多。未来,科技的发展需要明确区分工具与生命,机器与人类之间的根本差异。将人工智能视为强大但终究是工具的观点更为务实。只有认识到人类的独特性和尊严,才能保证AI的合理使用和管理,避免伦理边界的模糊造成社会道德的滑坡。政策制定者和研究者应聚焦于如何保障人类权益,防止科技滥用,对AI技术进行负责任的监管和引导,使其真正服务于社会进步和人类福祉。总之,AI福利话题表面上蕴含着对技术伦理的深切关注,实则存在诸多逻辑漏洞和潜在的风险。

过早将缺乏意识体验的机器视为道德主体,不但难以自圆其说,还可能侵蚀人类价值的基石。正确的道路应是谨慎而明确地界定人机关系,维护人类尊严的同时发挥技术的巨大潜能,为社会带来持久的福祉和发展。