随着人工智能技术的飞速发展,越来越多的企业和开发者开始关注高效、经济且可扩展的AI推理平台。Inference.net作为一家全球领先的推理即服务(Inference-as-a-Service)提供商,通过其遍布全球的数据中心网络,为用户提供快速、可扩展且基于用量付费的API接口,支持包括Google Gemma 3和Meta Llama 3.2在内的多种先进多模态大模型。该平台不仅确保了极低的响应延迟和高吞吐量,还通过显著降低成本帮助用户实现AI部署的最大化价值。Inference.net的崛起应运而生,带来了颠覆性的云端推理体验,满足了当前AI应用对性能、经济和易用性多重需求。Google Gemma 3是由Google DeepMind研发的多模态轻量级开源模型系列,支持文本和图像处理,涵盖超过140种语言,具备长达128K的上下文窗口,设计上兼顾了在资源受限环境的高效运行,为开发者提供了跨语言、多任务处理的利器。Gemma 3不仅在灵活部署上表现卓越,同时其适用性广泛,适合构建对上下文需求较高的对话系统、图文生成等应用场景。

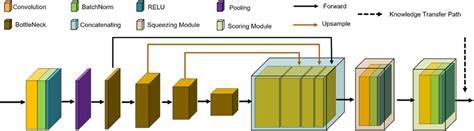

与此同时,Meta推出的Llama 3.2 Vision Instruct模型在图像识别、推理和描述方面表现出色,基于先进的视觉语言结合技术,通过FP16量化优化推理效率,支持多模态任务处理,满足了对视觉感知能力有较高要求的智能应用需求。Meta的Llama 3系列扩展涵盖不同规模,以多语言对话为核心,强调安全和负责任的使用,使得企业能够在多元化场景中灵活应用。Inference.net不仅拥有丰富的模型库,还特别注重用户的集成便利性。平台提供了与OpenAI API兼容的接口,开发者只需修改一行代码,便可轻松切换使用Inference.net服务,极大降低迁移门槛,加速项目上线。此外,配合支持TypeScript、Python以及curl等多种主流开发语言,满足各种开发环境的需求。API同时支持流式传输响应,方便实时交互和大规模推理任务。

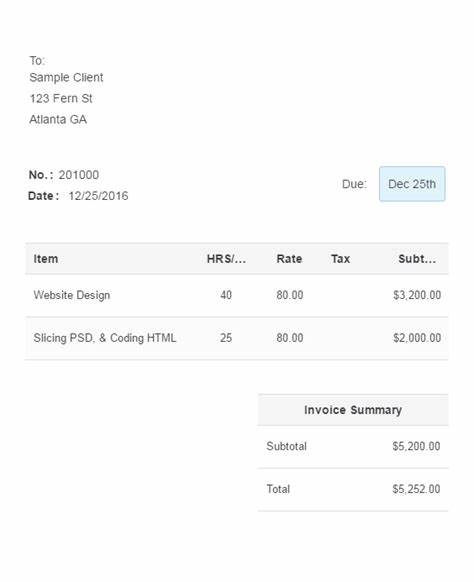

为了解决不同用户的预算和使用需求,Inference.net采用用量计费模式,用户只需为实际使用的令牌数量付费,并且平台提供清晰可控的限额设置与实时监控面板,帮助用户高效管理资源。价格方面,Inference.net承诺其费用相比传统云端推理服务最多可节省90%,以Google Gemma 3和Llama 3.2模型为例,定价远低于行业主流平台,却保证企业级的稳定性和延迟表现,这让许多初创企业、中小团队甚至大规模商业项目均能承受并高效运用AI能力。平台还针对研究人员设立了免费计算资源资助计划,支持开源AI项目,推动社区和学术界的创新发展。同时,Inference.net也为大规模企业客户提供定制化的企业级解决方案,通过专业团队协助优化部署,保障在大规模推理场景下实现低成本高效能的目标。除了传统文本生成,Inference.net在图像到文本、嵌入向量生成等多种任务上均有丰富的模型支持,种类齐全,应用灵活。用户可以通过在线Playground快速试用模型效果,方便调参和测试。

无论是实时聊天机器人、大数据批量推理,还是复杂的结构化数据提取,Inference.net均提供对应的API接口和示例代码,助力开发者高效构建多样化AI解决方案。平台还深度整合了如LangChain、LlamaIndex等流行的LLM工程框架,进一步简化了复杂工作流的开发难度,使得数据驱动型应用的构建更加便捷和可靠。从基础设施层面,Inference.net依托全球分布式GPU集群,实现了弹性扩展能力,保障客户在业务高峰时段也能获得稳定的计算性能。先进的调度与编排系统确保资源合理分配,最大限度优化成本效率。平台同时持续更新和丰富模型目录,新发布的优秀模型会及时接入,为客户提供最前沿的AI技术支持。行业用户的广泛评价也验证了Inference.net的价值。

多个创业公司和技术团队反馈,通过切换到Inference.net,其月度成本大幅下降,性能稳定性满足甚至超出预期,并获得了优质的技术支持。这些成功案例展示了该平台适合从轻量级实验开发到大规模商业应用的多元化需求。总的来看,Inference.net凭借其全球网络、丰富开放的模型生态、卓越的性能表现和极具竞争力的价格优势,正在成为AI推理领域备受瞩目的新秀。从提升开发效率、降低成本,到支持跨语言、多模态和大规模推理,平台为智能时代的AI应用提供了强有力的技术支撑。未来,随着模型规模不断升级和应用场景日益多样化,Inference.net将持续通过创新服务和优质体验助力企业与开发者实现智能化转型,抢占数字经济发展新高地。