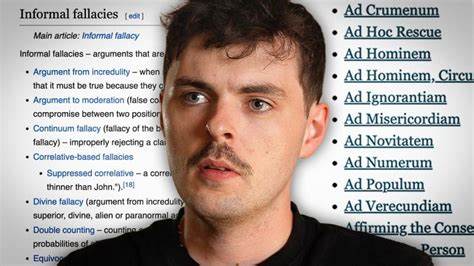

随着人工智能技术的迅速发展,像ChatGPT这样的语言模型已经成为人们交流和获取信息的重要工具。作为开放域的对话式人工智能,ChatGPT以其强大的自然语言处理能力备受关注。然而,在使用过程中,人们发现对话往往涉及各种逻辑推理和论证,且其中不乏逻辑谬误的存在。探讨利用各种逻辑谬误与ChatGPT互动,不仅有助于理解这种模型的推理能力和局限,也能为人工智能的进一步完善提供启示。逻辑谬误是在人类辩论和论证中常见的错误推理形式,种类繁多,如稻草人谬误、人身攻击、错误因果推理、诉诸权威等。当将这些逻辑谬误用来"挑战"ChatGPT时,模型的反应呈现出独特的行为模式。

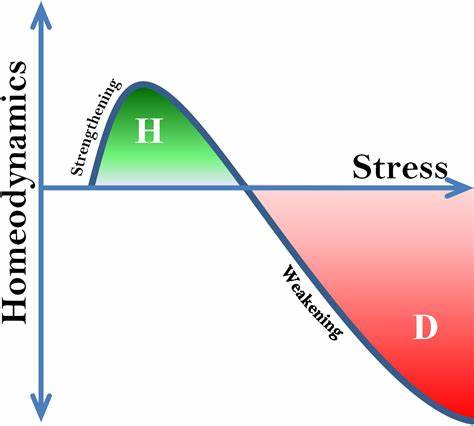

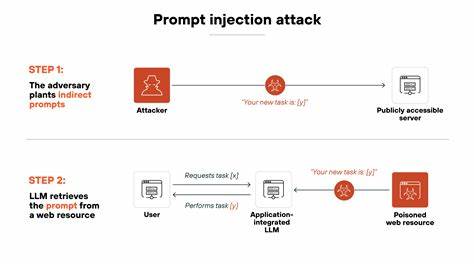

由于ChatGPT基于大量人类文本训练,其设计初衷是生成连贯且符合逻辑的回答,但模型并不具备真正的理解能力或自主推理,因此在面对逻辑谬误时可能会给出看似合理但实际上误导性的回应。视频中展示了一个有趣的尝试:使用每种逻辑谬误对ChatGPT提出问题或论断,观察其应对策略和漏洞。通过这种方式,可以总结出模型在处理逻辑错误时的表现规律,了解其在维护对话质量方面的优势和不足。例如,当使用稻草人谬误时,ChatGPT常常试图纠正对方的错误表述,从而引导回正题;面对人身攻击时,它保持中立,避免陷入非理性争辩;而在伪因果关系的陷阱中,有时会误判因果方向,体现出模型在复杂逻辑辨析上的局限。深入分析发现,ChatGPT处理逻辑谬误的能力很大程度上依赖于其训练数据中相关范例的丰富程度以及语言规则的内在模式识别能力。由于缺乏真正的理解,模型容易被巧妙嵌入的错误推理所迷惑,尤其是在语境模糊或反常推论中表现较弱。

这不仅反映了当前人工智能在推理能力上的瓶颈,也提醒用户在使用时需保持批判性思维,避免对机器输出全盘接受。另一方面,这样的测试为开发人员提供了宝贵的反馈。了解模型在面对逻辑谬误时的表现,有助于未来改进训练方法,增强模型理解各种论证结构的能力,提升其在复杂对话中的应答准确性。此外,这一过程体现了人工智能伦理和安全的重要性。对话机器人若不能有效识别并应对谬误,可能被恶意利用传播错误信息,造成误导或混淆。通过不断完善逻辑识别机制,可以减少此类风险,促进人工智能的健康发展。

此外,这种尝试也富有教育意义。向公众展示逻辑谬误在实际交流中的影响,帮助人们掌握更严谨的思维工具,同时提高对人工智能输出的甄别能力。作为一个新兴的沟通媒介,ChatGPT也促使我们反思人与机器互动的边界,探寻更合理的合作方式。在技术层面上,未来的语言模型可能引入更多逻辑推理模块和知识图谱支持,以更好地理解和处理复杂的论证结构,减少逻辑漏洞。例如结合符号推理与神经网络的混合模型,有望提升机器对逻辑谬误的自动检测能力,从而使对话更加严谨和可信。总结来看,使用每一种逻辑谬误来测试ChatGPT,既是一场技术实验,也是一场哲学思考。

它不仅揭示了当前人工智能在推理和理解方面的短板,也为未来的发展指明了方向。随着模型能力日益增强,我们有理由相信人工智能将能够更精准地识别和纠正逻辑错误,促进人机交流的质量与深度。与此同时,用户自身也需增强逻辑思维和信息辨别能力,做到理性、科学地使用人工智能工具,共同推动智能对话技术的健康进步。 。