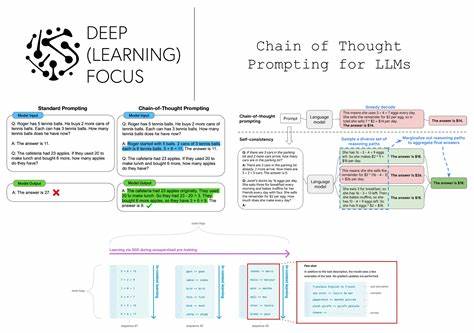

近年来,随着大型语言模型(LLM)的高速发展,链式思维(Chain of Thought,简称CoT)提示技术一度成为提升AI推理能力的热门方法。该技术鼓励模型在回答问题时进行分步骤的思考,模拟人类解题思路,从而提高复杂推理任务的准确率。然而,最新研究表明,链式思维在实际应用中呈现出效果递减的趋势,其实际价值依赖于模型类型和任务复杂度。深刻理解这一现象,有助于企业、教育和政策制定者更有效地应用人工智能技术,也为未来AI模型的优化方向提供了参考。 链式思维提示技术的核心理念是引导模型一步步拆解问题,逐层分析,最终产出答案。早期的研究如2022年魏等人的工作,展示了CoT技术在多项复杂推理任务上的显著提升,例如数学运算推断、逻辑关系解析等。

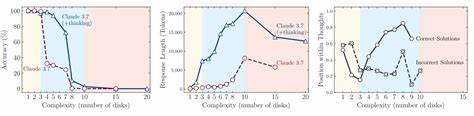

这类任务中,模型没有先天内置的复杂推理机制,因此显著获益于人工“提示”其进行连续思考。然而,随着模型架构的提升和训练策略的优化,许多新一代模型已经内置了类似于链式推理的能力,使得外界强制引导的CoT提示对它们的提升效果不断减弱。 最新由明克、莫里克等人于2025年发表的研究《链式思维提示价值的下降》深入测试了不同类型模型在使用链式思维提示时的表现差异。研究重点表明,对于未内置复杂推理机制的传统或小型模型,CoT提示仍然能够带来平均性能的小幅提升,尤其是在某些原本模型会遗漏或跳过推理步骤的情况下。然而,这一提升往往伴随着答案多样性增加,模型偶尔会产生本应避免的错误,体现出一定的不稳定性。换言之,链式思维提示虽然提高了正确率的平均值,但导致了答案准确性的波动。

另一方面,对于全新设计以推理能力为核心的大型语言模型,添加显式的链式思维提示对性能提升作用极其有限。研究发现,这些模型在未明确提示的情况下,已经默认在内部执行类似的分步推理过程。强制其显式进行链式思考,不但未能显著提升准确性,反而大幅增加了计算的耗时和资源消耗,导致响应时间和成本大幅攀升。对企业应用来说,这种耗费可能会成为限制因素,因成本效率往往是实际部署的重要考量。 这一发现对AI应用设计者和用户具有重要启示。首先,对于资源有限或模型较旧的系统,链式思维提示依然是一种有效提升模型准确率的手段,但应注意其带来的答案不稳定风险,需设计合理的后处理机制或多次验证以确保输出质量。

其次,对于依赖先进推理能力的应用,开发者应评估模型本身的内置推理特性,慎用强制CoT提示,以避免不必要的性能和成本浪费。 此外,研究还揭示了链式思维提示在实际应用中的另一个现实问题——生成的文本长度显著增加。CoT要求模型输出详细的思考过程,这不仅消耗更多的计算资源,而且因生成内容冗长,用户体验可能受到影响,特别是在对话系统和实时应用中,响应速度和简洁性尤为关键。因此,在权衡模型回答准确率和使用效率时,链式思维提示的适用程度必须得到审慎考量。 值得注意的是,链式思维提示技术的价值递减并不意味着该技术失去意义。相反,这反映了AI模型演进过程中技术与应用环境之间的自然适应与调整。

未来,随着模型的不断升级,链式思维的概念可能将被更高效、更内嵌的推理机制所替代。同时,CoT仍有待在特定领域和任务中发挥独特效用,尤其是面对复杂的多步骤决策、逻辑推断和高度专业化的知识应用场景。 如何在实际工作中更好地利用链式思维提示技术,成为当前研究与应用的关键课题。改进的方向可能包括结合模型的自适应提示机制,根据任务自动识别是否需要执行详细的分步推理,或者开发轻量级的推理协议以减少计算和时间消耗。另外,在教育和培训领域,通过引导学生采用链式思维模式启发式解题,辅以AI模型的辅助,可以实现人机协同提升理解力和解决问题能力。 未来的研究应进一步多维度评估链式思维提示在不同语言、文化和任务类别中的表现差异,探索其与模型架构、训练数据及推理策略之间的复杂互动关系。

同时,随着开源模型和算法的丰富,推动更透明、更可控的CoT提示设计,不仅能够优化性能,还能保障模型可解释性和安全性,增强用户对AI系统的信任。 总体来看,链式思维提示技术经历了从普遍适用到逐步细化的演变过程。它的价值递减趋势提醒我们,技术进步需要不断调整应用策略,不能简单依赖过去的成功经验。通过深入分析模型特点、场景需求和技术边界,才能制定更加精准和高效的AI应用方案,推动智能系统在更广泛领域实现突破与创新。随着人工智能生态的日益成熟,链式思维提示或将与其他先进技术融合,形成更为强大且灵活的推理框架,为未来智能决策提供坚实支撑。