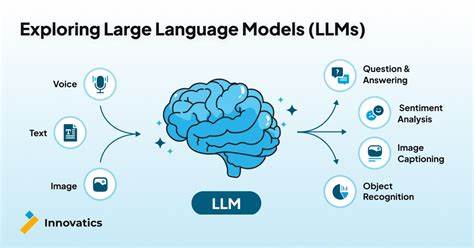

近年来,随着人工智能技术的飞速发展,大型语言模型(Large Language Models,简称LLMs)成为自然语言处理领域的革命性成果。它们凭借强大的语言理解和生成能力,在诸多应用中表现出色,如文本生成、翻译、自动摘要以及问答系统等。然而,面对日益普及的智能决策需求,公众和研究者们越来越关注这些模型是否真正理解自身的决策过程,尤其是能否准确描述其决策边界。所谓决策边界,指的是模型在输入空间中区分不同输出类别的分界线。准确理解和揭示决策边界对于模型的可解释性和安全性意义重大。近期一项题为《LLMs Don't Know Their Own Decision Boundaries: The Unreliability of Self-Generated Counterfactual Explanations》的研究揭示了大型语言模型在自我解释过程中存在重大缺陷。

本文将深入分析这项研究的发现,探讨LLMs自生成反事实解释的实践表现及其带来的挑战,同时探讨未来改善可解释性的方法和意义。自生成反事实解释作为一种解释模型决策的技术手段,尝试通过修改输入使模型产生不同结果来揭示决策逻辑和边界。换言之,模型会所谓"自我对话",生成一个修改后的输入样本,展示只需怎样改变输入就会使模型改变预测,从而为其决策寻找依据。这种方法简单直观,且易于人类理解,因此被广泛视作提升人工智能透明度的有效方法。然而,研究发现真正运行时,LLMs的自生成反事实解释表现远不理想。研究团队对多种主流大型语言模型进行了全面测试,结果显示虽然模型能在一定程度上生成有效的反事实解释,但这些解释往往"不够简洁"。

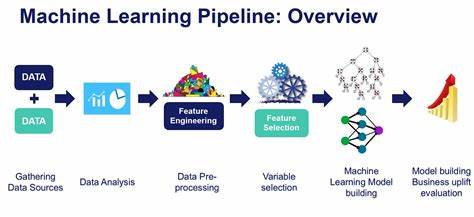

它们所提出的输入修改过于冗长和复杂,反而难以真正揭示模型的核心决策特征和边界。更令人担忧的是,当刻意要求模型产生最小修改以改变预测时,模型普遍会做出极端保守、过于微小的调整,导致反事实实际上并未真正改变预测结果。这一现象显示出模型对自身决策边界的认知实际上是模糊甚至误导性的。造成这种现象的原因可能有多方面。首先,LLMs本质上是基于大量数据统计特征构建的概率语言模型,其决策并非严格基于明确的逻辑规则,而是依赖复杂且分散的高维参数权重。它们本身没有显式的、可直接萃取的决策边界参数,因此即使能生成反事实实例,也未必能做到准确和最优。

其次,模型的训练目标和推理机制偏重于语言流畅性和语义合理性,而非决策边界的精确划定。这种任务设定使得模型更倾向于生成看似合理但在实际决策边界层面不严谨的解释。多次评估表明,这种问题在不同类型的模型、不同数据集、不同性质的任务中呈现出一致的趋势,意味这是大型语言模型固有的普遍现象,而非偶然异常。该发现对人工智能行业尤其重要。众所周知,解释性是人工智能可信赖和广泛应用的基石之一。若模型自身无法生成可靠的自我解释,不仅难以提升使用者信任,还可能在关键决策场景中带来严重风险。

特别是在医疗、金融、司法等高风险领域,依赖模型的自动解释辅助判断,若解释本身存在误导性,可能造成误判甚至恶劣后果。因此,盲目依赖当前的自生成反事实解释作为模型透明度的唯一手段不可取,亟需结合多元化方法加以弥补。为此,研究者们提出了多种可能的改进方案。一方面,可以设计专门的模型结构或训练目标,力求增强模型对决策边界的刻画能力,例如引入对抗性训练、多目标优化、或者结合符号推理方法辅助界定边界。另一方面,开发独立的解释生成模块,作为模型外设,利用额外的监督信号和约束条件,确保生成反事实解释的有效性和简洁性。此外,跨模型的对比分析、多视角解释融合等也被视为提升解释准确性和多样性的可行路径。

与此同时,从应用层面来看,用户和开发者应提高对自生成解释局限的认知,避免过度依赖,要结合其他验证手段,不断审慎评估模型输出。综合来看,尽管大型语言模型已展现出非凡的语言能力,但其对自身决策边界的认知仍存在显著盲点。自生成反事实解释作为一种直观的可解释性尝试,目前仍难以满足高精度和高可靠性的需求。未来发展需要跨越算法设计、模型训练和应用实践的多个层次,共同推动更加可信和透明的人工智能系统的诞生。总体而言,认识到LLMs在决策边界认知上的不足,有助于推动领域更加理性和安全的发展,促使技术与伦理相辅相成,从根本上提升人工智能的社会价值与人类福祉。 。