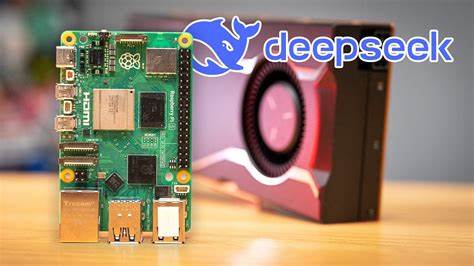

随着人工智能技术的飞速发展,尤其是大型语言模型(LLM)在自然语言处理领域的广泛应用,人们对如何在边缘设备上运行这些模型产生了浓厚的兴趣。DeepSeek作为一个高性能的开源大型语言模型家族,因其灵活的模型规模和优化算法备受关注。最近,有一项引人注目的尝试是在FPGA处理器上运行DeepSeek模型,具体是在AMD Zynq™ UltraScale+™ MPSoC平台上的Tria Technologies ZUBoard。虽然速度不快,但这一项目为边缘AI部署探索了新的可能性,带来了许多技术乐趣和实践价值。大型语言模型近年来掀起了一场AI革命,它们依托巨量文本数据,通过复杂的神经网络结构实现对自然语言的理解和生成。常见的应用包括自动问答、文本生成、代码编写等。

然而,主流的LLM部署通常需要强大的GPU支持,并且挤占大量的算力和内存资源,不适合资源有限的边缘设备。传统上,这造成了边缘计算在部署高质量AI模型方面的瓶颈。DeepSeek模型采用了先进的Transformer架构,集成了Grouped Query Attention(GQA)、SwiGLU激活函数以及多查询注意力层,大大提升了推理和训练的效率。它涵盖了从15亿到130亿参数不等的多个尺寸版本,目标是为不同的应用场景和计算能力提供合适的选择。更重要的是,DeepSeek还支持量化模型(如4位、8位版本),进一步降低了硬件需求,使模型有可能在边缘设备上运行。FPGA(现场可编程门阵列)因其高度灵活和低功耗的特性,被认为是边缘AI推理的理想平台之一。

利用Zynq UltraScale+ MPSoC芯片,结合ARM Cortex-A53核心与可编程逻辑,研究人员得以尝试将DeepSeek运行于此环境。项目中使用的Tria Technologies ZUBoard搭载1GB LPDDR4内存并搭配了PYNQ开源框架,提供了一个良好的软件开发基础。然而,FPGA的资源限制影响了模型的执行速度,尤其是在内存受限且需要借助SD卡上设置4GB交换空间的情况下,模型推理表现显著下降。这种基于交换文件的内存扩展虽然保证了运行的连续性,但显著拖慢了整体性能。部署流程首先涉及烧录适配PYNQ系统的SD卡镜像,配置启动开关确保系统从SD卡启动,然后通过USB和以太网实现设备连接与远程交互。通过浏览器访问PYNQ控制界面,可以简化日常操作和调试过程。

随后安装Ollama框架,作为管理和执行本地AI模型的工具。Ollama为无GPU环境优化,便于管理DeepSeek等大型语言模型。使用Ollama命令行安装DeepSeek 1.5B参数版本,为Zynq平台提供了契合性能和内存限制的模型选择。与云端GPU相比,DeepSeek在ZUBoard上的推理响应速度明显较慢,但边缘部署具备无网络依赖、隐私性强及节约云端推理成本的独特优势。对于某些场景,如无网络环境下的本地语义搜索、智能问答终端或自主边缘设备,性能妥协是可以接受的交换。在实际测试中,用户可通过Ollama交互接口与DeepSeek模型对话,验证其语言理解与生成能力。

系统监控工具可以实时观察CPU和内存负载情况,感受FPGA处理器在低资源环境下挑战极限的情况。DeepSeek在FPGA上的尝试虽然速度不及GPU运行环境,但为AI边缘推理提供了宝贵的实验数据和方法论。此项目展示了合理选择模型大小、量化策略和嵌入式平台架构的必要性,促进未来类似方案的优化。未来随着FPGA算力提升、内存扩展及算法优化结合,更流畅的本地推理体验值得期待。同时,DeepSeek模型的开源性和模块可扩展性也有助于社区持续改进和创新应用。总结来说,DeepSeek在FPGA处理器上的运行是一个技术试验场,既体现了当前技术瓶颈,也激发了边缘AI的更多可能。

它提示我们在寻求高效、隐私、安全的智能终端方案时必须综合考虑硬件资源、模型参数和使用场景。尽管当前速度偏慢,运行过程充满挑战,但也极具启发意义和乐趣,是AI硬件探索中的重要一步。未来的边缘智能设备,将借助类似的软硬件协同开发,成为连接云端与终端用户的关键桥梁,带来更加丰富的智能服务体验。在数字化和智能化浪潮中,探索DeepSeek与FPGA的结合为工程技术人员提供了宝贵的学习和实践平台,激励更多创新与应用的诞生。