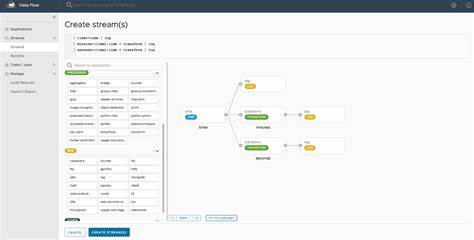

Spring Cloud Data Flow作为一款开源的流式数据处理和批处理编排平台,自诞生以来便深受企业和开发者社区的青睐。它起源于八年前的Spring XD,凭借强大的集成能力和高扩展性,在数据驱动的微服务架构中扮演了关键角色。然而,2025年4月21日,Spring官方宣布将不再以开源形式维护Spring Cloud Data Flow及其相关项目,标志着其开源时代的终结。这一举措引起了业界广泛关注,本文将详细分析该决定背后的原因、对用户的影响以及未来的演进方向。Spring Cloud Data Flow的开源旅程始于满足企业对数据流与批量任务流程的灵活编排需求,随着时间推移,它逐渐成为数据集成、实时分析和大数据处理的重要组成部分。该项目涵盖的Spring Cloud Deployer和Spring Statemachine同样具备核心地位,支撑着整体生态的稳定运转。

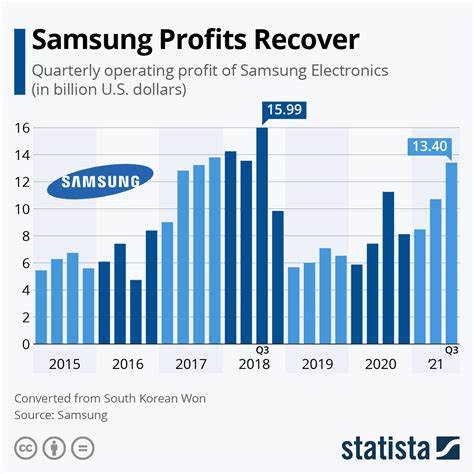

尽管受到企业客户的高度采用,实际开源社区的贡献和活跃度却相对有限。这种不平衡性成为项目长期维护的瓶颈。官方指出,绝大多数维护工作最终集中在Tanzu研发团队,社区参与程度与Spring其他项目的蓬勃生态形成鲜明对比。正因如此,维持开源版本与商业产品的并行开发带来了高昂成本和资源压力。企业需要权衡投入与回报,确保团队能聚焦于带来最大价值的领域。随着数字化转型加速推进,越来越多的组织选择Spring Cloud Data Flow作为流数据和任务控制的关键工具。

然而,官方决定从2.11.x版本开始停止开源维护,后续版本仅向Tanzu Spring的企业客户提供,并持续推送高级功能与安全补丁。该举措未影响其他Spring开源项目的活跃开发,社区依旧保持强劲发展态势。对于开发者和开源社区而言,这一转变意味着寻求替代方案或依赖第三方支持将成为现实需求。与此同时,企业客户则能获得更专注的商业支持和定制功能,提升业务系统的稳定性和扩展性。Spring Cloud Data Flow作为商业化产品的路线将持续推陈出新,近期已递交2.11.7版本补丁,包括针对企业环境的部署优化和安全强化。计划中的基于Spring Boot 3.5的更新,将进一步增强系统兼容性和性能表现。

业界分析普遍认为,此举体现了企业级开源项目向商业订阅模式转型的必然趋势。只有通过合理的商业模式支撑,才得以保证关键技术的持续创新和服务质量。此举亦警示其他开源项目需对社区建设和贡献反馈保持敏感,以延续活跃的生态系统。尽管Spring Cloud Data Flow退出了开源主流,但Spring生态系统仍拥有超过六十个全支持的开源项目,并保持众多贡献者的活跃状态。Spring以其强大的框架核心和广泛的社区基础,依旧是Java及云原生开发领域的基石。开发者们可继续受益于丰富的Spring产品组合,实现微服务、事件驱动架构及云端应用的高效构建。

在开源模式发生变化的同时,业界也涌现更多新兴的数据流处理方案。诸如Apache Flink、Apache Kafka Streams与Knative等项目持续创新,成为替代选择。此外,云服务商提供的托管数据流服务亦以简化运维和提升性能优势,逐渐被企业青睐。对于Spring Cloud Data Flow的用户,转型期需要谨慎规划技术路线,考虑现有系统的可持续性与未来扩展性。评估业务需求、社区支持及商业服务的综合因素,做出最适合自身发展的抉择。总之,Spring Cloud Data Flow开源时代的终结,反映了开源软件生态的演进和商业现实的结合。

面对新时代的数据处理挑战,整合商业支持与开源精神,将是推动技术进步的关键。开发者与企业应积极拥抱变化,持续探索创新路径,共同推动云原生数据编排与微服务治理迈向更高水平。