人工智能技术的快速发展极大地推动了各行业的变革,然而其复杂的内在机制往往对普通用户来说难以理解,解释型人工智能(XAI)由此应运而生。通过提供透明、易懂的解释,XAI不仅提升了模型的可信度,也增强了用户对决策过程的掌控感。然而,不同用户的知识背景、专业水平和认知偏好大相径庭,单一的解释模式难以满足多样化需求。基于规则的解释因其逻辑表达清晰、形式接近人类推理而受到青睐,但如何根据用户偏好进行定制化,成为当前XAI研究的焦点。本文聚焦于如何借助用户的偏好信息,通过权重函数和知识图谱,实现规则式解释的个性化定制。首先解析了解释个性化的重要性及其核心挑战。

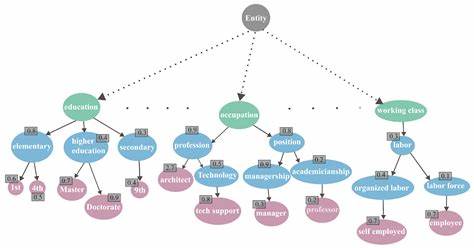

用户背景差异包括专业知识深浅、对术语的熟悉程度以及对解释细节的需求,这直接影响用户对解释的理解和接受程度。譬如医疗领域中,医生倾向于详细的医学术语解释,而患者则更易理解通俗易懂的概念描述。为解决这一矛盾,研究者提出了基于知识图谱搭建的领域语义网络,将属性、属性值及其抽象概念作为节点,通过加权函数体现用户倾向,指导解释中使用的概念层级和表达方式。该方法首先收集大量基于规则的解释模型,利用知识图谱结构连接不同属性及其语义关系,用户偏好则以节点权重的形式表达,权重值代表用户对该概念的熟悉度和重视程度。借助这些权重,算法能够筛选及组合最符合用户认知习惯的规则条件,从而生成满足用户偏好的解释规则。例如,在教育领域,若用户对专业学位术语不熟悉,解释生成方法会倾向于选择更高层次的抽象概念,如“高等教育”,代替具体学历称谓,以提升解释的可理解性。

方法流程包括数据预处理、知识图谱构建、用户偏好建模、语义聚类及候选规则生成。针对聚类生成的簇内候选规则,系统依据预设的覆盖度和精确率阈值进行筛选,保证解释的准确性和适用性。随后,通过合并验证机制避免规则条件的冲突或过度细化,最终融合用户偏好得分与传统规则学习启发式评价,选出高效且符合用户需求的个性化解释。此技术设计兼具灵活性与扩展性,可应用于多领域、多角色的场景中。实验证明,基于用户权重调整的规则解释,能够显著提升不同用户群体的理解满意度和对模型的信任度。以医疗数据为例,专家与患者两类用户分别对应专业细节与通俗解读,通过模拟权重设置,生成的规则解释清晰反映了用户知识水平差异,且整体预测性能与原始模型保持一致。

知识图谱的引入不仅丰富了解释的语义信息,也为未来多模态融合解释奠定基础。该方法避免了“千篇一律”的解释模式,通过认知偏好的引导,实现了人机交互层面的智能适配,使人工智能的成果更贴近用户实际需求和理解习惯。展望未来,真实用户的行为反馈及主观体验将成为优化算法的重要参考,结合行为数据不断完善权重学习机制,将推动解释个性化进一步深化。同时,关注高风险领域中信息简化带来的潜在偏差风险,确保解释在降低认知负荷的同时不丢失核心信息,是亟待解决的课题。总的来看,面向用户偏好的规则式解释为构建可信赖、透明且易用的人工智能系统提供了创新路径,促进了技术的社会接受与广泛应用。随着XAI技术的演进,逐步实现解释的内容、风格和细节层级的动态调节,将推动智能系统与用户的真正协同与融合,助力智能时代的可持续发展与包容性提升。

。