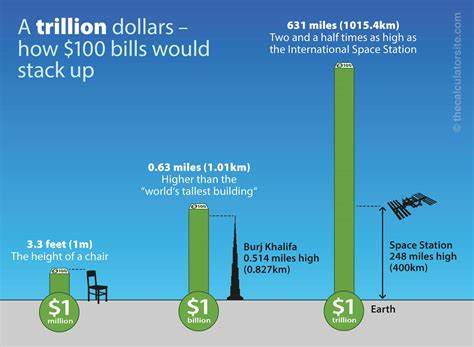

人工智能(AI)在近年来引发了科技界和资本市场的巨大变革。尤其是在语言模型领域,规模化法则的出现为模型性能的跳跃奠定了基础,同时也带动了庞大的计算资源和投资资金流向相关企业。本文以OpenAI的发展历程为核心,结合其在GPT系列模型上的探索,解读那张被誉为"万亿美元曲线"的关键图表背后的意义和演变。 2020年,OpenAI发布了名为《Scaling Laws for Neural Language Models》的论文,这篇文章凭借简洁而有力的图表,揭示了模型规模与性能提升之间令人信服的线性关系。论文中最具代表性的图表展示了模型参数数量对测试损失(test loss)的影响,图中曲线近乎完全呈现线性下降趋势。测试损失是衡量模型预测文本能力的指标,数值越低代表模型越精准。

虽然测试损失未必等同于智能水平,但这一指标为理解模型发展提供了重要参考。 这一发现无疑成为了AI制造商竞相追求更大规模模型的理据。OpenAI基于此思路先后推出了GPT-3和GPT-4,大幅提升了自然语言处理能力,引发广泛关注和市场热情。GPT-4更是在发布时带来了颠覆性的表现,令许多人感受到仿佛科幻电影中的AI成为现实。 然而,规模化法则推动的爆发式成长,也让行业投入了海量算力资源,特别是对GPU硬件的需求激增。以Nvidia为代表的GPU制造商成为这场浪潮中的最大受益者。

过去五年,Nvidia股价增幅超过十倍,市值在2025年突破4万亿美元,跃升为全球最具价值公司之一。可以说,这一切的背后,是OpenAI那张图表带给市场的信心和期待。 伴随着规模不断提升,GPT模型在多方面展现出前所未有的能力。然而,值得注意的是,随着模型参数进入数百亿乃至千亿级别后,性能提升的边际效应开始逐渐减弱。特别是在GPT-4.5发布时,尽管采用了比GPT-4多一个数量级的计算量,实际用户体验上的跃迁却远不及前几代产品。这一现象引发了行业对"规模化法则是否继续有效"的广泛讨论。

GPT-4.5之后,随着GPT-5问世,这种质疑更加明显。GPT-5尝试引入更多推理式的交互策略,例如生成更多上下文内容以提升回答质量,表明研究重点正从单纯增加模型规模转向增加模型"智能"的内涵与组织结构创新。这意味着,依赖参数数量攀升带来的"线性进步"时代正逐渐结束,AI的下一阶段突破依赖于技术路径的变革与创新。 从技术角度看,衡量AI系统能力已不再是一味追求更低的测试损失或者更大的模型规模,而是聚焦于模型架构设计、新颖的训练机制、数据利用效率以及推理效率等多维度突破。业内专家普遍认为,未来AI要实现更加人性化的理解、推理和创造能力,需要超越目前的规模扩展模式,寻求神经网络之外的突破或混合智能方案。 从市场层面来看,曾经因规模化浪潮带来的资本狂潮,正面临重新评估风险与价值的过程。

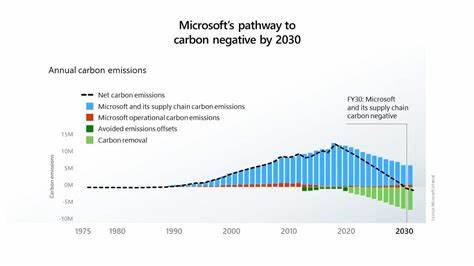

GPU厂商、数据中心运营商以及AI初创公司曾因追逐模型规模而获得快速成长,但随着规模红利逐渐消退,如何在技术创新不足的情况下维持高速增长成为关键挑战。资本市场对于AI产业链的预期正在调整,投资策略也趋于更为理性和多元。 此外,规模停止带来的另一个深刻影响是对社会和经济转型的缓冲。规模线性增长似乎预示着知识工作全面自动化、科研突破极大加速的未来,但现实中"卡脖子"的技术瓶颈提醒我们,AI替代和赋能的进程更加复杂。创新不仅需要资金和算力,更需要科学发现和工程实践的突破,变革是渐进且多面的。 面对这样的局面,AI研发机构必须重新审视技术路线,投入原创性研究,并鼓励跨学科合作。

隐式知识的提取、长期记忆机制、复杂世界模型的建立,以及强化学习与符号推理的融合,都成为可能推动下一波革命的候选方向。与此同时,开源社区、学术界和产业界的协同也越发重要,这将决定未来AI生态的多样性和可持续发展。 尽管现阶段规模化法则的盛宴似乎接近尾声,但AI的未来依然充满无限可能。创新驱动仍是核心动力,科学家和工程师们的探索精神不会停歇。过去几年的飞跃已经深刻影响了社会运转和人们生活方式,而接下来的一切,则更取决于解决"为什么"和"怎么做"的问题。 今天,当我们回望那张"万亿美元曲线",它不仅是一幅技术图谱,更是一面折射出科技产业期望与现实碰撞的镜子。

它提醒我们,技术的发展从来不是单纯的线性递增,而是充满了等待被攻克的难题与跃迁的节点。理解这一点,对于推动人工智能可持续发展,指导资本合理投入,乃至塑造未来智慧社会,都具有至关重要的意义。 总结来看,AI的规模化时代描绘了此前无法想象的技术潜力和市场价值,但同样暴露了单一扩张路径的局限。产业界正迎来性能提升方式的转型,创新方法论和技术突破成为新焦点。投资者和从业者须密切关注研究动态和生态演变,做好长远布局。未来的AI,或许不仅仅是规模的较量,更是智慧的较量。

万亿美元曲线带来的不仅是财富增长,更是对人类智慧极限的不断挑战。 。