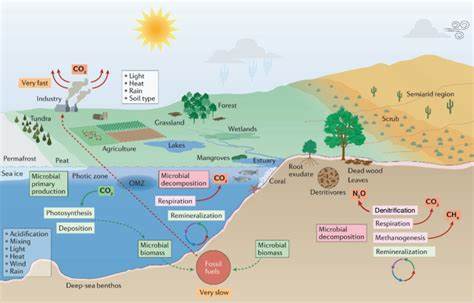

近年来,人工智能迅猛发展,计算资源的需求也日益增长,尤其是高性能GPU的使用成为限制创新和普及的关键瓶颈。传统观念认为,只有拥有数十亿美元计算资源的大型公司才能驱动前沿AI研究,这让许多中小型团队望而却步。然而,DeepSeek的最新突破彻底打破了这一认知,展现出通过提升硬件利用效率同样能够实现人工智能计算的重大节约,进而推动更广泛的技术普及和应用创新。DeepSeek的成功证明了即使规模较小、资源有限的团队,也能通过创新算法和软硬件协同设计,挑战行业龙头,打破技术壁垒。这种效率提升不仅降低了整体计算成本,还显著扩展了可用硬件资源的潜力,为整个AI产业注入新的活力。随着AI应用需求爆发性增长,降低总拥有成本(TCO)成为行业共识。

DeepSeek激发了外界对于多样化硬件架构的关注,推动开发者去最大化现有计算设备的利用率,同时加快软件层面的创新和优化。若不能有效解决软硬件协同与资源高效利用问题,未来AI发展将遇到"算力瓶颈",限制应用规模和技术推广范围。DeepSeek的案例令人深刻地意识到,人工智能发展的核心不只是硬件计算能力的堆叠,而是系统级别的架构创新、软件工具链的完善以及编译器技术的突破。回顾近25年的计算进化,知名计算架构家Chris Lattner的经历恰好映射了这一趋势。从编译器技术LLVM的开发,到OpenCL的早期加速框架,再到苹果CPU与GPU软件堆栈的重塑,以及Swift编程语言的诞生,这些里程碑性的成果都深刻推动了软硬件协同设计理念的普及。LLVM等基础设施极大地激发了计算机多样化应用,使开发者能够更高效地利用底层硬件资源。

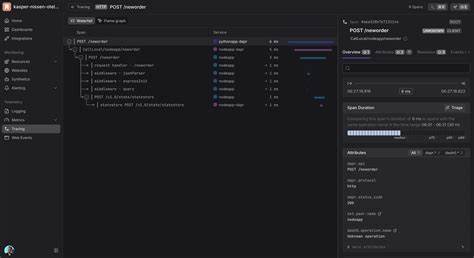

2017年,Chris Lattner将触角伸向AI领域,加入谷歌领导TPU平台的软件开发。尽管TPU在硬件性能上已突破极限,但软件兼容性问题始终困扰着开发者,尤其是缺乏类似CUDA这样的行业统一开发标准,导致模型移植和灵活应用受阻。谷歌凭借雄厚的科研资源克服了部分障碍,但这也暴露出硬件厂商普遍面临的软硬件集成难题。如今,随着AI计算需求日益多样化,各种硬件创新如雨后春笋般涌现,但软件基础设施和通用编程模型并未同步进化。尽管MLIR、Triton、OneAPI和OpenCL等技术意图解决兼容与效率问题,现实中仍存在性能不足、生态缺乏一致性、开发复杂度高等诸多挑战。正因如此,DeepSeek的突破尤为珍贵,它不仅推动了硬件利用率的提升,还激发了开发者社区对下一代编译器架构和编程语言的思考。

未来AI计算的发展路径,必然是软硬件的紧密结合,在易用性、扩展性和性能之间寻找最佳平衡。DeepSeek引发的行业反响提醒着我们,打造开放且高效的AI计算平台,是促进技术民主化的关键一步。只有降低AI开发门槛,让更广泛的中小型开发团队参与其中,才能激发真正的创新活力。借助类似DeepSeek的进展,开源语言Mojo和MAX平台等也逐渐成为行业关注焦点,为开发者提供了极具潜力的工具链,帮助他们充分挖掘底层硬件计算潜能。技术创新常常源自对现状的质疑,DeepSeek正是在突破传统GPU计算理念的基础上开创了崭新篇章。软件效率提升的"十倍"级爆发,揭示了AI未来仍充满无限可能性。

展望未来,人工智能产业迫切需要产业链上下游的协作共赢,从硬件架构创新,到软件编译器优化,再到开发者工具生态完善,缺一不可。DeepSeek的经验不仅为AI领域树立了范例,更为整个科技行业提供了深入反思和探索的方向。破解高成本计算资源的壁垒,释放普惠AI的潜力,才能真正实现技术赋能社会的愿景。总之,DeepSeek通过实现更高效的AI算力利用,推动了计算资源的民主化,为加速人工智能技术的普及和应用带来了变革性的助力。AI发展需要的不仅是硬件算力的线性增长,更是全链路的软硬件创新合作。唯有如此,才能开启AI新时代,让更多人和企业共享智能科技红利,助推社会数字化转型迈向下一个里程碑。

。