Transformer模型自诞生以来,迅速成为自然语言处理领域的主流架构,尤其是在大规模语言模型(LLM)中的应用让其成为焦点。然而,Transformer模型内部庞大的参数量和复杂的多维张量操作,使得理解其信息流转和注意力机制运行变得极具挑战。为此,采用一个极简示例来剖析Transformer最核心的运作逻辑,不仅能够极大提高学习效率,还能为深入研究打下坚实基础。 首先,示例中所使用的数据集极为简化,仅围绕少量概念展开 - - 水果与味道的关系。这种高度结构化且专注于简单语义连接的小规模数据集,摒弃了传统大规模文本语料库的复杂性,形成一种清晰可追踪的模式,使得观察模型如何学习关联变得直观明了。所有训练句子均设计为英语语法规则的简化版本,刻意包含了一些规则上的违反,以凸显语义链接而非语言本身的复杂性。

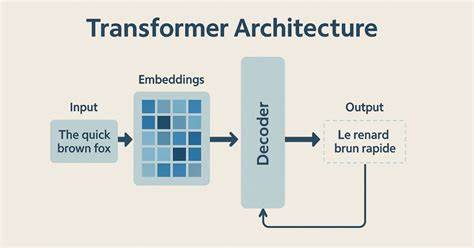

此外,特意留出一条验证句用以测试模型对"辣椒"和"辣"语义相关性的学习是否真正泛化,而非简单机械记忆。 在分词处理环节,示例避免使用诸如Byte Pair Encoding(BPE)之类的复杂子词分割技术,转而采用正则表达式对输入文本进行简单单词切分,直接定义了一个仅包含19个唯一词汇的词汇表。每个词汇对应一个唯一的Token编码,极大减轻了词汇表理解与映射的难度。如此简化的分词方法虽不具备扩展性和对未见词处理的优势,但却极大地提升了对单词语义及其表示的直观感知,是构建理解基础的理想选择。 在模型架构设计上,该示例实现了一个极度瘦身版的解码器Transformer,仅包含两层,每层配备两个注意力头,并采用20维的词向量嵌入。这与典型的LLM相比,参数规模缩减到约1万,令模型内部的数值计算和状态变化都变得可视且易于追踪。

更进一步地,示例采用了权重共享的输入输出嵌入矩阵,这不仅减少了训练参数,也使得词嵌入与预测输出的空间对应关系更加紧密,便于将中间状态直观映射回词汇空间,形成形象化的解释。 训练过程持续了约一万步,模型在训练集上损失迅速降低,并且能够在验证句"我喜欢辣所以我喜欢"后准确预测下一个词为"辣椒",证明其已成功学习到语义上的联系,而非简单的序列记忆。这个成绩在极简模型和数据背景下尤为突出,展示了Transformer强大的泛化能力和语义捕捉能力。 在对模型内部结构的可视化探索中,首先将每个词的20维词嵌入表示抽象为由五个基于每四个维度数值控制形状和颜色的立方体组成的堆栈。通过这种方式,不同token的词嵌入得以用形象化的"积木"展示,清晰地显示出不仅每个味道词如"多汁""酸""甜""辣"形成了独特的嵌入形态,它们之间还共享某些特征,如底部的浅色积木,这反映了模型捕获了味觉概念的共性,同时又区分了个体差异。此类可视化既帮助理解词向量的高维抽象特征,也印证了模型在学习词义关系时如何兼顾共性与个性的表达。

当输入一串词序列时,模型首先将其转换为对应嵌入,随后依次经过两层Transformer层的处理。在每层处理过程中,每个词的表示向量都会根据上下文信息被动态修改,这种修正通过注意力机制实现。具体而言,注意力机制允许每个词向量在更新时关注输入序列中之前位置的重要词,通过赋予不同权重,有选择地吸收上下文信息。示例的可视化揭示了不同词汇间通过颜色线条连接的注意力权重。第一层注意力体现了如"辣"这一词汇会重点关注前面词"我",帮助模型区分多义上下文。此外,词"所以"在第一层表现出对"辣"和"我"的强注意,帮助理解序列结构。

更关键的是,输入序列末尾的"喜欢"词在两层Transformer中均重点关注"辣","辣"成为了对最终预测"辣椒"起决定性参考的信息节点。这清晰地展示了权重如何集中于区别当前上下文的重要标记,使模型能够准确完成下一词预测。同时,最后一层"喜欢"的表示进化为与"辣椒"词嵌入高度相似的结构,验证了模型如何将输入语义映射到预测目标。 通过这种层层递进的向量变换,Transformer模型表现出优异的语义理解和上下文整合能力。极简示例剥离了传统大型模型中的多余复杂性,让我们得以窥见Transformer机制的本质 - - 信息表征的精细调整与层级化上下文融合。 总结来看,采用极简数据集、基础分词和瘦身模型设计,为深入解析Transformer的内在构造和运行过程创造了条件。

可视化手段不仅关注最终输出,更重视整个前向推理过程中的状态演化,使抽象的多维数值具象化为直观的图形,从而有效促进了对模型信息处理及语义捕捉的理解。此理解框架对于研究者和机器学习实践者均具借鉴意义,助力后续开发更高效、更透明的自然语言理解系统。 此外,本示例依托开源代码库,遵守MIT协议,方便复现与自定义,促进了开放科学精神和协同进步。借鉴此简化策略亦有助于教学与科普,填补Transformer理论与实践间的认知鸿沟。未来随着技术迭代,结合这类极简示例的深度解读,有望推动Transformer模型的更广泛应用与理解深化。 。