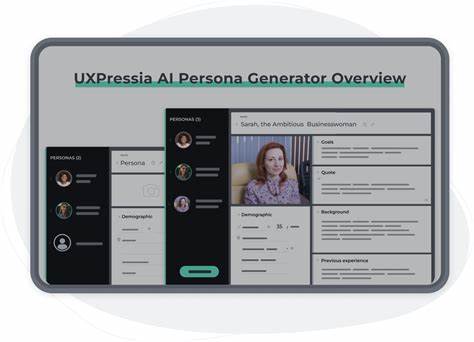

在数字时代,市场调研正经历一场革命,尤其是合成人工智能(AI)用户画像的兴起,令企业能够以低成本、高效率模拟用户反馈。生成数千甚至上万个AI用户画像,不仅能够满足细分市场的深入洞察需求,还能让品牌掌握更多隐藏的消费偏好和行为模式。然而,规模的扩大也带来了诸多技术与管理上的挑战。本文将结合一个真实案例,分享生成5000个AI用户画像的关键经验和教训,为从业者提供实用参考。 首先,为什么要生成如此庞大的AI用户画像?传统市场调研通常依赖实地访谈和问卷调查,样本数量有限且成本高昂。一般情况下,50至100个模拟用户画像已经足以覆盖大部分应用场景。

但对于成熟品牌,尤其是拥有复杂多样客户群体的企业来说,细分的客户群体往往极少,导致样本量不足以支持数据分析的准确性。通过生成5000个AI用户画像,哪怕是占比仅6%的小众群体,也能对应数百个“模拟用户”,大幅提升分析的稳定性和洞察的深度。如此海量的模拟数据,允许企业更自由地进行微型细分市场的测试,也更容易发现规模效应下才会显现的趋势。 然而,增加样本量带来的最大难点之一是“数据一致性挑战”。当生成大量带有不同背景、偏好和行为特征的AI角色时,数据格式往往变得不统一,字段缺失、不规范甚至前后矛盾的情况并不少见。有些模拟用户画像包含详细信息,而有些则极为简略,导致后续分析工作十分繁琐。

为解决这一问题,采用结构化数据模型成为关键手段。基于Python的Pydantic框架,可以定义包含性别、年龄、收入、教育背景、地域等字段的严格模型,并确保生成内容符合预期格式。这不仅减少了手动清洗的时间,也提升了数据质量和系统的健壮性。通过API直接传入Pydantic架构,能够极大降低生成失败或格式错误的概率,确保每个模拟用户的资料完备及标准化。 另一个重要挑战是“统计分布的真实性”。要获得有价值的调研结果,生成的人物画像必须在属性分布上贴合现实人口数据或品牌客户群体分布。

例如,如果目标市场30%的消费者是男性,生成的AI角色也需大致遵循这一比例。更重要的是,这些属性不能孤立出现,收入、地域、教育程度等属性之间的相关性也需合理反映。否则,即便有大量样本,分析结果依旧存在偏差,难以获得决策层的认可。在实际操作中,建立反馈循环系统十分必要。通过分析当前批次生成的人物画像分布,与目标分布进行对比,程序能自动调整后续生成策略,优先增加不足类别的人物,使整体画像逐渐符合用户设定的目标人群画像。这种持续校准方法实现了数千个人物画像的统计精度,提升了市场调研的科学性和说服力。

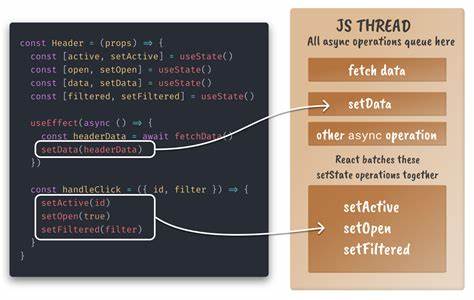

与此同时,生成数千个高质量AI角色的过程也对技术性能提出严格要求。单个角色生成的耗时在3-5秒之间,简单乘以5000后,整体生成时间甚至需要几小时。通过异步处理(Asyncio)技术,同时发起多个并发请求成为解决方案,显著缩短等待时间。但过多的并发请求容易触发API速率限制,导致请求失败和重复尝试,形成恶性循环。为避免这种“限流陷阱”,需要合理控制请求的并发数量,并结合重试机制加以调优,保障流程的稳定与高效。这一环节是规模化生成的关键瓶颈,管理不善会拖慢整个调研项目进度。

更让人关注的是成本问题。使用功能最强大的模型生成一个AI角色,耗费可能达到12美元,成百上千的请求迅速累积成巨额开销。为此,团队通过采用梯度模型,选用更小、更经济的版本进行测试或生成,成功降低97%的单个角色成本,同时保持了合理的内容质量。虽然较小模型在推理能力和细节表现上略有逊色,但面对大量基础调研任务,性价比显著提升。客户可结合预算与准确度需求,灵活选择合适的模型,兼顾效果与成本。 此外,传统的单问题-单API调用方式极大增加了总请求数量,每个角色若包含二十几个问题,便要进行数十次API调用,不仅增加响应时间,也使成本攀升。

针对这一痛点,采用数据模型一次性批量请求多个问题作为一个整体返回,成为行之有效的解决策略。整合反馈后,不仅减少了API调用次数,也降低了系统负载和费用支出,提升了运行效率。一次取回多个字段响应还可以保持上下文的一致性,防止信息丢失和重复输入。 在庞大的数据处理任务中,数据管理和文件组织也尤为重要。项目中曾因复用同一输出文件夹名,导致已生成的调查结果被覆盖,损失大量数据和时间。为避免此类“数据灾难”,将每次运行设计成幂等操作极为必要。

通过给每轮运行分配唯一目录,结合搜索点保存系统,能够随时暂停并恢复生成进度,保障数据安全与流程连续性。此举类似视频游戏中的“存档”,一旦发生异常崩溃,可避免重复劳动,保障项目稳定推进。 回顾整个生成5000个AI用户画像的过程,最大的收获是认识到规模扩展不仅仅是简单地复制和粘贴角色数据,更需要数据结构标准化、统计修正、技术架构优化和流程管理的多重配合。结构化模型保证了输出格式的规范和一致。统计修正增强了模拟数据的可信度。异步处理和批量接口降低了时间成本和调用数。

幂等设计则在意外发生时保障了效率和数据安全。成本控制始终贯穿始终,成为商业落地的现实考量。 凭借这些经验,企业可用更低的成本和更快的速度获得庞大的合成调研数据。尽管AI生成的用户画像并非100%精确,但多达85%的准确率已经超越了许多传统调研的结果,且能够轻松实现多维度、多样本跨市场的应用。品牌能够迅速测试产品理念、市场反应和用户偏好,调整策略灵活应对动态市场环境。 除了实务经验外,还值得注意的是人工智能模型本身的“人格”设置。

开箱即用的AI助手通常过于趋向讨好用户,不易获得真实、客观且批判性的反馈。在定制生成过程中,通过向API传入准确的行为指令,让模型“像怀疑主义者一样思考”,拒绝简单的赞扬,更贴近真实消费者心理,是提升调研质量的关键一步。 未来,随着AI模型的进一步进化,生成个性化、高保真度的虚拟角色的能力将更加强大。结合实时数据输入、动态媒体消费习惯和跨平台行为追踪,AI用户画像将成为品牌洞察的标配工具,为市场创新带来无限可能。与此同时,数据隐私、安全和伦理审查也将成为该领域不可忽视的课题,确保合成数据使用合法且尊重用户权益。 总之,生成5000个AI用户画像的探索过程是技术与管理的综合考验。

从模型微调、数据校正,到异步处理、成本控制,再到数据安全管理,每一步都无法忽视。通过科学规划和不断调整,企业完全可以将这一技术应用于实际调研,获得庞大且精准的消费者洞察。未来市场竞争愈发依赖数据驱动的决策,而高效的大规模AI调研正是打开新局的关键门匙。