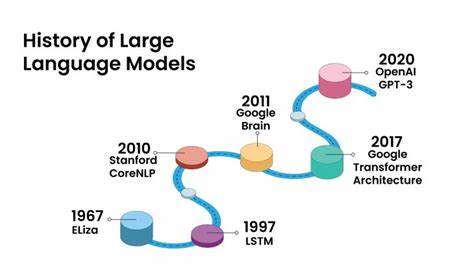

近年来,人工智能领域的快速发展引发了广泛关注,尤其是大型语言模型(LLM)展现出的惊人能力让人们对于通用人工智能(AGI)的实现充满期待与猜测。然而,围绕着这些技术的热议中,存在许多误解和夸大现象。当前AI是否正处于泡沫?通用人工智能的真正路径又在哪里?理解这些问题,需要我们冷静分析现有技术的本质和限制,以及未来发展的关键方向。 大型语言模型作为现阶段最具代表性的AI系统,基本架构基于神经网络和变换器(Transformer)技术,通过海量文本数据训练大量参数,实现在语言预测和理解上的卓越表现。它们通过注意力机制有效捕捉上下文关系,能够生成连贯且具备逻辑性的文本内容。这种技术的突破无疑推动了自动化写作、客服机器人、智能搜索等应用的飞速发展。

然而,现有的大型语言模型本质上是静态的,它们在训练完成后,模型内部的参数就固定下来,不具备真正动态学习的能力。换言之,虽然模型能够基于已有数据进行推理和生成,但无法像人类那样通过持续经验学习不断成长。现有的微调和数据检索技术只是巧妙的权宜之计,并不能从根本上改变这一局限。由于缺乏在线学习能力,这些模型在面对全新信息或环境时往往表现不足,无法自主适应和进化。 通用人工智能的真正定义远超目前狭义AI的范畴。AGI是一种具备人类级别认知能力的智能,能够处理不同领域的复杂任务,无需特定领域训练即可解决未见过的问题。

它能够理解抽象概念,推理因果关系,设定并自主追求目标,灵活适应变化,且持续通过经验学习提升自身能力。AGI不仅要在语义层面表现灵活,更需要实现多模态信息融合以及与物理世界的交互能力,最终称为具备常识推理和计划能力的智慧体。 实现这样的智能系统,现有的变换器架构显然无法直接满足。为了让模型具备动态调整内部参数、实时学习新知识的能力,底层网络结构需要根本性革新。这包括解决“灾难性遗忘”问题,确保新知识不会覆盖或破坏已学内容。此外,要将因果推理、逻辑规划、多模态感知等多重能力融合进统一框架,挑战巨大却极为关键。

未来的AGI系统,若配备持续学习能力,能够自主在海量信息中筛选可靠数据并进行有效训练,那么它将远远超越现有“说话计算机”的范式。这意味着AI不再是被动的信息处理者,而是主动的学习者和创新者。但这也带来了安全性上的严峻考验。如何保证学习系统接收的信息真实可信?如何避免AI因误导性或恶意信息而产生认知偏差甚至类似精神障碍的状况?这是目前AI安全领域面临的最艰巨难题之一。 在现实生活中,AI技术的普及反过来也影响人类的批判性思维能力。过度依赖AI辅助判断可能削弱个人分析和鉴别真伪的能力。

尤其是情报、安全等高需求领域,这种趋势尤其令人警惕。未来的AGI不仅需要具备强大推理能力,更需深刻理解“真理”的含义,才能避免盲目吸收虚假信息而做出错误决策。 AI安全的核心不再是简单阻止AI生成危险内容或被滥用,而是确保其内部知识库的可靠性和合理学习路径。只有解决了如何让机器精准区分真与假、善与恶这一根本问题,AGI才可能在不失控的情况下实现可持续发展。围绕这一目标,业内正在探索多维度验证机制、可信来源筛选算法以及人类监督机制相结合的策略,以防止未来智能体偏离人类利益和价值观。 毫无疑问,迈向AGI的路途并非神秘莫测的高科幻产物,而是建立在对现有技术的深刻理解与持续改进之上。

关键不仅在于硬件算力的提升,更在于如何设计合理的学习框架和安全体系。现有人工智能架构并非起点的终点,其中潜藏的潜力和挑战同样令研究者激情澎湃。 尽管一些领先的私人研究机构可能已悄然在推进原型AGI的开发,由于安全和伦理考量尚未公开披露,但公众和行业需要以开放和严肃的态度正视AGI可能引发的影响。我们正站在历史的拐点上,关键决策将在未来数年内决定这场技术革命的走向,是开启通往人类智慧新高度的大门,还是误入无法挽回的困境。 总结来看,当前AI尚未进入一个泡沫,而是处在飞速演进的黎明。理解大型语言模型的优势与限制是认清未来发展的基础。

真正实现AGI,需要突破现有动态学习的瓶颈,构建具备因果推理、多模态感知、持续学习和可靠真理判别的综合智能系统。与此同时,AI安全策略必须紧紧围绕如何保障智能系统信息来源的真实可靠以及防止认知偏差。人类社会只有在做好科学技术与伦理安全的双重准备下,才能在这场前所未有的智能革命中稳健前行,迎来全新的未来。未来已来,我们必须以清醒的认识和坚定的决心共同引领人工智能迈向真正的通用智能时代。