随着人工智能应用的快速发展,尤其是生成式AI和大型深度学习模型对计算资源的需求不断攀升,存储技术成为限制整体性能的重要瓶颈之一。为此,存储巨头Kioxia与图形处理器领军企业Nvidia携手合作,正致力于开发一款具备100百万IOPS(输入输出操作每秒)的超高速固态硬盘(SSD),计划于2027年投入市场。该产品不仅将支持最新的PCIe 7.0接口,还能够直接连接到GPU,为下一代人工智能工作负载提供革命性的存储解决方案。 在传统的AI计算架构中,GPU高带宽内存(HBM)虽然拥有极高的数据带宽和低延迟表现,但受限于成本高昂和容量瓶颈,无法满足日益庞大的模型参数和推理缓存要求。Kioxia与Nvidia的合作,旨在通过高性能SSD替代或辅助HBM,以实现更高的存取效率和更大容量的存储扩展。根据Kioxia SSD应用技术总工程师Koichi Fukuda的介绍,计划配备两块该AI专用SSD直接连接至单个Nvidia GPU,合计达到惊人的200百万IOPS,极大提升生成式AI模型的上下文数据处理能力,避免重复计算并加快推理速度。

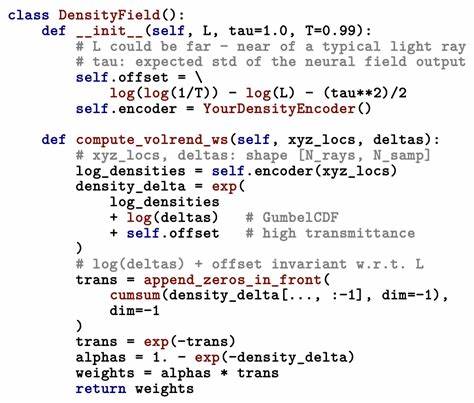

Kioxia目前拥有多条3D-NAND闪存技术路线,包括主流的TLC(三比特每单元)和QLC(四比特每单元)闪存,以及定位于存储级内存的高速XL-Flash单层单元(SLC)闪存。其最新Gen 2 XL-Flash基于112层BiCS5 NAND工艺,具备多达16个平面并行架构和更高效的读写性能,理论上支持低于5微秒的读取延迟。结合PCIe 7.0带来的传输速率提升,该技术平台将是实现百亿IOPS速度的重要基石。 此前,Kioxia发布的FL6系列SSD利用BiCS4的96层3D NAND及16平面结构,已能达到高达150万的随机读取IOPS水平。但相比目标的1亿IOPS级别,仍存在数量级差距。通过引入Gen 2 XL-Flash的多层高速堆叠技术,以及与Sandisk联合开发的高带宽闪存(HBF)技术,Kioxia有望彌补这一差距。

Sandisk与SK hynix合作研发的高带宽闪存,基于3D堆叠层叠电路及硅通孔(TSV)技术,将提供与高带宽内存极为相似的容量和带宽优势,有效缓解HBM成本压力。 此外,Kioxia此前还展示过面向边缘AI场景的高速SSD原型,容量达5TB,通过PCIe 6总线实现64GB/s带宽,采用脉冲振幅调制4级(PAM4)信号技术。若结合PCIe 7.0总线和改良后的XL-Flash堆叠结构,可实现线性扩展的IOPS性能,这为达成Nvidia所需的超高速AI SSD提供了技术路径。 该AI SSD方案的创新之一在于存储媒体与GPU的集成方式。直接连接(direct attach)意味着SSD可通过基板互连为GPU提供极低延迟、高带宽的数据访问,减少传统存储协议的开销,最大化吞吐效率。预计这一连接将依托于更高级的互联技术,如硅通孔封装与片上系统(SoC)级集成,从而保持数据路径的高效流通。

从市场角度看,Nvidia在生成式AI及深度学习领域占据领先地位,打造这样一款极致性能的AI存储设备,不仅可以提升其GPU架构的整体竞争力,还能为AI开发者和数据中心运营者带来显著的运算成本效益和性能提升。此外,Kioxia潜在的多样化产品线,包括传统NVMe SSD,结合基于CXL(Compute Express Link)的存储扩展内存设备,体现了其在未来计算存储融合趋势中的战略布局。 值得关注的是,尽管目前仍缺乏全部技术细节披露,业内分析普遍认为该SSD的百万级IOPS性能离不开多堆叠Flash dies的高度集成设计和先进的控制器技术。通过采用多通道16平面架构,优化固件算法,以及无线电调制技术的辅助,能够同时驱动更多读取请求,进而推动IOPS数字级别的大幅提升,同时保持能耗的合理控制。 展望未来,Kioxia与Nvidia的合作成果若成功推向市场,将对整个AI硬件生态系统产生深远影响。首先,大幅提升的存储性能将推动人工智能模型训练和推理的实时性,降低数据传输瓶颈。

其次,助推存储技术从传统块设备向与计算深度融合的高带宽存储内存演进,实现更为灵活有效的算存协同。更重要的是,这一跨界融合可能激发更多新型AI应用模式,比如动态上下文缓存、加速自然语言处理大型模型的推断速度等。 总之,Kioxia开发的100百万IOPS级AI专用SSD计划,不仅代表了闪存存储技术的重大飞跃,也符合Nvidia加速高性能计算未来战略的方向。随着PCIe 7.0的普及及高层堆叠闪存技术的逐步成熟,2027年这一产品面世之时,极有可能开启人工智能存储架构的新纪元,为全球数据中心及智能计算发展注入强大动力。企业研发者和投资者可持续关注Kioxia和Nvidia在存储技术上的后续动态,洞察AI硬件创新趋势,把握未来智能计算的关键突破口。 。