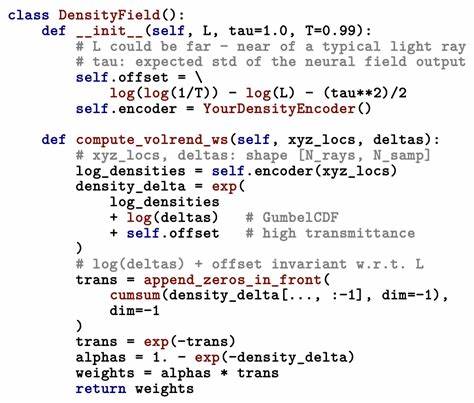

随着人工智能技术的飞速发展,AI在代码生成与编辑领域的应用越来越广泛,开发者对处理速度的需求也显得尤为迫切。传统代码编辑方式多依赖于搜索与替换工具,这种方法在面对大规模、多次编辑时频繁的工具调用和网络往返时间,极大地限制了效率的提升。Morph团队在这一背景下,通过一系列技术创新,成功实现了基于Nvidia B200显卡单机每秒处理10,500令牌的惊人速度,较此前的4500令牌提升了两倍多,为代码编辑模型性能树立了新的标杆。Morph团队的技术突破不仅提升了单次请求的处理能力,更极大缩短了代码编辑任务的整体完成时间,使得多数文件编辑操作仅需1至3秒即可完成,极大优化了开发者的实时反馈体验和工作流程。Morph的核心优势之一在于其定制化的CUDA内核设计。他们融合了注意力机制与前馈网络操作,减少了传统实现中存在的三次内存往返访问,实现了更高效的数据处理流。

特别定制的FlashAttention变体适配了代码的层级结构,使得内存带宽达到惊人的2.1TB/s。这种带宽利用率远超标准核函数的1.6TB/s,充分发挥了Nvidia H100硬件的潜力。另一方面,Morph引入了推测执行技术,在处理当前令牌序列时,同时预测并计算后续可能出现的多个令牌。这种做法基于代码的高度结构化特性,例如缩进和括号匹配等模式,达到约70%的推测命中率。在命中情况下,处理速度实现了三倍的提升,尽管推测失误存在约5%的性能损失,但整体效率依然大幅提升。除硬件优化技术之外,Morph还针对代码编辑任务对模型架构进行了定制。

相比通用大型模型,其使用了更小规模的模型,从34亿参数缩减至7亿参数,聚焦于代码合并和编辑的特定场景。通过剔除多余的词汇表内容(如非必要的中文字符),并设计了适应代码层次化结构的定制位置编码,模型更加轻量且高效。这种针对性优化权衡了通用推理能力,专注于实现快速准确的代码编辑,避免了一些模型泛化过度而带来的性能瓶颈。实践结果充分证明Morph技术的优势。在公开的基准测试中,Morph在速度和资源消耗上的表现均优于业内多种流行模型,包括vLLM搭配Llama 3.1 8B模型每秒3200令牌、TensorRT-LLM结合CodeLlama 7B每秒4800令牌,以及Morph之前版本每秒4500令牌。Morph FastApply模式不仅在单次请求处理速度上领先,更在实际代码编辑流程中实现了约35%的整体效率提升,极大缩短了用户等待时间,提高了开发体验。

这项技术带来的变革意义深远。对于支持实时代码重构、多文件协调编辑和智能编辑建议的AI开发工具而言,快速准确地处理大规模编辑请求,实现低延迟反馈,是提升用户体验和工作效率的关键。Morph协助构建的快速应用方案简化了多个编辑请求的处理流程,避免了频繁调用外部工具导致的性能损耗,实现了一次调用完成全部编辑的高效模式。目前,Morph专注于对于结构化语言如Python、JavaScript和Go的代码编辑优化,对于C++中大量宏使用等复杂语境仍存在一定挑战。此外,为保证编辑准确性和模型效率,输入数据要求严格的结构化格式,且仅支持单请求处理,不包含多轮会话上下文。未来发展方向同样令人期待。

Morph计划通过新一代称为Blackwell的B200内核,实现每秒超过15,000令牌的处理速度。此外,多文件编辑的事务一致性处理和将推理服务部署至边缘节点实现响应延迟低于100毫秒,都是推动真实应用场景升级的重要目标。总的来说,Morph团队对硬件与模型软硬结合优化的探索,展现了AI代码编辑领域性能突破的巨大潜力。通过定制硬件加速算法、推测执行策略以及轻量化、任务定制化的模型架构,Morph不仅响应了行业对速度的强烈需求,也引领了代码生成技术向更加高效智能发展的方向。随着该技术的不断成熟和生态完善,未来智能代码编辑工具将提供更快响应、更高准确度的服务,显著助力程序员提升生产力,加速软件开发进程。 。