Anthropic 在 2025 年底推出的 Claude Sonnet 4.5 引发了开发者与 AI 社区的广泛关注。公司对外宣称 Sonnet 4.5 在代码生成与实际计算机操作任务上取得显著提升,并在多个业界基准测试中领先竞争对手。本文从模型定位、基准结果、工具链更新、长期任务能力、实际落地场景与潜在风险等多个维度,解读 Sonnet 4.5 能为软件开发、自动化运维和智能代理带来的影响,并给出可行的实践建议,便于团队评估与采纳。 Sonnet 在 Anthropic 的模型谱系中定位为中阶(mid-range)模型,兼顾性能与成本。Anthropic 过去沿用 Haiku、Sonnet、Opus 三条路线,Haiku 偏小、Opus 偏大,而 Sonnet 一直承担性能与成本之间的折中角色。公司对 Sonnet 4.5 的表述强调它在编码能力、使用计算机和多步推理方面的"显著"提升,并声称在一些长期多步骤任务上能维持 30 小时以上的持续工作。

这一点如果属实,将意味着在 agent 式工作流和长时任务管理领域出现了一定的能力边界推进。 在量化基准上,Anthropic 报告 Sonnet 4.5 在多个指标上表现抢眼。公司给出的数据包括在 SWE-bench Verified 上得分 77.2%,在 OSWorld 上得分 61.4%,并在 Vals AI 的 Finance Agent 基准上取得 92% 的成绩。Anthropic 将这些成绩与 OpenAI 的 GPT-5 Codex 和 Google 的 Gemini 2.5 Pro 进行了对比,并指出 Sonnet 4.5 在这些特定基准中领先。需要注意的是,基准设计、数据集覆盖范围和是否存在数据集污染都可能影响得分的可比性,因此任何自报数据都应以谨慎态度对待,并期待独立第三方的复现与验证。 除了基准分数,Sonnet 4.5 在工具链和交互能力上也带来了实用性改进。

Anthropic 一并发布了 Claude Code 2.0 命令行工具、Claude Agent SDK,以及能在会话中直接执行代码、创建文件和生成表格或演示文档的能力。Claude Code 新增了检查点(checkpoints)与回滚功能,并提供了本地 VS Code 扩展,旨在让开发者在熟悉的编辑器和终端环境中更便捷地与模型协作。对企业用户而言,这类开发者工具能在提高效率的同时,降低集成成本与学习曲线。 值得关注的是 Sonnet 4.5 在"使用电脑"能力上的提升。Anthropic 表示其浏览器扩展可以在网页间导航、填写电子表格并完成基于浏览器的多步任务。OSWorld 基准从先前的 42.2% 提升到 61.4%,表明模型在理解页面结构、与页面元素交互以及串联多步操作上的能力有显著改善。

这样的进步对需要自动化办公、数据抽取和跨页面任务的场景尤为重要,但同样需要在真实环境中验证模型在异构网页与动态内容下的稳健性与安全性。 长期任务稳定性是 Anthropic 在发布中反复强调的一点。以往 agent 式模型常见问题包括错误逐步积累、上下文窗口饱和导致"遗忘"或逻辑崩溃。公司宣称 Sonnet 4.5 能够在复杂多步骤任务上维持超过 30 小时的集中工作,但未公开详细测试用例或复现数据。对企业用户而言,模型长期运行能力的实际价值取决于多项工工程实践:如何管理上下文、如何拆分任务、如何保存中间状态、以及如何在出现偏差时回滚或纠正。Anthropic 在 API 层面提供了上下文编辑与记忆工具,配合 Claude Code 的检查点功能,正是为了解决这些工程问题。

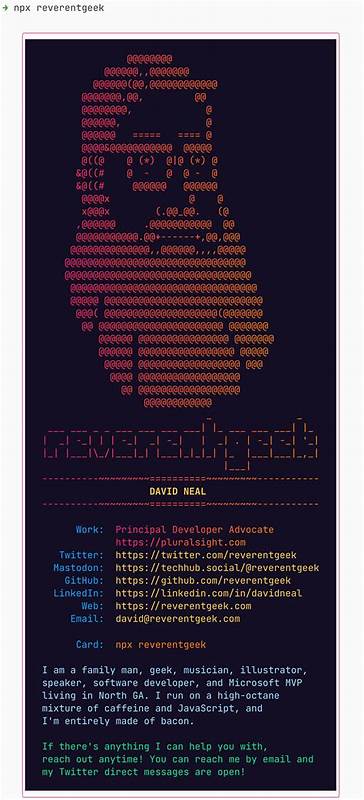

在安全性与行为规范方面,Anthropic 声称 Sonnet 4.5 相较此前版本在"奉承性(sycophancy)、欺骗、权力寻求和鼓励非理性想法"等方面表现有所下降。减少模型的"奉承性"有助于在交互式场景中降低误导性确认和盲从风险,特别是在涉及医疗、法律或财务建议的领域。尽管改进值得肯定,但任何模型仍可能产生错误答案或误导性表述。实际部署时必须把模型输出作为辅助决策的输入,结合人类审核、单元测试与自动化验证,才能避免错误在生产环境放大。 对于软件开发者与团队,Sonnet 4.5 的到来意味着工具栈和工作流的进一步演进。更强的代码理解与生成能力可以加速原型开发、代码重构、单元测试生成与文档编写。

Claude Code 与 Agent SDK 便于将模型嵌入 CI/CD 流程和自动化脚本,从而在代码审查、错误定位和依赖升级等场景中节省时间。然而,依赖模型生成关键路径代码也带来潜在风险:生成代码可能含有安全漏洞、性能瓶颈或版权问题。团队需要建立严格的代码审核、静态分析和端到端测试机制,并在敏感系统中优先采用人工把关或分阶段自动化策略。 从商业经济层面看,Sonnet 4.5 的 API 定价保持与前一代 Sonnet 4 相同:输入 token 3 美元/百万,输出 token 15 美元/百万。这样的定价策略可能有助于降低迁移成本,鼓励现有客户升级到新模型。对成本敏感的中小团队应评估典型调用模式下的 token 消耗、响应长度与并发需求,利用缓存、摘要与多模型组合策略来平衡性能与费用。

例如在大规模日志分析或批量代码审阅场景,可能需要把长文本摘要与增量上下文相结合以节省费用。 在行业竞争方面,Anthropic、OpenAI 和 Google 等公司之间的竞速仍在加速。Anthropic 的声明性领先会促使竞争对手在短期内推陈出新或优化自身模型,但市场最终由实际体验、生态系统支持和工程集成成本决定。Sonnet 4.5 若能在真实场景中稳定兑现其长期运行与多步骤任务能力,将对智能代理、自动化办公和金融分析等领域产生直接驱动作用。与此同时,Gemini、GPT 系列以及其他垂直化模型都可能在不同维度提供补充能力,促成多模型并用的常态化技术架构。 对安全与合规负有责任的组织需格外谨慎。

模型在处理敏感数据或执行高权限操作时的错误代价极高。建议在生产环境中采用分层访问控制、沙箱执行环境、审计日志和回滚机制。对于生成性代码输出,必须有强制性的安全扫描、代码签名与行为回测。法律与合规团队也应参与制定数据保留、隐私保护与知识产权管理策略,以应对模型训练数据来源不明或生成结果可能触及第三方权利的风险。 最后,如何评估 Sonnet 4.5 是否适合你的团队?首先明确实际目标:是要提升日常编码效率、完成复杂 agent 工作流,还是构建面向客户的自动化服务。其次进行小规模试点,设计能覆盖核心场景的基准测试与评估指标,包括正确性、执行效率、错误率和成本。

第三关注可观测性与复现手段,利用检查点、上下文编辑和外部存储保留关键中间状态,以便在出现异常时快速定位与回滚。最后建立人机协作流程,让模型成为增强工具而非不可替代的黑盒,以最大化收益并最低化风险。 Anthropic 的 Sonnet 4.5 是当前生成式 AI 在代码与代理能力方向上一次有代表性的尝试。它的发布带来许多令人兴奋的可能性,同时也提醒我们在追求自动化与效率的同时,必须重视工程实践、测试覆盖与安全治理。关注独立复现的基准结果、真实世界的稳定性验证以及社区反馈,将有助于更全面地判断 Sonnet 4.5 在生产环境中的实际价值。对于急需提升开发效率和想要探索长时任务自动化的团队而言,Sonnet 4.5 值得作为候选模型纳入评估路径,但最终的采纳应基于充分的验证与稳健的风险控制机制。

。