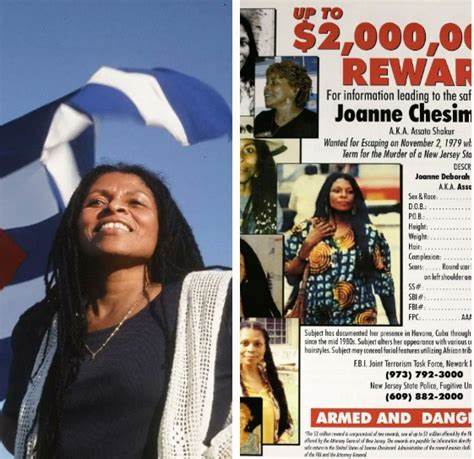

近年生成式人工智能与大型语言模型(LLM)成为公众舆论和信息传播的新战场。有关报道显示,以色列政府通过外包合同聘请美国公司,制作面向年轻受众的内容并部署到各类平台,同时试图"影响GPT类模型的框架结果"。这一举动在技术、法律与伦理层面都引发广泛关注。本篇从事实梳理出发,分析这种策略是如何运作的,它可能带来的影响,以及媒体平台、AI公司、监管机构和公众应如何回应。 概述与已知事实 公开资料表明,以色列通过一家名为Clock Tower X的美国公司签署了数百万美元合同,委托其开展面向Z世代的线上传播工作,目标包括在TikTok、Instagram、YouTube和播客等渠道上每月至少达成数千万次曝光。合同中还提到将"创建网站并生成内容以交付GPT对话中的框架结果",并使用搜索引擎优化工具来提升相关叙事的可见性。

合同的外包链条、与保守媒体网络的整合、以及由曾参与美国政治微定向的顾问参与,引发了对外部力量如何通过现代数字工具影响公众舆论的担忧。与此同时,相关法律框架如美国的外国代理人注册法(FARA)也为公开透明和监管提供了参考路径。 技术路径的可能方式与工作原理 大型语言模型在生成回答时,依赖训练数据与某些情境下的外部检索机制。模型本体的训练通常是在大规模语料上完成,未来模型迭代会吸纳互联网上的新增内容;同时,许多应用在实时或近实时检索网页、新闻和知识库以丰富回答来源。基于这些机制,影响模型输出的策略可以是多层次的。 一方面,通过创造大量网页、社交媒体内容和多媒体素材并优化其在搜索引擎中的排名,相关叙事会更频繁地出现在公开语料和检索结果中,从而提高被未来训练数据或检索插件采纳的概率。

另一方面,若某些AI服务使用外部检索(包括搜索引擎抓取或自有索引)作为上下文输入,那么高可见度内容就更容易在回答时被引用或作为"框架"影响模型输出。 需要强调的是,将AI"训练"成更倾向某一立场并非仅靠发布内容就能立刻实现。模型训练涉及复杂的数据筛选、标注、微调与人类反馈回路。短期内,通过向检索层或索引层投放大量可见内容,更可能改变检索驱动的回答倾向,而长期在根本上改变模型价值观或倾向通常需要对训练数据和微调流程的干预。 搜索引擎优化与平台策略的角色 搜索引擎优化(SEO)工具和算法预测平台能够帮助传播者分析关键词、优化页面结构并提升在Google或Bing等搜索结果中的排名。结合社交平台的算法模型,传播团队可以设计内容以增加用户参与度,从而利用算法放大效应扩大覆盖。

同时,通过与大型媒体网络或意见领袖合作,消息的扩散会获得更高的信任度与转发率。若一套叙事能在多个权威或高流量节点同时出现,其在爬虫抓取和索引时被判定为"重要信息"的概率也随之增加。对AI系统而言,这意味着这些叙事更可能进入训练和检索语料池,间接影响生成结果。 法律与合规问题 涉及外国政府或政治实体在海外传播信息时,FARA等法律要求披露代理关系与资助来源以保障透明度。如果以色列相关项目通过美国公司执行并为美国公众提供定向政治传播,相关从业方可能需要依据法律进行注册与披露。 此外,社交媒体平台与搜索引擎在其服务条款中通常对付费推广、虚假信息与协调性操作(coordinated inauthentic behavior)有明确条款。

若传播活动采取隐蔽方式、操纵算法或采用机器人账号群,平台可能依据政策进行限制或封禁。另一方面,公开合法的付费传播与宣传属于言论自由的范畴,但透明公开与明确标注仍是界定合法性与道德性的关键。 伦理与信息治理风险 国家层面的传播活动进入AI与社交平台生态,会带来多重伦理风险。首先,是透明度问题。公众有权知道信息来源与资助主体,尤其是当这些信息旨在影响重大政治或军事议题时。其次,是内容真实性与公平性。

若信息被刻意包装或选择性呈现,公众对事实的认知可能被扭曲,影响民主讨论与决策过程。 第三,AI系统本身的公正性与中立性面临考验。模型若被大量单一立场的高可见度内容覆盖,可能在回答敏感问题时表现出偏向,从而降低公信力。第四,对弱势群体或目标受众的影响不容忽视。年轻人、信任社交媒体作为主要信息来源的群体,可能更容易受到定向内容的影响,进而改变舆论格局。 平台与AI公司的责任与应对措施 AI公司与平台在面对此类国家级传播行动时,应承担更大的透明和治理责任。

首先,平台可在检测到大规模协调发布、异常流量或非自然链接结构时,启动更严格的审查和标注流程。其次,AI提供商应改进训练数据的溯源与可解释性,建立训练语料的质量控制机制与来源记录,便于追踪模型偏差的根源。 此外,AI回答中引入来源引用与证据溯源可以降低单一叙事对用户认知的影响。对检索式生成系统,明确标注引用来源、提供多样化视角以及在敏感问题上提示不确定性,都是增强公信力的有效手段。 研究界与独立审计的作用 学术界与第三方审计机构应加强对AI生成内容倾向性的长期研究与监控。通过定期对模型在涉外舆论、冲突话题和历史叙事等敏感领域的表现进行测评,能够及时发现并纠偏潜在的系统性偏向。

独立的模型问责与算法透明审计,可以促使企业在数据收集、标注与微调过程中提高标准。与此同时,新闻机构与事实核查组织需要强化对线上信息源的溯源能力,尤其对那些频繁出现在AI回答与搜索结果中的域名和账户,应优先核查其所有权、资金来源与背后动机。 公众教育与媒体素养 面对日益复杂的数字信息生态,提升公众的媒体素养尤为重要。教育应覆盖如何识别信息来源、理解搜索引擎与推荐算法的基本原理、学会交叉核验重要事实以及在遇到极具情绪性或煽动性的内容时保持警觉。 对年轻受众的专门教育尤其必要。学校与社群组织可以把算法识别、信息验证方法与批判性思维训练纳入课程,帮助下一代在被信息洪流包围时仍能形成独立判断。

政策建议与监管路径 监管机构应在保护言论自由与维护信息完整性之间寻找平衡点。一方面,需要明确对外国政府在境内进行政治传播的披露义务,确保公众知悉消息来源;另一方面,应设立跨部门的监测机制,及时识别并应对潜在的协调性信息操作。 对AI领域的监管应聚焦于训练数据的可追溯性、模型输出的可解释性与平台责任。可行的措施包括要求大型模型提供训练数据来源摘要、对敏感领域(如国际冲突、选举、公共卫生)的生成内容实施更高标准的审查,以及鼓励或强制AI公司与独立第三方共享评估结果。 国际合作也是关键。信息流通全球化意味着单一国家无法独自应对跨境信息操作。

多边框架可以在规范透明度、交换威胁情报以及建立伦理标准方面发挥作用。 结语:技术中立性并非价值中立 当技术成为国家战略工具时,社会必须对其可能带来的后果保持警惕。生成式AI与社交媒体既能促进信息流通,也可能被用于强化某一方的叙事优势。应对路径并非简单禁止或放任,而是要通过法律、平台治理、学术研究与公众教育的协同努力,提升透明度、维护信息生态的多样性与真实性。 面对以色列或任何国家试图通过内容生态影响AI和公众舆论的行为,最有效的防御不是封闭信息,而是构建更强大的信息治理体系,使公众能在更多元、透明和经得起验证的信息环境中进行判断。只有这样,技术才能真正服务于公共利益,而非成为单向影响的工具。

。