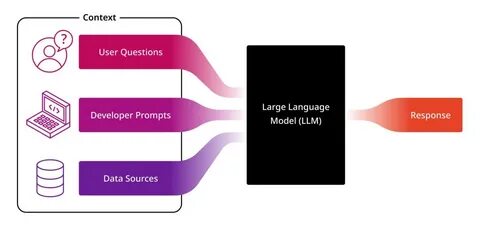

近年来,人工智能领域的突破性进展引发了广泛关注,尤其是在大语言模型(LLM)的应用中表现出惊人的自然语言理解与生成能力。然而,传统观念认为LLM只能处理文本信息,对视觉和听觉等多模态数据的处理需要专门设计和训练。令人振奋的是,最新的研究成果表明,LLM竟然可以在完全没有额外训练的条件下,具备“看”和“听”的能力,这一发现不仅提升了AI的多模态交互水平,也为跨领域智能应用铺平了道路。本文深入探讨这一创新技术背后的原理、实现方式及其广泛的应用前景。首先,理解LLM“看”和“听”的能力,需要明确其基础架构。传统的大语言模型如GPT系列,通常仅基于大规模文本语料进行训练,通过自回归生成模型捕捉语言规律。

最新的研究在此基础上叠加了视觉与音频特征提取模块,这些模块不需要专门针对图像或声音进行微调,而是利用已有的多模态表征技术将视觉、音频数据转换成可被语言模型理解的嵌入向量。关键在于,这些嵌入向量通过设计巧妙的提示语(prompting)与语言模型接口对接,使得模型能在无须重新训练的情况下,直接从多模态输入中提取语义信息。换言之,模型本质仍是语言理解专家,但被赋予了能够间接“感知”图像和音频的能力。技术层面来看,视觉信息一般通过卷积神经网络或者视觉变换器(ViT)编码成定长特征向量,音频则通过声学特征提取器(如Mel频谱转换)转换成相应的表示。随后,这些特征被映射到与语言模型词向量空间相兼容的维度,使得语言模型可以利用其强大的语言推理与生成能力,将视觉听觉信息转换成自然语言描述或者回答与之相关的问题。更为出色的是,这套系统可以灵活应用于多种任务:图像描述自动生成、视频内容分析、音频事件检测与转写等,无需针对每项任务单独训练模型,极大降低了多模态AI系统开发的复杂度。

此外,这种无训练跨模态能力的实现还得益于海量语言模型在语言和知识理解上的先天优势。模型能够结合视觉音频信息与丰富的语义背景,实现准确细致的理解。例如,当模型“观看”一张照片时,它不仅识别出图中的对象,更可基于已有知识推断情景含义。类似地,“聆听”一段音频时,它能理解声音性质、语义信息甚至情感色彩。这一点是传统单一模态技术难以企及的。实践中,科研团队已经通过多项公开数据集验证了此技术的有效性。

图像字幕生成任务中,模型无需训练即能输出流畅准确的图像描述;音频字幕生成同样表现优异,能够自动识别音频成分并生成文字说明。综合多模态信息,模型还实现了跨模态信息融合的高质量生成,如结合图像与音频提示生成更具表现力的内容。这一突破不仅推动了人工智能在视觉和听觉领域的融合发展,也为智能助手、多媒体分析、智慧医疗、自动驾驶等行业带来了革命性的提升。智能助手能够更自然地理解用户提供的图片与录音,实现更精准的交互;医疗影像结合语音诊断支持医生决策;自动驾驶车辆更好地融合多传感器信息响应复杂环境。尽管如此,LLM能够无训练感知视听信号也面临挑战。多模态信息的复杂性与模态间的不平衡依然令推理过程存在不确定性,同时模型对特定领域细节的捕捉能力有限。

此外,模型推断速度、算力消耗依旧是限制其大规模实际应用的瓶颈。未来发展方向将着力于优化多模态特征融合技术,提升模型对稀疏或复杂信号的敏感度,同时降低资源使用,提升实时响应能力。同时,随着模型训练数据的多样化与丰富,进一步挖掘无训练跨模态感知的潜力,有望实现更加通用且智能的多模态AI系统总的来说,LLM在无须额外训练的情况下,实现视觉与听觉能力,是人工智能领域的一项重大突破。它颠覆了单一模态AI的局限,拓展了语言模型跨模态理解的边界。随着相关技术的完善与应用场景的落地,未来的智能系统将更加灵活和智能,为社会带来更多便捷与创新。