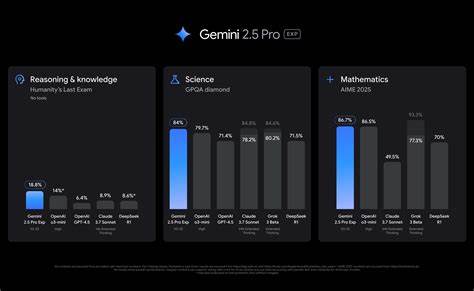

近年来,随着人工智能技术的飞速发展,多模态AI系统日益成为行业焦点。谷歌推出的Gemini 2.5 Pro多模态模型,以其强大的视觉及音频处理能力备受瞩目,为智能助理、自动化研究及安全领域带来诸多创新可能。然而,最新由业界权威安全团队进行的红队攻防研究揭示,该模型在视觉和音频输入的安全防御上存有显著漏洞,这些问题不仅关乎模型自身安全,还给部署在企业及消费者环境中的应用带来极大风险。红队研究是模拟恶意攻击者视角,深入探测系统潜在弱点的安全测试方法。针对Gemini 2.5 Pro展开的多模态红队分析,不仅涵盖了图像和语音两大核心领域,更首次从多模态结合的角度揭示了系统攻击面的大幅拓展。研究指出,Gemini 2.5的视觉攻击绕过了现有安全防护措施,成功率令人震惊。

攻击者通过精心设计的图像内容,能诱导模型生成不当或具有潜在威胁的信息。此外,音频攻击的实施门槛远低于预期。简单的声音指令或语境扰乱就能有效突破系统防线,操控AI行为。更严重的是,视觉与音频的多模态联合攻击极大增加了安全风险。这种复合型攻击不仅扩展了攻击窗口,也让防御策略复杂化,难以单一防御手段覆盖全部潜在漏洞。研究还特别揭示了Gemini 2.5内容过滤系统对化学、生物、放射性及核(CBRN)相关信息的敏感度不足,恶意内容能够成功绕过过滤机制,引发明显的安全隐患。

随着Gemini模型被广泛部署于网络代理、代码辅助工具及自动化研究系统中,其风险不再局限于单一模型输出,而是可能引发连锁反应,影响企业整体信息安全体系。攻击者一旦利用其弱点,不仅能产生有害内容,甚至能操纵联动系统执行实际操作,放大潜在损害。这一研究对于企业安全团队、AI工程师和高管层提出了明确警示。多模态AI的安全威胁不仅技术复杂,且波及面广,采取针对性防护措施刻不容缓。企业在部署包含Gemini等先进多模态模型的应用时,应高度重视红队测试结果,将安全性评估纳入开发与运营生命周期。合理引入AI风险检测、风险消除与持续监控解决方案,有助降低多模态应用的潜在安全负面影响。

伴随多模态技术逐渐成为AI产业主流,监管合规与安全管理也日趋关键。业界需要建立健全标准化的安全评估体系,推动多模态AI安全规范的制定与实施。谷歌Gemini 2.5的安全事件警示整个行业:技术革新必须紧密结合风险控制,方能实现真正的可持续发展。总结来看,Gemini 2.5 Pro的多模态红队攻防研究极大推动了人工智能安全领域的认知边界。此次研究不仅曝光了视觉与音频模式的技术薄弱环节,更揭示了多模态融合带来的安全挑战。本土及全球AI开发者和企业亟需借鉴相关成果,加强多模态AI系统的安全防护设计。

只有构建全面且细致的多模态安全防线,才能保障下一代智能系统的安全可靠运行,促进AI技术健康有序发展。随着未来Gemini系列模型持续迭代升级,安全研究工作必将持续深入,为实现更智能、更安全的AI应用提供坚实保障。