随着人工智能技术的飞速发展,Transformer架构因其卓越的表现成为自然语言处理和生成领域的基石。然而,传统的注意力机制在处理长上下文时面临诸多挑战,计算成本急剧上升,硬件资源消耗巨大,成为制约模型规模扩展与应用场景扩展的瓶颈。为了解决这一难题,全新开源项目Power Retention应运而生,成为FlashAttention的强力替代方案,带来前所未有的速度提升和硬件效率优化,彻底改变了长上下文处理的格局。 Power Retention由Jacob Buckman、Carles Gelada和Sean Zhang等专家团队于2025年9月23日发布,是一种基于硬件感知设计的高效注意力机制替代方案。它以极低的计算复杂度和极高的GPU利用率,实现了超过传统FlashAttention十倍的训练速度和百倍以上的推理速度提升,尤其在超长上下文(如64k tokens以上)场景中表现尤为突出。得益于该技术,未来可支持更加丰富的文本、视频以及跨模态数据处理,推动人工智能迎来真正的长上下文时代。

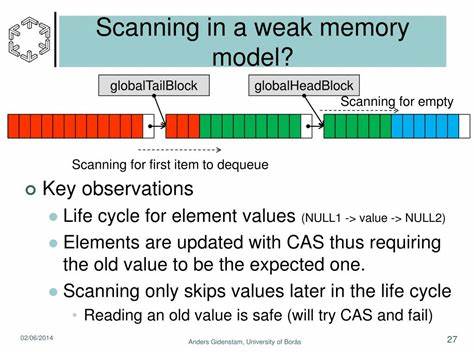

Power Retention能够实现如此卓越性能的核心原因在于其算法设计和硬件兼容性的深度融合。它不仅优化了注意力计算的内存访问和并行度,还巧妙降维,从而确保GPU资源得到最大化利用,解决了FlashAttention在极长序列处理时的GPU空闲和瓶颈问题。此外,Power Retention保持了Transformer理论上的可扩展性,用户只需将模型中的flash_attention函数替换为power_retention,便可轻松完成迁移,极大方便了开发者和研究人员的使用。 在实际应用层面,Power Retention的价值也得到了充分验证。项目团队已经成功将StarCoder2-3B模型升级为PowerCoder-3B,通过有限的再训练使模型兼容新的注意力机制,并将其开源共享于Huggingface平台。这一成果标志着大型预训练模型可平滑过渡到更高效的计算框架,有助于降低资源消耗、提高响应速度以及扩展模型上下文接受能力,为各类复杂任务提供全新动力。

开源生态方面,Power Retention不仅提供了核心的注意力机制替换工具,还推出了名为Vidrial的CUDA核开发框架。Vidrial致力于简化和提升底层GPU计算的开发效率,用户可以借助其快速编写高性能计算内核,保持前沿的硬件兼容性和加速能力。值得一提的是,利用Vidrial重新实现的FlashAttention2较现有版本性能提升了约20%,这进一步展现出该框架在优化计算架构中的潜力。 在人工智能进入人类级智慧探索时代的背景下,长时间、复杂场景的数据综合能力变得尤为关键。Power Retention不仅为模型扩展提供了技术支持,更是推动了深入理解和融合复杂信息的基础架构变革。无论是在自然语言理解、长文档生成,还是多模态融合甚至视频处理领域,Power Retention的长上下文优势都有助于实现前所未有的智能表现和应用创新。

此外,Power Retention团队积极建立开放社区和合作机制,邀请广大开发者、研究者参与讨论和实践,加速技术迭代。用户可以通过pip install retention命令轻松下载安装对应组件,享受即插即用的体验。官方提供的技术文档、研究论文和示范案例,为快速上手和深挖算法原理提供了有力支持。社区内活跃的交流氛围也为技术推广和跨领域应用打开了广阔空间。 从行业视角看,Power Retention的出现预示着深度学习模型发展进入一个效率与规模双重提升的新阶段。传统长序列处理技术往往因内存瓶颈和计算复杂度增长过快而难以满足实际需求,限制了模型对更长文本的理解能力。

而Power Retention通过硬件感知设计,不仅提升了性能,还大幅降低了能耗和成本,有助于推动绿色AI的实践,符合全球可持续发展的趋势。 未来,随着更多基于Power Retention的预训练模型问世,以及其在文本生成、问答系统、内容审核、多模态理解等多个领域的广泛应用,整个人工智能生态将迎来革新机遇。这不但激发了研究者对长上下文建模的进一步探索,也极大促进了商业应用的多样化和智能化进程。 总而言之,Power Retention以其显著的速度提升、硬件兼容性以及易用性,成为Transformer架构发展中的重要里程碑。面对知识爆炸和数据多样化的时代需求,它不仅满足了长上下文高效处理的技术瓶颈,更为人工智能系统的未来奠定了坚实基础。对于寻求提升模型性能和扩展应用场景的开发者而言,Power Retention无疑是不可错过的创新利器。

随着社区和生态的不断壮大,它必将引领长上下文处理技术迈入新的辉煌时代。 。