在人工智能技术日益普及的今天,如何高效地创建和优化AI提示词及工具定义,成为决定智能应用成败的关键因素。PromptSlice作为一款专注于上下文感知型AI提示词和工具管理的平台,正在改变开发者与AI交互的方式,带来前所未有的开发效率和产出品质提升。本文将带你深度剖析PromptSlice的核心功能及其背后的技术优势,助力你构建精准而高效的AI应用。 PromptSlice的核心优势首先体现在其实时迭代和交互优化能力。传统的提示词设计充满试错和盲目调优,浪费大量人力和时间,而PromptSlice则允许开发者在输入提示词的同时即刻观察生成结果,实时调整内容、测试边缘情况,从而快速找准最佳表达方式。这种边写边测的模式极大缩短了提示词的优化周期,避免了繁复的离线测试流程,极大提升了工作效率。

版本控制也是PromptSlice的又一强大功能。所有提示词和工具定义的改动都会被自动记录并归档,开发者不仅可以轻松追溯历史版本,比较不同版本间的性能差异,还能确保优秀提示词不会因误操作丢失。版本管理如同为提示词和工具打造了安全网,保障项目的长期稳定发展。同时,平台支持跨版本联合测试,方便开发者针对不同版本的组合进行全面评估,以找到最适合实际场景的方案。 在测试支持方面,PromptSlice提供了跨多款主流大语言模型(LLM)并行对比的功能。例如GPT-4、Claude、Gemini、Llama等主流模型均可一键参与测试。

通过自动化评估套件,平台不仅收集准确率、响应速度、调用成本等关键指标,还能根据用户自定义的指标体系,进行深度数据分析和异常判别。这样的多模型横向对比帮助开发者科学决策,避免盲目跟风,借助数据驱动来选择最优模型,保障应用上线后表现卓越。 PromptSlice同样关注提示词背后的工具定义。用户可以利用平台内置AI辅助工具,创建与优化功能函数的参数结构、描述及验证规则。基于来自行业权威研究成果的最佳实践,平台自动推荐优化建议,有效降低冗余调用率,提高工具调用效率。通过人工智能生成的高质量工具定义,团队能够实现接口的标准化与高复用性,减少后期维护难度,并在应用中实现更流畅的API交互。

为了满足不同团队和协作场景,PromptSlice支持提示词与工具定义的导入导出功能,对接OpenAPI标准,通过JSON等通用格式实现场景共享。无论是内部跨组合作,还是对外共享创意与成果,均拥有便利的操作体验。此外,用户可生成公链链接,方便展示作品给社区,实现开放而高效的知识传播与交流。 在实际应用案例中,PromptSlice通过精细设计的优化流程带来了显著性能提升。比如某技术团队将传统逐步思考式提示词优化为简洁明确的数学求解版本,结合额外高层指导逻辑后,准确率提升了20%。该团队还通过工具优化减少了上百次不必要调用,整体系统效率和响应速度明显改善,这些改进均得益于PromptSlice提供的科学迭代与评测手段。

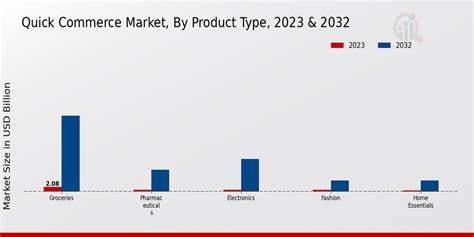

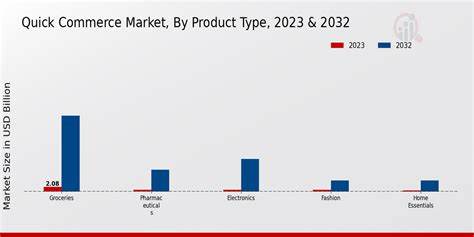

此外,平台价格和性能透明化数据也为开发者提供了决策依据。比如在多模型测试中,Claude 3.5以96%的准确率和合理的成本优势被评为最佳选择,而成本敏感项目则可能优先考虑响应最快的Llama 3。实时成本跟踪功能帮助团队在保障体验的同时控制预算,有效提升资源利用率。 PromptSlice不仅适合独立开发者,也越来越多地被企业级团队采纳。其简洁直观的界面设计及强大的数据分析功能,使得跨部门间的AI提示词管理成为可能。不同角色的成员可以在统一平台上协作,保证上下游一致的需求传递与版本同步,有助于实现企业AI产品的快速迭代和质量管控。

展望未来,随着AI应用场景的多样化和复杂化,提示词和工具定义的质量将直接影响模型生成内容的准确性和实用性。借助PromptSlice这类先进工具,开发者能够以数据为指导,系统化地理解和挖掘提示词背后的潜力,推动生成式AI技术的创新与落地。它不仅是提升开发效率的利器,更是加速智能应用实现商业价值的关键。 综合来看,PromptSlice通过集成实时迭代编辑、智能版本管理、多模型测试、AI辅助工具设计及多方协同分享,为AI提示词优化与工具定义提供了一站式解决方案。它让构建上下文感知AI变得更科学、更快捷、更高效。对于所有希望提升AI对话质量、降低调用成本、实现项目高质量交付的开发者来说,PromptSlice无疑是不可多得的利器。

未来,更多基于平台的创新功能及社区生态将不断涌现,为整个AI行业注入新的活力与动力。