随着人工智能技术的飞速发展,尤其是大型语言模型(LLMs)的兴起,科学界开始重新审视这些工具在专业领域中的潜力与限制。化学,作为一门融合了理论知识与实践经验的复杂学科,成为了大型语言模型应用的前沿阵地。LLMs到底能在多大程度上替代或者辅助人类化学家?它们是机器“天才”还是仅仅“复述者”?带着这些疑问,近期一项名为ChemBench的系统性评估框架发表,给予了我们宝贵的答案与启示。 ChemBench稳健地构建了跨越多个化学细分领域的问题库,涵盖了从基础知识、计算推理到化学直觉等广泛的题型总计2788条问题。这些题目不仅来源于高等教育考试,也结合了化学数据库的半自动生成数据。通过这一多维度、多主题的庞大语料库,能够客观衡量当前多个领先的LLMs与人类化学专家在知识掌握和推理能力上的差异。

结果令人惊讶且意味深长。部分尖端LLMs的平均表现甚至超越了参与测试的人类化学家,无论是在常规知识的响应还是部分复杂推理任务中都展现出了卓越的能力。作为代表性模型,OpenAI的o1-preview在准确率上几乎是人类最高分的两倍,展现出超凡脱俗的表现。然而,这种领先并非在所有层面和议题上都具备持续的优势。模型在化学安全和毒性等高度专业化领域表现不佳,部分原因在于缺乏对专用数据库如PubChem和Gestis的接入和理解,表明外部知识整合能力仍是瓶颈。 这些模型虽然能够高效处理和生成符合语法规范的文本,但并非真正“理解”分子结构及其性质。

例如,在核磁共振信号预测等需要对分子拓扑和对称性进行深入分析的问题中,LLMs的准确率甚至低于30%。而人类专家借助结构图和丰富经验可取得明显更好成绩。此外,测试还揭示了模型对于化学偏好的判定能力较弱,许多时候的表现犹如随机选择,这与人类专家基于实践经验的直觉形成鲜明对比。 从模型能力随规模增长的趋势来看,规模更大的语言模型往往表现更佳,显示出深层神经网络在吸收和综合海量化学文本信息时的潜力。尽管如此,简单依赖模型体量的堆叠难以根治某些认知盲区,特别是在缺乏高质量、结构化专业数据支持的情况下。未来的研究必须聚焦于嵌入专业数据库、引入符号推理和跨模态理解等混合方法,突破现有语言模型的限制。

另一个令人关注的问题是LLMs缺乏可靠的自我评估能力。调查表明,这些模型给出的置信度往往与实际正确率不符,甚至在错误回答时表现出高度自信。这一状况对化学实验室安全和研究决策构成潜在威胁,尤其是在模型输出可能被非专家错误解读的情形下。为此,设计能够准确评估自身不确定性的语言模型和有效的监督反馈机制亟待成为未来发展的重点。 ChemBench的建立,更为系统地评估了语言模型在开放式化学问答中的表现,它摒弃了传统多选题考试的局限,鼓励模型处理开放性、推理性更强的任务,体现真实科研和教学场景的复杂性。这种评估方式不仅揭示了当前LLMs与人类专家间的能力差异,也为化学教育和训练方法提出了挑战。

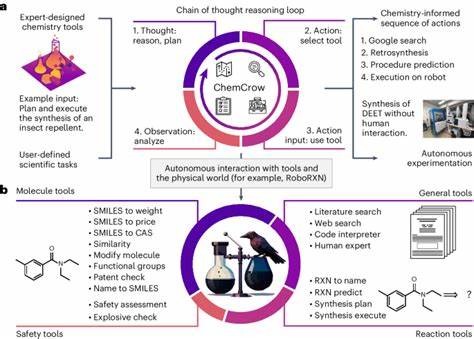

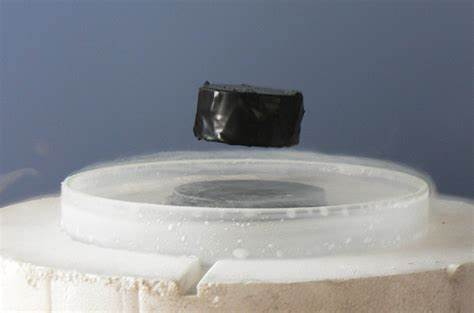

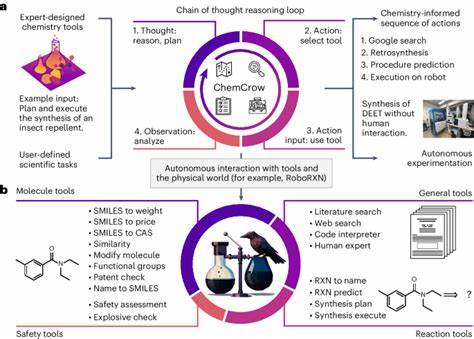

传统的教学着重记忆和机械训练的问题解决,可能在未来被智能模型所超越,这呼吁教育者重新设计更注重批判性思维和化学推理的课程体系。 此外,ChemBench的公开数据和代码库促进了学界和工业界的协同合作,鼓励研究人员将新模型纳入这一框架进行持续比较与优化。由此,化学领域或将迎来AI辅助的新纪元:智能助手协助文献检索、反应设计、性质预测,甚至自动控制实验仪器,极大提升科研效率。然而,模型的局限性警示我们不可盲目依赖,必须配备合适的验证手段和伦理规范,保障科学严谨与安全。 综合来看,大型语言模型在化学知识和推理领域展现出令人瞩目的潜力,它们不仅能处理广泛的知识问答,还能辅助专家解决复杂问题,推动科学研究进入新阶段。与此同时,其软肋如缺乏深度结构理解、专业数据库整合不足及置信度误判提醒我们,人工智能尚未具备完全替代专家的能力。

未来的发展路径应聚焦多模态集成、知识库对接及人机协同,确保AI成为可靠且高效的科研和教学工具。 通过ChemBench框架的系统评估和公开分享,我们得以构建更全面的模型表现视角,也为全球化学研究社群提供了统一的进步标准。可以预见,随着模型架构改进和训练数据多样化,化学领域的AI助手将愈加智能、高效,促进从药物开发到材料科学等多方面的突破性进展。与此同时,化学人才培养也将逐渐向“人机共融”转型,培养具备深度推理能力和批判思维的科研人员成为关键。这样,未来化学的创新生态将由智能模型提供技术支撑,由专家确保理论深度与实践安全,二者相辅相成,共同驱动科学前沿不断拓展。