人工智能技术在当今社会的广泛应用已成为不可逆转的趋势。无论是自动化办公、智能分析,还是内容创作,人工智能都大幅提升了效率,改变了我们的工作和生活方式。与此同时,关于“心智捐赠”的讨论也逐渐兴起,尤其是在新闻领域和信息传播中,这一概念逐渐引发了深层次的思考。所谓“心智捐赠”,可以理解为人们在使用AI工具时,某种程度上将自己的判断能力和认知权重交付给机器,这不仅体现了对技术的依赖,也反映了人类对于事实核查和信息真实性的复杂态度。围绕这点,媒体记者、法律从业者乃至一般信息消费者都面临着如何平衡使用便利与认识风险的挑战。人工智能的“幻觉”问题是焦点之一,即AI系统生成的信息并非总是准确无误,时常掺杂虚构或错误内容。

然而,部分专业人士对此持乐观态度,认为这主要是“能力问题”,通过不断熟悉模型运行逻辑和特点,可以逐渐减少这类错误的出现。事实上,对于从事专业写作或研究工作的人来说,掌握AI工具的习惯和特性,形成基于经验的使用直觉,是确保输出内容准确且有价值的关键。举例来说,有报道指出,一位资深记者在利用大型语言模型进行稿件核查时,既利用AI自动发现文字、语法以及事实类错误,又同时坚持用传统方法如全文搜索(command-F)对AI给出的结论进行人工确认。虽然这看似多此一举,却很大程度上保证了信息的真实性。但这也引发了一个值得深思的问题:如果AI工具本身可能出现内容错误,人们依赖它们进行事实验证时,如何确保验证结果的正确性?这其实反映出人工智能技术仍处于进步的阶段,它不是万能的真理机器,而是一种辅助工具。对于常规用户而言,完全信赖AI将极大增加信息误用的风险。

一旦将错误内容不断传播,就可能引发社会层面的误解乃至混乱。更为深远的是,这种现象影响了新闻报道乃至历史叙述的公正性和准确性。正因如此,专家们强调,任何AI生成的结论都必须由具有判断能力的用户亲自审视和核实。换句话说,人的理性和批判思维始终不可或缺。与此同时,市场与技术的交织同样带来了新的矛盾。某些AI公司的高管表态,坚称他们的系统“比人类更少出现幻觉”,但这种言论往往缺乏坚实数据支持,更多是在推销自家产品。

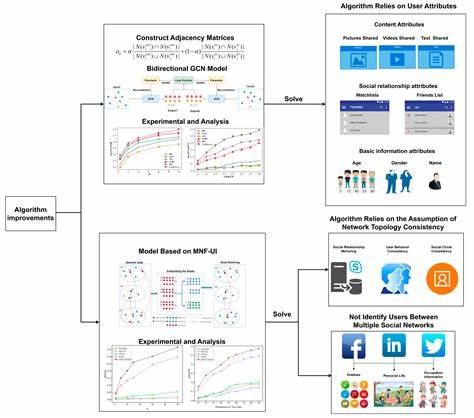

这使得外界对AI性能的认知出现混淆,增加了理性判断的难度。面对此情形,用户除了自身增强识别能力外,也需要更多透明的数据和第三方评估,帮助建立对AI输出内容的信任边界。另一层面来看,心智捐赠还映射出现代社会对于技术依赖的普遍状态。不少人在面对海量信息时,为了节省时间和难以驾驭复杂数据的无力感,倾向于将决策部分交给算法判断。这种行为虽便利,但长远来看可能弱化个体的思考能力,甚至导致集体认知的偏差。针对这一问题,教育、企业管理乃至政策制定机构应推动形成“人机协作”的新范式,即让人工智能成为增强而非替代人类智力的助力。

在实际应用中,应倡导用户保持怀疑精神,将AI视为“智能助理”,而非唯一公正先锋。不仅如此,业界还需不断优化算法模型,减少幻觉发生率,提高语义理解和事实检验的准确度。同时,加强用户的教育和引导,使其了解AI的局限性和操作技巧,形成科学合理的使用习惯。未来,随着技术的持续进步,心智捐赠的含义也许将被重新定义。它可能不再是简单的依赖,而是人机智慧融合的体现。人们在保留独立思考的基础上,通过技术工具实现信息处理和决策效率的质变升级。

回望当前阶段,面对AI带来的核查便利与信息错误风险并存的现实,我们更应该关注如何打造完善的监督机制和透明度标准,避免盲目心智捐赠带来的潜在危害。只有这样,社会才能有效利用人工智能的巨大潜能,而不是因信任缺失或过度依赖而陷入认知陷阱。总之,人工智能的运用已经渗透进各个领域,改变了人们获取和处理信息的方式,而“心智捐赠”则是其中引人注目的现象。它既蕴含着技术赋能带来的可能性,也提醒我们保持审慎与批判的视角。未来,需要的是技术开发者、专业人士和普通用户三方的共同努力,确保人工智能成为人类智慧的有益补充,而非独立操控的工具。只有如此,人工智能才能在信息时代真正发挥积极作用,促进社会的健康发展和认知进步。

。