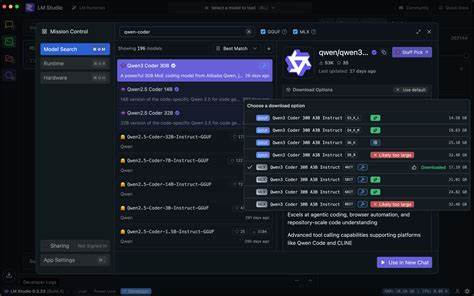

随着人工智能技术的不断进步,开发者对于高效、私密且无网络依赖的编码解决方案需求日益增长。Cline与LM Studio结合Qwen3 Coder 30B,打造出强大且完全本地化的编码堆栈,开辟了AI辅助编程的新纪元。本文深入分析这一本地编码方案的核心架构、运行机制及其在实际开发中的突出表现,助力研发人员充分了解并合理应用这一技术创新。 Cline是一款专为代码编辑器Visual Studio Code设计的智能编码代理,其通过集成先进的大型语言模型,实现自动分析代码库、生成代码片段以及执行终端命令等功能。而LM Studio则担当模型运行时环境,负责模型的托管和推理支持。Qwen3 Coder 30B作为该架构的智能核心,是一款拥有300亿参数的强大语言模型,经过专门优化,能够高效处理大规模代码理解与生成任务。

令人瞩目的是,Qwen3 Coder 30B采用的MLX格式对Apple Silicon芯片进行了深度优化,使得在Mac设备上本地运行性能大幅提升,甚至可以媲美部分云端服务。这意味着开发者无需依赖远程API,就能在自己的笔记本电脑上享受强劲、低延迟的智能编码体验。同时,Windows及其他平台用户也可以通过GGUF格式获得卓越性能,保证跨平台的广泛适用性。 在实际使用中,开发者首先通过LM Studio下载安装所需的Qwen3 Coder 30B模型,并根据硬件配置选择合适的量化版本。量化技术通过降低模型权重的精度,有效压缩模型体积和运行内存,提升推理速度,同时尽可能保持模型精准度。常见的4-bit量化在性能和质量间达到最佳平衡,而对于拥有更大内存的用户,5-bit或6-bit版本则可提供更高的推理精度。

配置完成后,用户在LM Studio的开发者面板启用模型服务器,并保持状态为"运行中",通常接口地址为本地的http://127.0.0.1:1234。接着,将Cline插件设置为以LM Studio为模型提供者,模型名称选择qwen/qwen3-coder-30b,保持与LM Studio一致的调优参数,包括最大上下文长度262,144个token,确保能够处理大规模代码库。 值得注意的是,为了优化本地模型的缓存和推理效率,Cline强烈建议启用"紧凑提示"模式。这种提示设计将系统提示压缩至原先的约十分之一,极大提升了本地推理的资源利用率,尽管因此失去对部分高级特性如MCP工具、Focus Chain及MTP的支持,但换来了更加流畅和稳定的本地运行体验。与此同时,LM Studio中应关闭KV Cache量化功能,避免上下文信息在任务间意外累积导致不确定行为。 这一本地化架构为开发带来的最大优势在于完全脱离网络环境,消除了API调用费用以及潜在数据泄露风险。

无论是在信号微弱的偏远地区,还是对安全性要求极高的机密项目,开发者都能自如开展编码工作。并且,随着模型及推理性能的持续优化,长达数十万token的海量上下文处理能力使得针对大型软件仓库的分析和重构成为可能,同步提升了开发效率和代码质量。 用户反馈表明,基于Apple Silicon硬件配置的Mac用户体验尤为出色。模型初次加载存在一定的预热时间属正常现象,后续推理速度稳定且响应迅速。对于超大项目,建议开发者将任务分阶段进行,或调整上下文窗口大小,以避免因持续推理带来的性能衰减。 除此之外,离线模式的成本优势十分明显。

在无需依赖云端API的前提下,用户只需一次性下载模型即可无限制使用,显著降低了使用门槛和长期开销。这对于教育培训、个人开发者乃至中小企业而言,都是极具吸引力的经济解决方案。 当然,云端编码服务依旧在超大规模项目、多小时连续重构以及多用户团队协同方面保持一定优势。云服务通常提供更大容量的上下文资源和统一的硬件环境,保障多样化团队一致的开发体验。因而,本地与云端模型在应用场景中各有侧重,用户可以根据项目需求和软硬件条件灵活选择。 面对可能遇到的技术问题,官方与社区均提供了详尽的支持文档和解决方案。

当Cline无法连接LM Studio时,一定要确认模型服务器是否正常启动,且相关设置是否正确。确保"紧凑提示"开启且LM Studio中KV Cache量化关闭是保证模型响应正常的重要环节。如遇性能下降,尝试重启模型或减少上下文大小均是有效手段。 总结来看,Cline携手LM Studio和Qwen3 Coder 30B代表了本地AI辅助编码的未来趋势。它不仅赋能开发者实现离线、高效且隐私安全的编程环境,更推动了人工智能与软件开发深度融合的生态建设。对于追求自主可控、安全合规的开发团队而言,这套全本地化编码堆栈将是不可或缺的利器。

随着技术日益成熟和社区活跃,相关工具链的易用性与智能化水平也将不断提升。期待未来,更多功能优化与模型创新加入,为本地AI编码带来更强的计算能力、更流畅的用户体验和更广泛的应用场景,真正实现开发者的无限创作潜能,开创智能编程的新篇章。 。