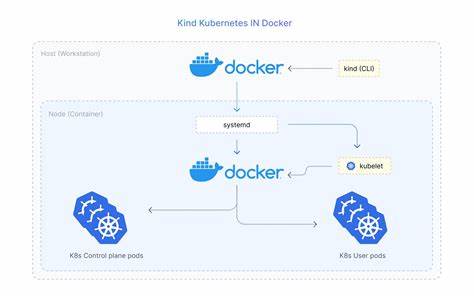

Kinc是一个将完整Kubernetes运行环境打包在容器内的开创性项目,核心目标是让开发者在无需root权限的普通用户环境下快速构建单节点或多实例的Kubernetes集群。通过将systemd、CRI-O、kubeadm与kubectl等关键组件放入同一个容器镜像,Kinc实现了自包含、可重复和便捷的本地集群部署体验,适合开发调试、CI验证以及面向小规模环境的演示与教学场景。对比传统的minikube或kind,Kinc强调"rootless"与网络隔离,利用Podman的用户命名空间和容器卷管理来减少对宿主机的侵入性改动,同时保持对官方Kubernetes工具链的兼容性与可信度。 Kinc的设计围绕几个关键特性展开。首要的是速度与便捷性:在已缓存镜像的条件下,一次部署通常可以在几十秒内完成,极大降低了试验新配置或多次回滚的成本。其次是无根运行:使用Podman的rootless模式与用户空间资源隔离,避免了对宿主机root权限的依赖,这对安全性与多租户开发者机器尤为重要。

再次是自包含架构:把CRI-O和kubeadm等组件打包进容器镜像,确保不同机器上部署时能获得一致的运行环境。最后是网络与端口管理的可预测性:Kinc采用顺序端口分配与基于端口派生的子网策略,保证并行运行多个集群时不会发生网络冲突。 部署Kinc之前需要确认宿主机环境满足若干系统要求。Podman 4.0以上是基本条件,因为rootless运行和cgroups的处理依赖Podman的新特性。内核版本建议不低于5.10以保证用户命名空间和cgroups v2的兼容。对于多集群场景,需要提高inotify和内核keyring的限制,这是因为同时运行多个容器化的systemd和kubelet实例会消耗更多的内核资源。

启用IP转发与适当的sysctl配置同样重要,用于容器内网络转发和集群之间的连通性。硬件上,单个集群建议至少2核CPU和2GB内存,多个集群并发运行时按每个集群预留资源增长即可。 在部署流程层面,Kinc通过一套systemd驱动的多服务初始化流程来保证集群启动的可靠性。容器启动后,kinc-preflight服务会首先进行配置校验、CRI-O的可用性检查并生成或模板化kubeadm配置文件。随后触发kubeadm-init服务执行kubeadm init以初始化控制平面,服务设计为孤立执行以防止外界条件干扰。最后kinc-postinit服务负责安装CNI插件(使用kindnet)、创建存储供应器并等待核心服务就绪。

整个过程会在成功完成后写入初始化标记,供脚本或外部工具快速判断集群是否可用。 网络隔离是Kinc的亮点之一。端口采用顺序分配策略,例如默认集群使用本地回环的6443端口,后续集群依序占用6444、6445等端口。基于端口的子网派生规则把Pod网段与服务网段映射到唯一、不重叠的子网,例如根据端口最后两位生成10.244.xx.0/24形式的Pod子网和10.xx.0.0/16形式的Service子网。这样的策略在需要同时运行多个开发或测试集群时,能有效避免网络冲突并简化路由与端口转发的管理。对于需要自定义网络的高级用例,Kinc也允许通过挂载自定义kubeadm配置来修改Pod或Service网段。

多集群并发运行是Kinc面向团队和CI场景的重要功能。通过配置卷挂载模式,每个集群可以使用独立的配置、数据卷和端口分配,互不干扰。为确保多集群场景的可用性,Kinc在部署脚本中增加了对系统限制的检测,当检测到inotify或kernel keyring不足以支持并发集群时会给出明确提示并中止部署,避免出现难以调试的运行时故障。若因环境受限需要绕过安全检查,工具也提供了可选的跳过参数,但官方建议仅在实验环境中谨慎使用。 Faro事件采集是Kinc提供的一个可选观测功能,旨在帮助开发者与CI管道捕获集群引导阶段的资源事件与性能数据。Faro以静态Pod的方式在API服务器邻近运行,捕获kubelet和控制平面的事件并写入容器卷中的JSON日志。

启用后可以在宿主机上直接读取这些日志进行事件梳理、性能分析或作为回归测试的一部分。默认情况下出于性能与存储考虑,Faro在常规部署中关闭,但在CI和验证流程中通常开启以辅助问题定位与稳定性评估。 在日常使用中,Kinc的操作可以通过两类模式完成。一类是"baked-in"零配置模式,这种方式把默认的kubeadm配置嵌入到镜像中,适合快速启动单一集群并用于演示或本地开发。另一类是挂载配置模式,允许用户把自定义的kubeadm配置文件挂载到容器内,从而支持多集群、定制化网络和特性门控的场景。挂载配置的灵活性使得团队能够在同一宿主机上并行运行多套不同版本或不同参数的集群,非常适合做升级回归测试或多环境验证。

故障排查方面,Kinc将日志与服务管理放置在容器内部的systemd中,因此常见的排查路径包括检查kinc-preflight、kubeadm-init与kinc-postinit三大服务的日志。CRI-O与kubelet的日志也被保存在容器的journal中,方便在出现镜像拉取失败、镜像签名问题或CNI插件安装失败时快速定位原因。常见问题还包括端口占用,这通常是由于宿主机上已有相同名称或端口的容器实例运行导致的,解决方法是更换集群名称以触发不同的端口分配或手动指定强制端口。IP转发未启用和sysctl限制不足是另一类常见阻断因素,对应的解决方案是在宿主机上通过sysctl持久化配置并重启网络子系统。 与其他轻量级Kubernetes解决方案的比较有助于理解Kinc在生态中的定位。Minikube以虚拟机或容器驱动提供本地Kubernetes,而kind通过Docker容器实现多节点测试环境。

与这两者相比,Kinc的独特之处在于其rootless和自包含的单容器systemd架构。Kinc更接近于将一个完整的控制平面与运行时一起封装,使运行时依赖最小化且更接近真实生产环境中使用的CRI-O与kubeadm组合。对于需要在不具备root权限的受限环境中运行控制平面的团队,或希望在CI中快速启动官方工具链进行验证的场景,Kinc具有明显优势。但如果需要多节点分布式拓扑或复杂网络插件测试,kind或真实云环境可能仍然更合适。 在安全性方面,Kinc的rootless模式降低了对宿主系统的潜在破坏面,容器运行在普通用户的命名空间内,减少了因容器逃逸导致的root级别入侵风险。然而,容器内部仍需要较多的能力与设备访问来运行CRI-O与systemd,例如某些capabilities和设备节点,这要求在部署时仔细审查容器运行时的权限配置。

对于更严格的安全需求,建议将Kinc限制在受控的开发或CI环境,并结合主机级别的安全策略、容器运行时的seccomp与SELinux配置来缓解潜在风险。 性能与资源管理方面,Kinc对资源的要求与运行完整控制平面的Kubernetes一致,因而在资源受限的开发机器上运行多个并发集群可能导致性能瓶颈。为达到平衡,可以在CI中采用短生命周期的集群实例来进行并行测试,或通过限制每个容器的cgroups资源来避免宿主机过载。Podman的cgroups分离功能在此提供了便利,能够把不同集群的资源用量隔离开来,从而减少互相干扰的可能性。 集成与持续交付方面,Kinc天然适合嵌入到CI管道中以验证kubeadm升级路径、网络插件兼容性或自定义控制器行为。由于使用的是官方的kubeadm和CRI-O版本,测试结果对上游兼容性具有较高的参考价值。

CI中的典型工作流会在构建完成后拉取Kinc镜像、在受控运行器上启动若干短生命周期集群、运行验证套件并收集Faro事件或日志作为稳定性指标。清理脚本确保在每次流水线结束时删除卷和容器,保持运行器干净,避免资源滞留影响后续任务。 对于想要从零开始尝试Kinc的开发者,建议先在单一集群模式下熟悉部署、登录容器并查看systemd服务的运行情况,以理解kubeadm的初始化过程和kindnet的工作机制。随后可以尝试挂载自定义kubeadm配置来调整特性门控或网络段落,验证在不同配置下集群的行为。若计划在本地并行运行多个集群,务必先调整宿主机的inotify与kernel keyring限制,并为Podman配置必要的存储卷路径以避免数据冲突。 总结来看,Kinc将Kubernetes的复杂性封装在一个容器化的可复用单元中,提供了一条在无root权限环境下安全、快速搭建控制平面的捷径。

其多服务的systemd初始化流程、顺序端口与子网派生策略以及可选的Faro事件采集,使其在开发、测试与CI场景中具有很强的实用性。理解其运行原理、系统需求与故障排查路径,可以帮助团队更高效地利用本地资源进行版本验证、插件兼容性测试与快速原型迭代。对于寻求在受限环境中运行接近生产的Kubernetes工具链的开发者,Kinc提供了一种平衡便捷性、可重复性与安全性的实用方案。 。