在当今人工智能领域,多模态模型的兴起引起了广泛关注。所谓多模态AI,指的是能够同时处理和理解多种数据形式的智能系统,尤其是视觉与语言的结合。这种融合使得AI不仅能够“看见”世界,还能“读懂”语言,从而实现更加丰富和自然的人机交互。本文将深入探讨125款多模态AI模型如何实现视觉与语言的融合,揭示其背后的技术原理、创新点以及实际应用,助力读者全面了解这一领域的前沿进展和潜在价值。 多模态AI的发展基础源于传统的计算机视觉和自然语言处理技术。计算机视觉关注图像和视频的识别、理解与生成,而自然语言处理则致力于解析和产生人类语言。

当这两者相结合时,系统能够通过视觉信息辅助语言理解,或者利用语言上下文增强视觉分析。125款多模态模型的出现,充分体现了这一技术融合的发展趋势,它们不仅在结构设计上各具特色,还在数据融合策略、训练机制以及解码方式上展现出多样化。 这类多模态模型通常依托大规模预训练技术,结合视觉编码器和语言编码器,以共享或协调的嵌入空间实现信息融合。视觉部分多采用卷积神经网络(CNN)、视觉变换器(Vision Transformer)等架构来提取图像特征,语言部分则借助变换器结构(Transformer)完成文本理解。两者在模型内部通过注意力机制相互作用,保证视觉信息可以有效影响语言生成或理解过程,反之亦然。以视觉问答(Visual Question Answering, VQA)为例,模型需要同时理解图像内容和自然语言提问,并生成准确的文本答案,这正体现了视觉与语言深度融合的能力。

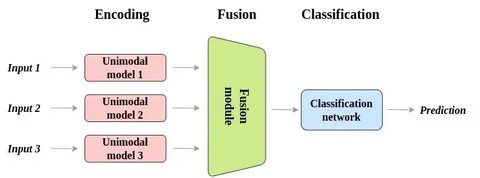

此外,不同模型在融合策略上有所区别。一部分采用早期融合,通过将视觉和语言特征在输入阶段拼接,联合编码;另一部分利用中期融合,在编码过程中进行多层交互,使两种模态之间的信息动态交换;还有晚期融合的方法,先分别编码两类数据,最后通过融合层整合结果。不同的融合方式对应着不同的性能表现和计算成本,研究者需要根据具体应用场景权衡选择。跨模态对齐技术也是关键环节之一,通过优化视觉和语言特征空间的一致性,提升跨模态检索和生成的准确度。 训练这些多模态模型需要大量多样化的数据支持。典型的数据集例如MS-COCO、Visual Genome、Flickr30k等,涵盖了图像及其对应的文本描述、标签或问答,促进模型学习视觉与语言之间的丰富关系。

近年来,随着多模态大模型的发展,训练数据不仅限于图文对,还包括视频与语音、图文与知识图谱等,模型的通用性和适应性大幅提升。例如,利用跨域数据扩展模型的表达力,实现从静态图像到动态场景的理解和语言生成。 这些模型的应用场景异常丰富。在智能助手领域,多模态模型通过理解用户的自然语言指令和视觉信息,实现更智能的人机互动。诸如图像描述生成、视觉内容检索、自动字幕生成、智能监控和辅助驾驶等,都深度依赖于视觉与语言融合的能力。在医疗领域,通过多模态模型辅助诊断,结合医学影像和文本报告,提高诊断准确率和效率。

教育领域则利用多模态交互系统提升学习体验,使机器能够根据学生的视觉输入和语言表达提供个性化辅助。 从技术角度来看,125款多模态模型展现了诸多创新亮点。例如,结合生成式预训练模型与视觉特征,实现更高质量的文本生成和图像理解;引入跨模态注意力模块,增强信息交互;开发轻量化结构,适应移动设备部署需求;以及探索无监督和自监督学习策略,减少对标注数据的依赖。此外,模型解释性和公平性问题也逐渐成为研究重点,以确保AI系统的可信赖性和社会接受度。 未来,多模态AI模型仍面临多重挑战,包括模态间的信息不对称、数据质量参差不齐、计算资源消耗巨大等。如何提升模型的泛化能力和实时响应速度,降低训练与推理成本,将成为核心难题。

同时,多模态融合的深度与广度都需进一步拓展,支持更多复杂任务和多样模态的无缝交融。跨模态对话、情感理解、知识增强以及迁移学习等方向展现出巨大潜力。 作为人工智能发展的重要趋势,多模态融合技术不仅丰富了AI的认知能力,也为构建更加自然、智能和人性化的交互系统奠定基础。125款多模态模型的深入分析,有助于业界理解当前技术瓶颈与突破口,推动更多创新方案的涌现。随着计算能力和算法优化的不断推进,未来多模态AI将在智慧城市、自动驾驶、医疗健康、教育培训等诸多领域发挥更加核心的作用,助力实现智能社会的愿景。