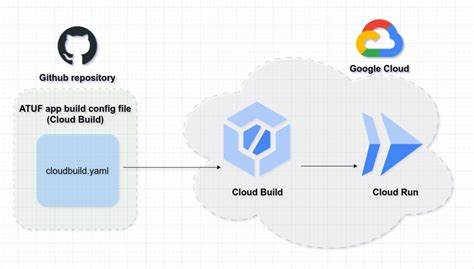

随着云计算和人工智能技术的快速发展,开发者面临着如何将复杂的本地应用程序无缝迁移到云端的挑战。特别是涉及多容器应用和智能代理应用时,传统的部署方式往往需要繁琐的配置转换和重复性工作。Google Cloud推出的gcloud run compose up功能,彻底简化了这一过程,使得开发者可以直接将现有的compose.yaml文件一键部署到Cloud Run环境,实现从本地开发到云端托管的无缝过渡。 Compose.yaml作为Docker Compose背后的核心规范,长期以来都是开发者管理、构建和测试多容器应用的重要工具。通过对Compose规范的支持,Cloud Run现在可以更好地匹配开发者习惯的配置格式,极大提升了云端部署的一致性和便捷性。利用gcloud run compose up,用户不再需要手动转换Compose文件或重新配置云端服务,节约了大量时间和出错风险,从而专注于应用的功能开发和性能优化。

gcloud run compose up不仅支持将应用容器镜像从源码构建并推送到Cloud Run,还能支持存储卷的挂载,实现数据的持久化存储。这为运行状态依赖数据的应用提供了坚实保障,尤其适合处理大量图片、日志或模型文件的AI应用场景。通过与Cloud Run的无服务器架构结合,应用可实现按需自动扩缩容,避免资源浪费,同时保障用户体验的稳定和响应速度。 针对AI和机器学习领域,Cloud Run进一步引入了GPU支持,满足了深度学习模型推理和训练所需的大规模计算资源需求。结合Docker Compose新增的模型(models)定义属性,可以直接在compose.yaml文件中指定AI模型及推理端点,简化端到端的智能代理应用部署流程。开发者可以通过单一命令快速从本地完成模型构建、容器化及推理服务上线,无需额外手动配置复杂的AI基础设施环境。

除此之外,Cloud Run的计费模式基于按秒计费和自动按需扩缩容的Serverless架构,更加灵活经济,支持用户根据业务流量变化动态调整计算资源。支持快速启动能够满足高并发请求,提高AI模型的响应效率,尤其适合推理时间敏感的应用场景。比如,Google的Gemma3-4B模型在Cloud Run上约19秒即能完成首次Token的响应,极大提升了AI服务的用户体验。 此次Google Cloud与Docker的深度合作,标志着云端部署技术的新突破。Docker技术团队也表示,通过支持Compose规范中的agentic(代理)应用及GPU加速,能够协助开发者更加快速地从本地迭代转向大规模生产,实现AI原生应用的开发和部署一体化。 对于开发者而言,gcloud run compose up功能的推出意味着开发和生产环境之间的鸿沟大幅缩小。

开发者可以继续在熟悉的本地环境中使用Docker Compose定义和测试复杂应用,再通过一条命令推送到Cloud Run,享受到高效、安全和弹性的云端运行环境,从而极大地简化了DevOps流程和持续交付机制。 此外,支持官方开放的Compose Specification标准,体现了Google Cloud致力于拥抱开放源代码社区的态度,并为开发者在多样化技术栈间的迁移提供支持。无论是传统的微服务架构,还是复杂的AI驱动型应用,gcloud run compose up都能提供兼容且灵活的运行基础。 未来,随着AI应用越来越多地渗透到各类云端场景,使用gcloud run compose up实现从本地多容器组成的AI应用到云端原生环境的快速部署,将成为提高研发效率和缩短产品上市周期的重要利器。开发者无需担心不同环境的配置差异带来的隐患,节省手动部署的时间成本,可以聚焦于模型优化和服务能力提升。 总结来看,gcloud run compose up代表了Google Cloud在Serverless云托管和AI应用部署领域的一项关键创新。

它不仅为传统Docker Compose的用户带来了极大的便利,也推动了AI应用开发平台的持续演进。无论是初创企业还是大型组织,都能够借助该工具快速实现从本地验证到云端高可用运行的顺畅过渡,加速智能应用的商业化落地。未来,随着功能的不断完善和用户基数的扩展,gcloud run compose up有望成为云原生开发与部署生态中不可或缺的核心组件。 作为正在探索云端创新与AI应用的开发者,积极关注并参与gcloud run compose up的预览和使用,将具备领先行业的技术优势和开发体验。借助Google Cloud与Docker的合作成果,您可以更专注于构建高质量的智能应用,征服更加复杂多变的业务场景,开启云端AI应用的新征程。