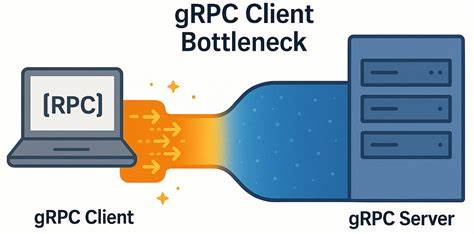

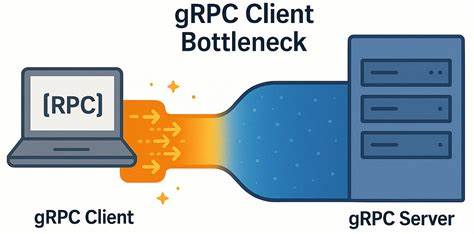

随着分布式系统和微服务架构的普及,gRPC作为一种高性能远程过程调用框架,因其高效、健壮和易用性受到广泛关注。尤其在低延迟网络环境中,gRPC理论上能够发挥极致性能,支持大规模、高并发的请求处理。然而,在实际应用中,YDB团队通过深入的性能测试发现,即使网络条件理想,gRPC客户端仍存在显著的性能瓶颈,导致系统资源浪费和响应延迟增加。本文将围绕这一起初令人意外的性能瓶颈展开全面分析,分享调试过程、技术细节以及解决方案,帮助开发者更好地理解和规避类似问题,从而提升分布式数据库和服务间通信的整体性能。 gRPC基于HTTP/2协议,通过多路复用实现单个TCP连接上多个RPC流的复用,理论上大幅减少连接调度开销,提升通信效率。客户端通过创建一个或多个gRPC通道(channel)与服务器建立连接,通道可承载多个流。

然而,gRPC在默认配置下对每个TCP连接可承载的并发流数量有限(默认通常为100),当客户端并发请求数超出此限制时,额外请求会被排队等待,导致整体延迟被拖高。YDB团队的研究表明,这一机制在负载较小且网络延迟极低时,更容易被忽视,却成为整体性能瓶颈的关键所在。 为了探索和验证这一瓶颈,团队设计并实现了一套基于最新gRPC版本(v1.72.0)的微基准测试程序。该测试包括异步服务器和同步客户端两部分,模拟高频次ping请求以测量吞吐量和响应延迟。服务器端配置合理,配备多完成队列和工作线程,确保处理能力充足。测试环境位于两台物理机上,CPU资源充裕,网络条件优异,传输速率达50Gbps,往返时延仅在几十微秒范围内。

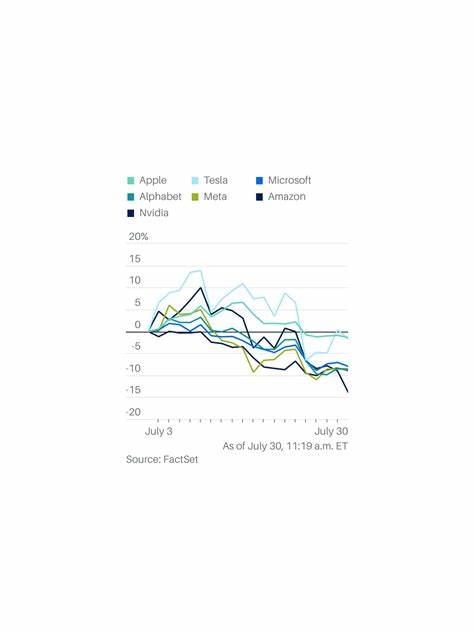

理想情况下,应能实现线性扩展的吞吐量和极低的响应时间。 实际测试结果却与预期大相径庭。随着客户端并发请求数量(in-flight请求数)增加,吞吐量提升明显受限,远低于理论线性增长。与此同时,中位数及高百分位响应延迟呈现显著上升趋势,远超过网络传输延迟本身。更为重要的是,深入监测发现,无论增加多少客户端通道,实际的TCP连接数始终维持在单一连接上,表明所有流均在同一TCP连接内复用。网络层面无拥塞、无延迟确认等异常,服务器响应迅捷,唯一明显的延迟则存在于客户端发送下一批请求的间隙,大约为150至200微秒。

由此推断,瓶颈主要源于客户端gRPC库内部的请求调度机制及HTTP/2流复用实现。 进一步调试确认,gRPC默认的客户端实现存在类似队列机制,当某条TCP连接上的并发流临近上限时,新建请求会排队等待先发流释放资源。在低延迟环境下,出于尽可能复用连接的设计初衷,客户端倾向于复用同一连接,导致有效并发请求无法充分分布,触发内部排队,限制了整体并发处理能力。从性能角度讲,这意味着客户端单个连接成为瓶颈,整体系统吞吐量受阻,响应延迟陡增。 基于官方性能最佳实践,解决方案主要有两类:其一是为应用中不同高负载区域创建独立的gRPC通道,从而利用多个TCP连接分散负载;其二是维护多个通道池,动态调度请求跨通道发送,避免单一连接瓶颈。YDB团队测试表明,单纯增加客户端通道数量但保持通道参数不变,无法突破复用单连接的限制,瓶颈依旧存在。

唯有为各通道指定不同参数,确保每个通道独立维护连接资源,或启用GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,才能实现多连接并行,充分发挥网络带宽和计算资源,显著提升性能。 经过优化调整后,基准测试显示客户端吞吐量提升近6倍,响应延迟增长趋势大幅放缓,尤其在高并发场景下的延迟表现出更好的稳定性。此外,流式RPC的性能也得到显著改善。对比5毫秒延迟网络环境,优化效果虽然不及低延迟网络明显,但仍然保持一定优势,强调了在极低延迟环境下优化客户端连接策略的重要性。 此实验带来一系列启示。首先,低延迟网络中,客户端自身内部机制可能成为系统性能的主导瓶颈,而非网络或服务器端。

其次,合理的多通道管理策略能够有效分散负载,消除单连接排队瓶颈,从而实现高吞吐量与低延迟的平衡。最后,gRPC官方最佳实践应结合具体应用场景评估,单纯依赖默认配置或忽视连接管理将影响系统性能表现。 综上所述,gRPC作为现代分布式系统的核心通信技术,虽然在设计上针对网络效率进行了优化,但客户端内部连接管理和流控制机制亦不可忽视。针对低延迟网络环境,开发者应合理规划通道数量及参数,避免因单连接限制而造成的性能瓶颈。YDB团队分享的微基准测试工具和调优经验为业界提供了宝贵参考。未来,进一步探索gRPC内部实现细节和并发模型,研制更智能的负载分发机制,将有助于推动gRPC生态系统在极限性能场景下的持续提升。

随着分布式数据库和微服务持续演进,网络环境和硬件性能日益提升,类似的性能瓶颈问题将越来越重要。理解并掌握底层通信细节,优化客户端设计,制定科学的连接策略,方能构筑稳健、高效的分布式系统架构,实现业务系统的高可靠性和极致响应速度。希望本文的分享能为广大开发者提供思路启发,共同推动分布式技术实践的发展与创新。