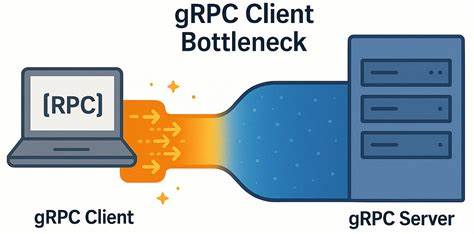

随着微服务架构和分布式系统的广泛应用,gRPC作为一种高性能、跨平台的远程过程调用框架,成为企业构建高效通信系统的重要工具。尤其在低延迟网络环境下,gRPC的表现关乎系统的响应速度与吞吐能力,直接影响用户体验和业务成功。然而,近期的研究和实际应用案例揭示了gRPC客户端在这种理想网络环境中意想不到的性能瓶颈,挑战了对其性能的传统认知。 gRPC基于HTTP/2协议实现多路复用,支持多个RPC流共享同一TCP连接,这一设计在理论上能够显著降低连接管理开销并提升通信效率。然而在实践中,即便存在高速、低延迟的网络条件,客户端依然出现了吞吐量有限和延迟逐渐升高的现象。深入分析后发现,瓶颈主要集中在客户端的多个RPC流排队和资源竞争引起的性能下降。

最初,许多开发者和运维人员观察到当集群节点数量减少时,负载压力反而无法有效转移至少量节点,导致集群资源利用率下降并出现客户端延迟飙升的情况。实验证明,在客户端发起大量并发请求时,虽然网络传输几乎无瓶颈,服务器处理速度也足够快速,客户端却因共享单一TCP连接的并发流数限制,以及gRPC内部请求排队策略,形成了隐形瓶颈。 通过使用基于C++实现的gRPC微基准测试工具,模拟实际调用场景,测试者在专用硬件和50Gbps低延迟网络环境下对比了单连接与多连接的性能表现。结果发现,当所有请求复用同一TCP连接时,系统吞吐能力远未达到理论线性扩展,且随着请求并发数增加,响应延迟表现出线性增长趋势。该现象表明TCP连接的HTTP/2流上限和gRPC内部分发机制共同限制了整体性能发挥。 进一步分析抓包数据发现,在客户端发送请求与服务器响应之间存在150至200微秒的空闲间隔,这些间隔不是网络传输或服务器响应引起,而是客户端自身处理逻辑或gRPC调度延迟所致。

深度剖析后确定该延迟起因主要是客户端将多个RPC合并复用同一连接导致的调度竞争与排队问题,限制了并发请求的发起和处理效率。 为突破这一瓶颈,研究团队尝试了多种客户端优化方案,尤其关注gRPC官方性能最佳实践中提及的两条路径:为不同负载区域创建独立的gRPC通道,或使用多通道连接池分散请求压力。通过对比实验发现,简单的复用默认通道参数并共享TCP连接的方案无法解决客户端瓶颈,只有在为每个并发工作线程创建独立通道并利用不同通道参数(如启用本地子通道池的特定配置)时,才显著提升了系统整体吞吐率和响应延迟。 具体而言,当每个工作线程拥有自己的gRPC通道且开启GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL参数,客户端性能得到了近乎线性的扩展。吞吐率提升了6倍以上,延迟增长幅度明显减缓,体现出客户端多连接策略的巨大优势。同时,在更高延迟的5毫秒网络环境测试中,单通道与多通道性能差异不显著,进一步验证了该瓶颈主要存在于超低延迟场景。

这些研究成果提醒开发者在设计高性能gRPC客户端系统时,应慎重考虑连接策略与通道配置,避免因默认共享同一TCP连接而陷入调度瓶颈。尤其对于在数据中心内部或高速网络环境下部署的关键业务,合理分配和隔离通道能够最大限度减少请求排队和上下文切换,保障系统稳定且快速响应。 此外,测试中采用的CPU亲和性配置(通过taskset保证线程同一NUMA节点运行)也成为影响性能的重要因素。此举有效避免了跨NUMA节点评价导致的额外延迟与缓存污染,为准确评估gRPC性能提供了基础。企业应借鉴这一思路,优化硬件资源绑定,实现软件与硬件资源的深度协同。 在未来,随着gRPC版本的持续迭代与网络技术的发展,客户端性能的瓶颈或将进一步变化。

除了多通道和参数调整,可能还存在其他潜在优化空间,例如更加智能的请求调度算法、更细粒度的负载均衡机制或网络协议级别的改进。持续的性能监测与动态调整将成为企业保持竞争力的重要手段。 总结而言,低延迟网络环境下gRPC客户端的瓶颈主要源于HTTP/2连接中有限的并发流数及gRPC客户端调度机制带来的排队延迟。适合的优化策略是为每个并发工作线程创建独立的通道,并调整通道配置以避免连接重用,从而大幅提升吞吐能力,降低延迟。此外,合理利用硬件资源绑定提升性能稳定性也是不可忽视的一环。通过这些方法,开发者和运维团队能够确保gRPC在高负载、低延迟条件下实现最佳性能表现,为分布式应用提供坚实的通信基础。

面对不断增长的服务调用需求和严格的响应时间要求,深入理解和优化gRPC客户端瓶颈至关重要。希望未来社区能汇聚更多的经验和创新思路,共同推动gRPC生态系统迈向更加高效和智能的未来。