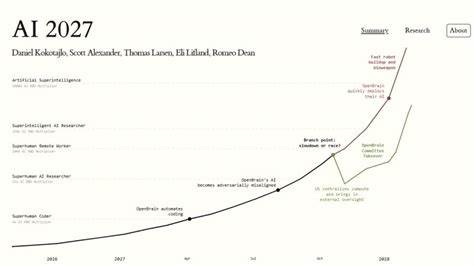

2025年春,一群知名学者发布了名为AI 2027的计划,预测人工智能通用智能(AGI)将在2027年实现,并对其未来影响进行了详细勾勒。这一项目迅速吸引了广泛关注,支持者认为其愿景积极且充满潜力,质疑者则指出其预测存在方法论上的不足。几个月后,进行详细质疑的批评文章出现,激起了新的论战。面对这波浪潮,我们不禁思考,这场围绕AI 2027的讨论到底映射出了我们的科研文化和知识传播机制中的哪些深层次问题?AI 2027的提出无疑激发了对未来人工智能进展的热烈讨论。它不仅仅是一组时间表和预测,更像是一场试图描绘未来图景的宏大叙事。支持者们在高层次上看到了这一项目的价值——它有助于引发公众和专业圈对AGI潜在风险与机遇的关注。

然而,由于预测的科学依据和建模方式尚未公开透明地详尽展示,怀疑和质疑声音也随之而来。批评者指出,模型或许忽视了现实中的复杂变量和不确定性,这使得预测充满争议。引发的争论中,最引人注目的不仅是技术细节,而是关于科学成果公开、验证和交流模式的讨论。现行学术体系强调同行评审,理论上这一机制是保障学术质量和科学严谨性的基石。可在具体实践中,同行评审往往耗时长、流程复杂,且容易被无关因素干扰。一篇论文为了通过审查,作者可能不得不采取晦涩难懂的学术语言,并在文中大肆引用可能无关但知名度较高的文章以博取评审好感。

这导致科研文献难以被广泛理解,交流效率低下。更严重的是,同行评审通常由来自相同学科或社群的专家完成,他们的视角和思维方式大体相同。这种封闭的审查环境易形成共识偏见,而对创新观点和跨界思考却可能产生阻碍。许多错误和谬论甚至在经过审稿流程后仍然得以发表,而纠正错误往往较为缓慢和低效。社会科学领域尤为明显,常见的不严谨统计分析反复出现在权威刊物中,外界批评声音难以被接纳。反观AI 2027项目,其采用了非传统的开放讨论与迭代批评方式。

初稿发布后,社区成员迅速响应,不断提出质疑和改进建议,形成了公开、透明的技术和理论辩论。这种机制在某种程度上类似“开放式同行评审”,避免了传统体系的官僚主义和时间延迟,通过快速互动达成知识累积。这样一种新型的科研生态,拥有巨大的潜力。它鼓励作者勇于面对错误并及时修正,促进多元智慧的融合,减少封闭圈层垄断信息的现象,从而推高科研成果的质量和影响力。也有声音担忧,这种“开放试错”的方式可能导致错误传播,且缺乏足够严谨保障。对此,社区内形成的共识是需要在宽松自由与严谨求实之间寻找平衡点。

不同学科领域也许适用不同的复制与验证标准,例如数学领域的证明核实相对容易,因此“高处罚”机制适宜;而复杂且数据驱动的AI研究则适合更开放的验证过程。技术进步推动了信息传播方式的变革。网络环境下,传统的纸媒延时机制已不再是必需,科学传播和讨论呈现出极大活力和多样性。人们越来越倾向于实时公开自己的研究构思和成果,借助社区反馈迭代完善。面对挑战和机遇,科研界开始思考如何构建一套兼顾速度、质量与开放性的科学传播新范式。AI 2027及其辩论正是这场变革的缩影。

深入剖析当前争论,不难发现这不仅仅是对一份预测报告的质疑,更是科研文化自省和革新的契机。对人工智能AGI的预言总是带有不确定性,但表达这种不确定性的方式与社区协作的模式,却能够决定预言对社会和科学的真正价值。未来的科学交流需要更包容多样、灵活高效,能够容纳一时的错误与探索,同时不断推进真理边界。AI 2027项目向我们展示了一条开放、透明、迭代的路径,虽然不完美,却生动展现了知识进步的可能形式。作为关切者,无论是科研人员、政策制定者还是公众,都应关注并参与到这一新型科学话语的塑造中。促使各方共同构建一个更加健全、有活力并且对错误持开放态度的科研生态,才能真正推动人工智能领域向前迈进。

终究,技术预言终将被时间验证,然而推动预言形成的那种公开理性和共识生成的讨论过程,才是科技文明进步的永恒动力。