随着人工智能技术的飞速发展,大型语言模型(LLM)在自然语言处理、智能问答、内容生成等领域均展示了强大的能力。然而,随着应用范围的扩大,模型的安全性和合规性问题日益凸显。近期,一款名为Compliant LLM的安全工具崭露头角,其不仅能够检测和识别诸如OpenAI和Anthropic旗下Claude模型的潜在安全隐患,还提出创新的攻防策略,成为业界关注的焦点。Compliant LLM由FiddleCube团队开发,目的在于为信息安全专家、合规团队以及AI开发者带来一站式的解决方案,有效保障AI系统面对复杂多变的攻击形势时依然稳健可靠。该工具以开放源码形式发布,支持多厂商、多种语言模型接口,具备强大且灵活的攻击检测能力,包括但不限于提示注入、越狱攻击、上下文操控等攻击类型。针对这些安全挑战,Compliant LLM设计了多达八种以上的攻击策略,能够模拟真实世界中的各类攻击场景,帮助用户提前发现系统漏洞,及时修复并强化安全防御体系。

该工具还内置多种主流合规标准的检测模块,涵盖了NIST、ISO、GDPR、HIPAA及OWASP等权威框架。用户可根据具体业务需求定制化检测方案,确保AI解决方案不仅安全且符合法律法规与行业规范要求。值得一提的是,Compliant LLM不仅聚焦于单一模型安全检测,更提供整体AI系统的端到端测试能力,从模型调用接口、提示设计、推理环境到部署架构均纳入检测范围,促使AI服务实现全流程可信赖。工具配备了交互式可视化仪表盘,方便用户实时监控测试进展和结果,整体体验人性化且便于技术团队协同作业。同时,详细的报告功能为决策层和安全审计人员提供清晰明了的洞察和建议,促进跨部门合作。该项目支持包括OpenAI、Anthropic、Gemini、Mistral、Groq、Deepseek、Azure、Ollama、Nvidia Nim及Meta Llama等多个知名厂商的模型接口,展现出极佳的兼容性和扩展性。

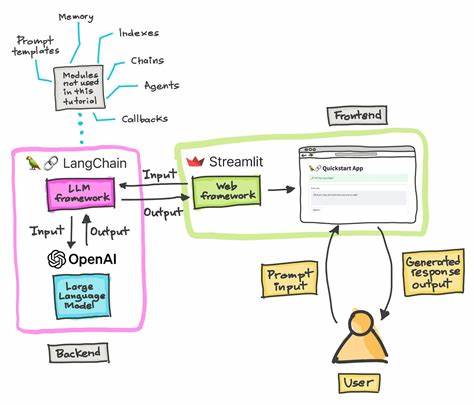

其底层通过LiteLLM中间层实现对多服务提供商的无缝集成,简化了用户的部署与管理难度。开发团队还计划持续迭代升级,未来将支持多模态检测、MCP服务器的全面合规和日志记录、CI/CD集成及基于角色的访问控制等高级功能,构建更加完善的AI安全生态。Compliant LLM的诞生恰逢人工智能系统遭遇复杂安全挑战之时。无论是黑客通过精心设计的提示语干扰AI模型,还是恶意利用上下文操控窃取敏感信息,都是对AI应用安全性极大的考验。在此背景下,拥有科学严谨的安全测试工具显得尤为重要。通过模拟攻防过程,团队能够提前锁定关键风险点,实现问题的预警和整改。

对于企业来说,依托Compliant LLM可以大幅降低因AI系统安全隐患带来的商业风险,保障客户数据安全和合规运营,提升用户信任度。同时,该工具助力研发团队优化提示设计,避免无意中触发模型不良行为,提高产品质量和用户体验。社区的积极参与也为项目注入了源源不断的活力。无论是提交代码贡献新功能,还是反馈使用体验,都推动工具不断完善与创新。此外,项目对数据隐私高度重视,采用匿名统计机制,严格保护用户信息安全,兼顾产品改进与隐私合规。展望未来,AI安全和合规必将成为行业发展的核心命题。

随着相关法规的不断完善以及AI应用的广泛渗透,合规性和安全性的需求愈发紧迫。像Compliant LLM这样专业化、安全性强烈把控且多厂商支持的工具,将成为企业部署AI时不可或缺的重要保障。综合来看,Compliant LLM开创了大型语言模型安全测试的新纪元,提供了操作简便、功能全面的解决方案,以应对日益复杂的攻击方式并兼顾合规需求。对于希望在激烈竞争中脱颖而出并确保AI系统安全可靠的组织来说,积极采用此类工具是一条行之有效的路径。未来伴随着算法不断升级与安全意识增强,期待Compliant LLM继续引领行业安全标准,成为保障智能时代AI责任与可信赖性的基石。