机械式可解释性是理解复杂人工智能系统内在机制的重要方向。随着人工智能技术的迅猛发展,理解和解释深度学习模型的决策过程变得越发关键。作为机械式可解释性研究员,您将扮演连接黑盒模型与人类理解之间桥梁的角色,推动人工智能系统的透明度、安全性以及可靠性。因此,如何成为一名合格且出色的机械式可解释性研究员,成为许多科研人员和人工智能从业者关注的话题。 要踏入机械式可解释性领域,首先需要建立坚实的数学和计算机科学基础。线性代数、概率论和统计学是理解机器学习模型基础结构的核心数学工具。

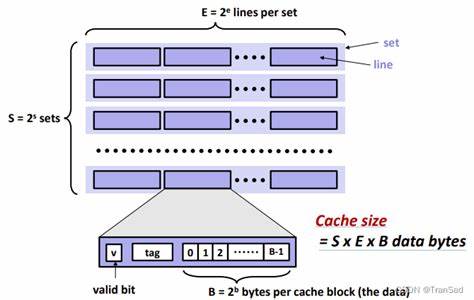

此外,熟练掌握算法设计和分析能够帮助研究员更好地理解模型训练与推理机制。编程能力尤为重要,Python 作为机器学习领域的主流语言,是实现模型训练、测试和实验的基础。熟悉深度学习框架如TensorFlow和PyTorch,可以加速构建和验证解释模型的过程。 理论知识的积累是进入机械式可解释性研究的另一关键方面。研究员需要深入理解神经网络结构与功能,包括卷积神经网络、循环神经网络、变换器以及更复杂的架构。深入研究模型的激活模式、权重分布和梯度流通,对于揭示其决策逻辑至关重要。

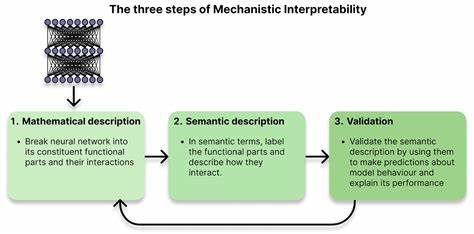

同时,掌握常见的神经网络可解释性技术,如注意力机制可视化、梯度加权类激活映射(Grad-CAM)、归因方法(Integrated Gradients、LIME、SHAP)等,有助于初步解析模型行为。 迈入机械式可解释性的核心领域,要求研究员逐渐从宏观层面的解释切换到模型内部运作机制的剖析。机械式可解释性不仅关注模型输出的可解释性,还更加注重揭示模型内部的因果结构和信息流。此阶段,研究员需要掌握利用抽象数学理论和计算工具解构深度网络的方法,如网络权重的子空间映射、激活子网络的辨识、层间联结强度与功能划分等。与此同时,推动可解释性模型与博弈论、信息论、因果推断等领域的交叉融合,为研究提供更广泛的理论支撑和创新途径。 科学研究能力的培养对于成为机械式可解释性领域的顶尖专家尤为重要。

除了理论知识,实际动手能力同样不可或缺。研究员应积极参与前沿论文的阅读和分析,理解领域内最新的研究成果与方法学演进。此外,亲自设计并执行实验,验证新算法的解释性能,优化解释模型的有效性和准确性,是提升研究实践能力的有效途径。通过持续的学术写作和成果发表,扩大研究影响力,同时建立与国际学者的合作网络,有助于获取更多资源和视角,加强研究的深度和广度。 选择适当的教育路径和科研平台也非常关键。机械式可解释性多发源于计算机科学、人工智能、认知科学和统计学等交叉领域。

攻读相关领域的硕士和博士学位,不仅能系统掌握理论与实践技术,还能通过导师指导获得宝贵的科研经验。加入专注于神经网络解释性研究的实验室、科研机构或技术企业,是实践和深化知识的重要途径。参加国际学术会议、讲座与研讨会,有利于紧跟学科动态,学习顶尖专家的最新理念和方法。 软技能的培养同样不可忽视。沟通能力和跨学科合作是推动解释性研究的关键。解释机制复杂、涉及多领域知识,单一视角难以形成完整理解。

具备良好的交流技巧,能够将复杂概念以通俗语言表达,便于研究团队协作和技术推广。同时,批判性思维能力和持续学习的态度,也是保持科研创新动力的动力源泉。面临复杂挑战时,灵活调整研究策略,提高问题解决效率,这些素质将加快个人成长速度。 机械式可解释性未来发展潜力巨大,相关研究正日益受到学术界和工业界的重视。随着人工智能系统广泛应用于医疗诊断、金融决策、自动驾驶等高风险领域,对模型透明度和责任归属的需求愈发迫切。成为机械式可解释性研究员,不仅能推动技术进步,还能促进社会信任和法规制定,为人工智能伦理保驾护航。

通过不断深耕领域理论,探索创新算法,开发实用工具,引领AI解释能力迈向新高度。 总之,成为机械式可解释性研究员需在数学、编程、神经网络结构、理论研究与实验操作等方面不断积累经验,同时注重教育背景与学术交流的建设。柔性技能的协同发展促使研究者能够应对复杂多变的科研环境。凭借持续学习、开拓创新的精神,将个人潜力转化为学科成果,最终在机械式可解释性领域获得突破与成功。未来的人工智能需要更多这样既懂技术又懂人文的桥梁者,推动智能系统更加安全、透明和可信赖。 。