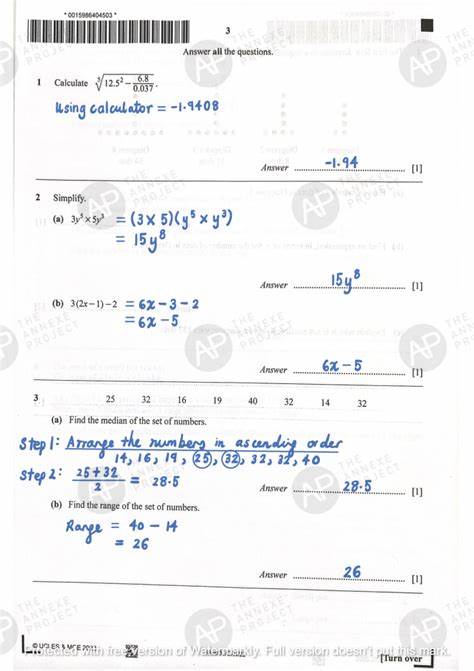

近年来,随着人工智能技术的迅猛发展,模拟推理(Simulated Reasoning, SR)模型作为一类声称具备推理能力的人工智能系统,逐渐成为学术界和工业界关注的焦点。这些模型通过“链式思维”(Chain-of-Thought)技术,试图模仿人类逻辑推理过程,以分步骤展示解决问题的思路,从而提高复杂问题的处理能力。然而,最新的研究表明,尽管模拟推理模型在标准数学运算和基础问题上表现出较高的准确率,但在更具挑战性的数学奥林匹克级别证明中却显得力不从心,远未达到其宣传的推理水平。最新发表的《Proof or Bluff? Evaluating LLMs on 2025 USA Math Olympiad》研究由苏黎世联邦理工学院(ETH Zurich)和索菲亚大学INSAIT研究团队联合完成,通过对2025年美国数学奥林匹克(USAMO)题目的系统评测,揭示了现阶段SR模型所面临的本质性障碍。研究中,模型普遍难以生成完整且逻辑自洽的数学证明,平均准确率不足5%。尽管谷歌的Gemini 2.5 Pro模型表现优于其他同类产品,达到约24%的得分,但距离人类专家的标准仍有明显差距。

研究团队发现在许多模型生成的证明中存在明显的逻辑漏洞,论证建立在未经证实的假设之上,甚至有时产生自相矛盾的推理路径。这种现象本质上反映了模拟推理模型仍主要依赖于训练数据中的模式匹配能力,而难以真正理解和构建创新的数学逻辑结构。为何模拟推理模型能够在普通数学问题上表现优异,却无法胜任复杂的数学证明任务?这主要源自二者本质上的差别。简单数学问题往往只需最终数值解,或者短时间内验证的正确答案,而数学证明则需要展开细致连贯的逻辑推理,阐明为何结论必然成立。这不仅要求模型具备对抽象数学概念的深刻理解,更需要其能够有效调整推理策略,应对新颖而复杂的挑战。训练方式上,SR模型通过“链式思维”步骤显著增加推理的细节和计算量,使得模型在推理路径上做出更精细的选择,从而减少错误和胡编乱造的可能。

但这种改进实质上更多表现为提升了模型在统计层面的预测能力,而非真正突破推理范式的根本限制。鉴于当前主流的变换器神经网络结构,这些模型依然停留在从训练样本中学习和泛化模式的阶段,缺乏类人类的推理灵活性和反思能力。研究亦指出,模型在输出过程中常常以断言式的语言给出错误结论,未能表现出对自身推理错误的识别和警觉。这一点严重限制了其在实际应用中作为可靠决策辅助工具的潜力。除此之外,主流SR模型在训练过程中常受目标函数的影响,比如追求标准格式的“最终答案”,可能导致在严谨证明场景下忽视全面论证细节的倾向,从而产生伪装得体但实则漏洞百出的推理文本。通过此次USAMO测试,也反映了训练数据的覆盖范围和质量对模型表现的关键影响。

题目保密使得模型缺少针对新题型的预训练样本,暴露出其泛化能力不足的短板。面对这种种挑战,学界和工业界都在积极探索补充与改善策略。其中,结合符号推理引擎与神经网络的“神经符号系统”日渐成为热门方向。以DeepMind的AlphaGeometry为例,其结构融合形式化的数学验证方法,避免了模型自信输出错误证明的情况,确保每一步推理都符合严格的逻辑规则。这类方法在抗击“胡言乱语”方面效果显著,也为未来更强人工智能推理能力奠定基础。此外,研究人员正在尝试引入自动化的证明验证技术和自身一致性检测机制,通过多重交叉验证和筛选机制提升最终输出的可信度和严谨度。

未来,培训新一代SR模型或许需要结合更多、多样化且结构化的数学知识库,增强模型对高阶抽象和推理模式的理解能力。同时,在架构设计和训练范式上,应更加注重强化模型的元认知和错误检测能力,而不是单纯提高参数规模和计算资源。虽然现阶段模拟推理模型尚未实现突破性的数学证明能力,但它们在提高符号推理可视化、增强模型解释性以及辅助数学学习与教学等领域仍具备广阔前景。未来随着技术积累和跨学科协作的深化,这些人工智能系统有望逐步缩小与人类深度推理能力之间的差距。总结来说,模拟推理人工智能模型目前仍是一种基于统计学习的模式匹配工具,其推理能力面临着从表层语义理解到深层逻辑构建的根本跨越。当前的实验与评测结果表明,尽管在某些简单数学任务中展现出优秀表现,但在尖端数学领域仍显薄弱。

要实现真正意义上的人工智能推理突破,研究人员需要超越现有大规模变换器结构的局限,结合符号方法与形式验证,注重模型的自我反思与纠错能力建设。随着这一方向的不断探索与技术革新,未来人工智能在高阶数学推理和更广泛领域的应用能力值得期待。人工智能推理技术的提升不仅将推动自动定理证明、科学研究的自动化,还将为教育、工程设计、金融风险评估等多个行业带来深远影响。面对这一充满挑战的前沿领域,业界和学界仍需保持谨慎乐观,结合理论创新与实证检验,共同推动人工智能迈向更智能更可靠的明天。