近年来,概率扩散模型因其在生成任务中的优异表现逐渐受到人工智能领域的关注。Tiny-diffusion作为一个基于PyTorch的轻量级开源项目,提供了对概率扩散模型的简洁而实用的实现,专注于二维数据集的训练和生成。本文将带领读者全面了解Tiny-diffusion的工作原理、核心设计理念以及其在模型训练和应用中的表现,助力读者深入掌握扩散模型的最新进展和实际应用场景。 随机性与概率性是现代生成模型不可缺少的特性。扩散模型通过模拟数据逐步受噪声破坏的前向过程,再通过学习逆过程逐渐去噪,成功生成与训练数据分布相似的新样本。Tiny-diffusion选择了基于DDPM(Denoising Diffusion Probabilistic Models)框架的实现,重点展示了如何以最小代码量完成扩散过程的搭建和训练。

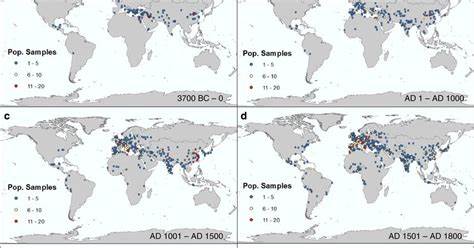

项目中包含的ddpm.py文件是关键模块,用户可通过运行该脚本并传入特定参数快速启动模型训练,探索不同超参数设置对生成质量的影响。项目作者特别进行了多轮消融实验,验证了学习率、时间步数、模型隐藏层大小及数量、噪声方差调度策略等众多因素对训练效果的显著影响。值得注意的是,学习率在训练早期对结果影响巨大,一旦调整得当,模型即可稳定生成逼真二维点分布。 Tiny-diffusion利用二维点集数据进行训练,常用的Datasaurus Dozen恐龙数据集为例生动展示扩散过程的前向和逆向动态。在前向过程中,数据逐步被随机噪声覆盖,损失原有结构;而逆过程则发挥核心作用,逐步去噪还原出原始数据点分布。经过训练,模型能够实现从纯噪声中恢复出具有明显形状特征的点集,映射出恐龙轮廓,形象展现了扩散过程的强大能力。

在模型设计层面,Tiny-diffusion引入了位置嵌入(positional embeddings)机制,具体包括时间步的编码与输入点的频率编码。通过时间步嵌入,模型能够明确当前去噪阶段,有助于捕获不同扩散阶段中的数据特征变化。而输入的正弦频率编码增强了模型对高频信号的感知能力,提升对复杂点分布的建模精准度。这样的设计借鉴了NeRF等高频函数表示领域的成功经验。 关于超参数调度,项目展示了不同噪声方差调度策略对训练结果的影响。尽管Quadratic调度未能产生更优结果,但作者建议尝试Cosine和Sigmoid调度以期获得改善。

扩散过程的时间步数同样关键。更长的时间步使模型具备更细腻的逆扩散能力,有助于捕获数据微小特征,从而生成更完整和清晰的样本形态。 模型容量方面,实验表明模型容量并非生成质量的主要瓶颈。在调整隐藏层大小与深度后,训练结果变化不大,提示Tiny-diffusion的简约架构已足够应对当前二维数据集的复杂度。这给研究者带来了启示,由于模型轻量,用户可快速进行多轮实验和参数微调,极大降低了开发成本和计算资源需求。 从应用角度看,Tiny-diffusion为初学者和研究者提供了便捷的入门平台,理解概率扩散模型的核心原理并验证不同设计想法。

其代码结构清晰,易于扩展,使用户能够灵活结合自身任务需求调整训练流程。此外,项目的开源特性促进了社区交流与合作,推动扩散模型理论与实践不断进步。 结合国内外相关研究与工业界趋势,概率扩散模型显示出在图像生成、语音合成、数据增强等多个领域的广泛应用潜力。Tiny-diffusion以其极简实现,既适合教学演示,也为构建定制化扩散模型奠定坚实基础。随着技术发展与硬件性能提升,相关模型在更高维度复杂任务中的表现将持续突破,催生更多创新应用。 总结而言,Tiny-diffusion不仅是一款代码简洁的概率扩散模型实现工具,更是理解扩散原理与实践的良师益友。

通过不断实验不同超参数与结构组合,研究者能够深入发掘扩散模型的潜能,实现更高质量的数据生成与建模。期待未来Tiny-diffusion在人工智能领域激发更多灵感,推动创新技术的不断迭代升级。