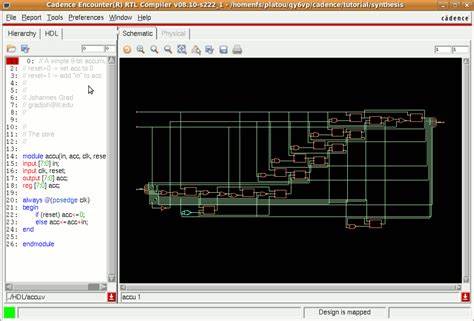

随着大数据时代的加速发展,保证数据质量已经成为企业数据治理的重要环节。Databricks作为领先的大数据分析平台,结合AWS云基础设施,提供了强大的数据处理能力和灵活的流式与批式数据管道构建环境。在此环境下,期望(expectations)机制应运而生,成为确保数据准确性、完整性和一致性的关键工具。掌握期望的先进推荐策略和实现模式,能够帮助企业在复杂的数据生态中实现数据价值的最大化。 期望在数据工程中的主要作用是定义和验证数据输入输出的规则。通过对数据进行断言和校验,期望能够主动发现脏数据、异常数据和潜在数据丢失,确保数据流在后续业务分析和机器学习环节中的可靠性。

Databricks on AWS支持通过声明式的方式创建期望,使得构建和管理数据质量规则更加直观和高效。 在实际应用中,如何提升期望的可移植性和多场景复用率是重中之重。将期望定义与具体管道逻辑分离,可以显著降低维护成本。推荐将所有期望规则集中存储在独立的数据表或字典结构中,通过标签系统对规则进行分类和管理,从而实现针对不同数据集或业务需求灵活调用相应规则。例如,将期望规则存储在名为rules的Delta表中,每条规则包含名称、约束表达式及标签信息。Python函数可以动态加载规则,方便地应用于不同的数据表中。

这种方式既提升了代码的模块化,也方便规则的审计和更新。 利用Databricks的装饰器机制,可以实现对表数据的统一期望校验,如使用@dp.expect_all_or_drop进行批量校验并剔除违规记录,确保下游数据的纯净度。同时利用标签机制,实现对不同维度的质量策略管理,如"有效性""维护性"标签可以分别对应不同应用场景的规则,灵活调整策略而无需修改底层数据管道代码。 在数据一致性验证方面,行数验证是最基础也是最常用的手段。通过对比两个表的记录数,确认数据在处理或传输过程中未出现遗漏。例如,定义视图对比转换前后的表行数,如果不相等即触发失败。

此类校验保证了数据从源头到目标的完整传递,避免数据缺失风险。 除了数量核对,缺失记录的检测亦至关重要。某些关键业务报表需要保证所有预期记录均存在,缺漏可能导致决策失误。通过对比验证表与报告表的连接结果,筛选出未匹配的记录,进而触发完整性校验失败,能够及时发现数据丢失问题,保障报表准确性。 主键唯一性校验在数据库设计中直接关系到数据约束的健全性。通过对目标表中主键列进行分组计数,确保每个主键值只出现一次,从而避免数据重复带来的混乱和冲突。

通过期望机制自动验证唯一性规则,可有效防止上游异常写入或合并引发的数据冗余问题。 在数据源不断演进的场景下,模式变更处理尤为挑战。数据结构频繁变更可能导致旧版处理逻辑失效或产生错误。针对这种情况,Databricks推荐采用模式演进模式,通过允许新增列的方式结合旧版和新版数据,实现数据的平滑过渡和兼容。期望规则针对关键字段进行非空和有效值验证,确保核心数据字段的完整性。同时允许针对新增字段实现更灵活的校验逻辑,保证架构升级的平稳进行而不影响数据质量。

统计范围验证是识别异常值和数据漂移的重要方法。通过计算历史数据的均值和标准差,确定合理的上下界,将新数据点与这些范围进行比对,能够自动发现可能的异常数据。结合期望规则,自动剔除超出统计范围的记录,有效地防止异常值污染数据分析结果,增强数据的稳定性和信任度。 在复杂数据流水线中,对于非法或不合规记录的隔离处理也十分必要。通过设定隔离规则,将不满足期望的记录标记并存储在临时分区表中,分别维护有效数据和问题数据的路径。这样的模式不仅便于后续针对异常数据进行专项分析修复,也减少了对正常数据流程的影响,提升数据处理的弹性和鲁棒性。

采用Databricks on AWS进行流式及批式数据处理,结合灵活的期望机制和高级校验模式,使数据质量管理不再是一项繁重的任务,而成为业务敏捷发展的核心保障。期待未来更多针对大数据和云原生环境的优化实践出现,帮助数据团队更高效地构建可靠、可持续的数据产品。 总之,期望机制在Databricks上的最佳实践包括将规则与管道逻辑分离、标签化管理、支持动态加载和复用;多维度数据质量验证涵盖行数、完整性、唯一性、模式演进、统计范围和异常隔离;这些模式不仅提升了数据质量管控水平,更为构建稳定数据流水线和精准的数据驱动决策奠定坚实基础。通过熟练运用这些策略,企业能够在AWS云环境中搭建高效、可靠的数据质量框架,推动数据资产价值的持续提升。 。