在现代数据工程的快速发展中,数据建模工具Dbt(Data Build Tool)逐渐成为数据团队不可或缺的利器。它以简洁的SQL编写和强大的数据转换能力帮助数据团队实现数据自动化与管理。然而,随着模型数量的快速增长,Dbt的编译性能问题日益突出,影响了数据开发的效率和用户体验。许多从业者开始思考,应否用性能卓越的Rust语言对Dbt进行重写,以应对未来数千模型规模的大型数据项目。 现阶段,Dbt在处理几百个模型时表现尚可,编译时间通常在秒级范围。然而,随着模型数目攀升至上千甚至几千级别,编译时间快速增长成了不可忽视的性能瓶颈。

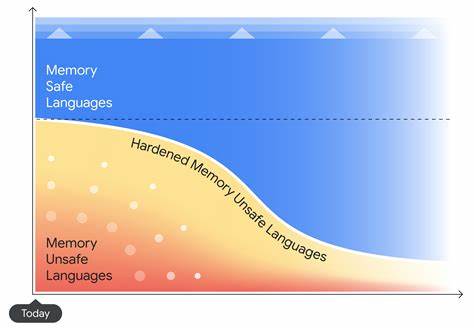

一些使用者反馈,当模型数量达到近三百时,编译时间已超过三十秒,这意味着随着规模的扩大,延迟将显著增加,预计在两三年后达到三千模型时,编译时间将超过五分钟,严重阻碍数据团队的开发节奏。 造成这种性能瓶颈的根源主要在于Dbt目前使用的编程语言和架构设计。Python作为开发语言,其运行时性能和内存效率受到限制,难以满足超大规模复杂数据转换的需求。同时,Dbt的编译流程涉及大量的SQL解析、依赖关系解析和模型调度,这些操作需要更高效的内存管理和并发处理能力。 Rust语言因其系统级性能和内存安全特性,被认为是提升性能、优化资源管理的理想选择。Rust的零成本抽象、强类型系统和先进的并发模型,使其在高性能计算和系统软件开发领域表现卓越。

通过用Rust重写Dbt的核心编译和执行引擎,可以显著提升编译速度,降低资源消耗,并提高整体系统的稳定性和安全性。 除了性能优势,Rust还具备其他促进Dbt生态发展的潜力。Rust的跨平台能力以及活跃的社区生态支持,为未来扩展多样化功能和插件提供了坚实基础。同时,Rust代码的安全特性有助于减少潜在的内存错误和程序崩溃,保障数据处理流程的可靠运行。 大规模数据项目对数据工具的性能和稳定性提出了苛刻要求。随着企业对数据资产管理的重视,Dbt所承担的模型编译任务将更为复杂,涉及更多的业务逻辑和依赖关系。

现有的Dbt在模型编译速度和资源利用方面的不足,若不能及时解决,将制约数据团队的工作效率和业务创新。 业界已经出现了若干利用不同技术栈优化数据转换性能的尝试,包括基于编译型语言重构的数据工具,以及采用异步并行处理提升效率的框架。然而,考虑到Dbt庞大的用户基础和生态系统,采用Rust进行重写既是一项挑战,也是一条机遇之路。 原有Python代码与Rust新引擎的集成需要谨慎设计,包括API兼容性、插件支持以及扩展性。在逐步迁移过程中,可以采用混合编程,利用Rust编写性能关键模块,逐步替换Python组件,实现平滑过渡。 当然,Rust重写方案并非完美无缺。

Rust的学习曲线相对陡峭,团队需要投入更多培训成本。同时,新的技术栈在初期可能带来稳定性和兼容性方面的挑战,需要充分测试和社区支持。在迁移期间,合理规划项目路线,保障日常数据开发稳定运行尤为重要。 综上所述,随着数据建模规模持续扩大,Dbt当前的性能瓶颈日益突出。利用Rust强大的性能优势对Dbt进行重新设计和实现,将为数据团队带来显著的性能提升和更优的开发体验。通过技术升级,Dbt能够更好地适应未来复杂多变的数据环境,支持数千级模型的高效管理。

对于数据团队和技术决策者而言,关注并推动这一方向的实践不仅能缓解当前的性能压力,更是为未来数据基础建设打造坚实底座的战略举措。随着Rust生态不断成熟,未来我们有理由期待Dbt的重生带来更高效、更稳定、更灵活的数据建模时代。