随着人工智能技术的快速发展,智能界面代理(GUI Agents)在提升人机交互体验、自动化操作等方面展现出巨大潜力。然而,传统的图形用户界面目标定位技术普遍依赖显式坐标输出,这种方法在实际应用中存在着空间语义结合度弱、监督信号模糊和视觉与操作粒度不匹配等显著瓶颈。针对这些挑战,微软研究院等机构联合推出的GUI-Actor项目,通过无坐标的视觉定位策略,开创了新一代界面智能代理的技术范式。GUI-Actor的核心创新在于引入基于大型视觉语言模型(VLM)的动作头(action head),通过对屏幕视觉区域的注意力机制实现元素的直接感知和操作指向,而非依赖具体数值坐标。这种设计理念巧妙模拟了人类操作界面的认知和行为习惯——人类从不计算精确的屏幕坐标,而是基于感知直接与目标元素交互。这样的思路不仅解决了传统方法在空间与语义匹配上的不足,也极大提升了系统在复杂界面环境中的适应能力和鲁棒性。

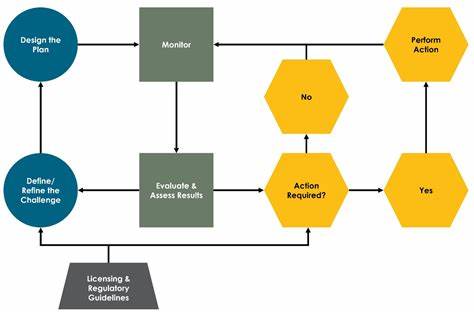

通过多候选区域生成机制,GUI-Actor能够在一次前向推理中给出多个潜在目标区域,为后续的搜索策略和决策模块提供丰富的选项和灵活性。同时,项目团队还设计了一套强大的验证器(grounding verifier),用以评估和筛选候选区域中的最合理目标,大幅提升定位准确率。验证器的模块化设计保证其可以与其他定位方法结合,进一步推动整体性能的提升。这一创新机制使得GUI-Actor不仅在传统数据集上展现尖端表现,还具备极强的迁移和泛化能力,特别是在面对未见过的屏幕分辨率和布局时,依然能够精准锁定操作目标。实验数据显示,基于GUI-Actor架构的模型在屏幕目标检测基准测试如ScreenSpot-Pro等数据集上屡次刷新记录,甚至在参数规模显著小于竞品的情况下实现超越,体现出优秀的效率与性能平衡。项目不断完善支持最新的Qwen2.5-VL视觉语言模型,进一步释放模型的大规模理解能力和视觉推理潜力,助力GUI智能代理达到更高水平的理解与执行力。

对于开发者和研究人员而言,GUI-Actor提供了一整套开放源码的工具链和完整的训练评估流水线,方便数据准备、模型训练以及在多种测试集上的准确性验证。不仅如此,高度模块化和文档完备的项目架构极大降低了应用部署的门槛,加快了技术转化为实际产品的步伐。随着屏幕设备和交互界面的多样化发展,传统坐标系统所面临的适配问题日趋突出。GUI-Actor以其无坐标视觉关注机制为基础的策略,顺应时代需求,为实现界面自动化提供了更符合人类交互直觉的解决方案,必将在智能人机交互领域掀起一场革新。未来,随着模型体量的持续加大与多模态学习的深入融合,GUI-Actor及类似方案有望推动智能界面代理不仅在操作定位上,更在上下文理解、任务规划等方面突破自我,创造更自然、更高效的数字工作和生活体验。总之,GUI-Actor通过颠覆传统坐标依赖方式,立足于动作感知和视觉聚焦的新范式,彰显了智能代理未来发展的广阔前景。

无论是学术研究还是产业应用,这一创新成果均为打造智能、高效、适应性强的图形界面交互系统提供了重要启示与实践基础,预示着智能界面自动操控的新时代正加速到来。