在当今人工智能日益普及的时代,智能代理已经成为数据处理和任务自动化的重要手段。无论是自动整理电子邮件、查询数据库还是访问第三方服务,AI系统普遍依赖于调用各种工具和接口来补充和扩展其能力。然而,随着这些工具的调用频率和复杂度不断加大,产生的上下文信息变得异常庞大,导致AI模型的上下文窗口被大量无关或过量信息占据。这种现象,被业内称为“上下文膨胀”,对智能代理的响应速度、准确度以及资源消耗带来了严峻挑战。针对这一痛点,来自开源社区的Toolflow项目应运而生,提供了一套专门面向AI工具调用的上下文管理解决方案,帮助开发者轻松过滤和控制传递给模型的信息量,提升系统整体稳定性和效率。首先我们需要理解上下文膨胀问题的本质。

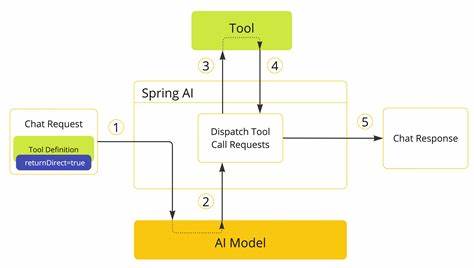

现代大型语言模型(LLM)在进行推理时,必须将所有相关信息保存在有限的上下文窗口中。然而,大部分工具或API的返回数据往往包含大量字段和细节,这些信息并非全部对当前任务有用。例如,常见的邮件查询接口可能返回数百个字段,包括大量技术性元数据和内部标识,而开发者通常只关心邮件的主题、发件人和简短内容摘要。如果毫无过滤地将这些信息全部传递给模型,不仅浪费计算资源,还可能混淆模型的注意力焦点,导致输出结果不准确或延迟显著。Toolflow以此为出发点,设计了轻量级的AI原生中间层,专门负责将API响应与智能代理的上下文进行解耦和优化。通过引入高度模块化且灵活的工具注册机制,Toolflow允许开发者定义并管理多个工具及其动作。

与此同时,其自带的多种响应过滤模式,可以在不同场景下智能选择合适的数据字段进行传递。例如其内建的“轻量模式”仅发送最必要字段,“完整模式”则传入全部数据,而“AI过滤模式”则通过智能判别自动修剪冗余内容,此外还支持runtime时动态自定义字段选择。这种设计让开发者能够根据业务需求灵活调控上下文载荷,最大程度减少无效信息进入模型。Toolflow还充分考虑了与主流AI框架的兼容性,实现了与Langchain、Flowise、AutoGen等工具的无缝对接。其实例涵盖包括邮件查询、数据搜索等多个常见应用场景,展示了如何通过接口响应裁剪显著提升智能代理调用效率。在其具体应用中,针对Gmail查找邮件的接口调用,Toolflow能够将数百个字段的复杂响应浓缩为仅包含发件人、主题、内容摘要及相关分页信息,从而确保LLM仅需处理真正有价值的数据。

而得益于这种数据传递的精简,智能代理不仅加快了响应速度,更提升了回答的相关性和准确度。此外,Toolflow采用TypeScript编写,提供运行时包、工具注册库以及类型定义,保证开发流程的清晰和安全,极大地降低了维护成本和潜在错误风险。开源社区对该项目的反馈普遍积极,因为它切实解决了开发者在构建多工具多接口复杂系统时遇到的痛点,尤其是在生产环境中对上下文管理要求极高的场景。值得关注的是,Toolflow不仅限于某一类工具调用,还可扩展支持自定义API和算法接口,这意味着其适用范围广泛,未来可推广到多种智能交互系统和自动化平台中。对于AI技术爱好者和开发者而言,Toolflow的推出代表了对提升智能代理可用性和用户体验的重大进展。它将原本繁琐且易出错的数据管理过程自动化、标准化,为构建更智能、更高效、更可控的AI系统提供了技术示范。

站在未来智能系统发展的视角,Toolflow体现了行业对上下文管理极致优化的追求,也是实现AI工具生态互联互通的重要推手。随着AI逐步迈向更多落地场景,如何兼顾系统灵活性与性能稳定性,如何在大规模调用时保障模型高效而精准地利用有限上下文,依然是核心挑战。Toolflow开源项目正是应对此类需求的创新答案。它所带来的模块化、灵活性和智能过滤能力,必将为AI智能代理的设计带来新的范式。总的来说,Toolflow以其独特的上下文裁剪机制和开发者友好的工具注册体系,成功缓解了AI工具调用中常见的上下文膨胀问题,对提升AI系统整体性能和用户体验具有重要意义。无论是想要加速AI模型推理流程,减少资源消耗,还是希望增强对工具响应数据的掌控,Toolflow都是不可忽视的利器。

未来,随着更多AI框架和应用接入这一中间层,我们有理由期待智能代理在处理复杂多源数据时表现得更加高效和精准,从而推动人工智能进入更广泛而深入的应用领域。