随着人工智能技术的飞速发展,语言模型成为自然语言处理领域的核心支撑。传统的全注意力机制虽然在准确率方面表现优异,但其庞大的计算资源和低效的生成速度成为制约其应用场景拓展的瓶颈。针对这一挑战,Jet-Nemotron应运而生,这是一款采用后神经架构搜索(Post Neural Architecture Search, PostNAS)技术打造的高效混合架构语言模型,既保持了顶尖模型的准确性,也实现了生成吞吐量的大幅提升,开启了语言模型设计的新篇章。Jet-Nemotron由谷歌、清华大学等多家顶尖机构的研究人员共同开发,不仅体现了深厚的技术沉淀,也体现出对实际应用需求的敏锐洞察力。Jet-Nemotron的核心创新在于其独特的PostNAS方法论。传统的神经架构搜索通常从头开始设计模型结构,耗时耗力且资源消耗巨大。

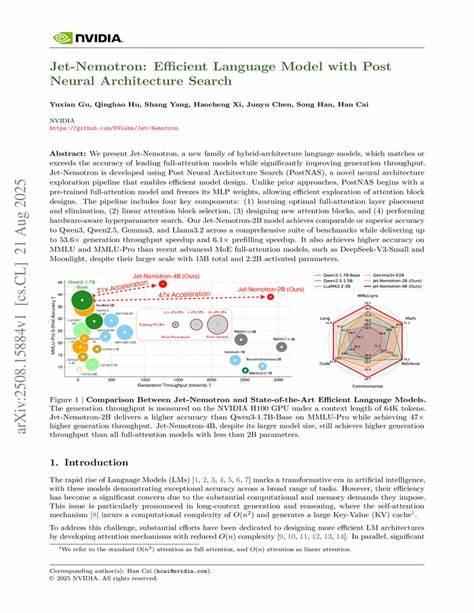

而PostNAS则基于预训练的全注意力模型,将多层感知机(MLP)权重冻结,专注于探索注意力模块的设计。这种方法不仅显著缩短了搜索时间,还确保了模型性能的稳定传承。PostNAS流程涵盖优化全注意力层的分布和精简、线性注意力块的选择、定制新型注意力模块设计以及硬件感知的超参数调整四大关键环节。通过精细控制这四个方面,Jet-Nemotron成功实现了在保证模型准确率的同时提升推理效率。具体来看,Jet-Nemotron-2B版本在多项权威人工智能评测基准中表现优异,其准确率达到了或优于当前行业领先的Qwen3、Gemma3和Llama3.2模型,同时其生成速度在部分场景中提升了惊人的53.6倍,预填充速度提升为6.1倍。这不仅意味着更加快速的响应,更极大降低了实际部署的成本。

对于规模更大的模型挑战,Jet-Nemotron同样表现不俗。尽管其参数规模相对较小,但在多任务理解领导套件(MMLU)和MMLU-Pro的评测中超越了DeepSeek-V3-Small和Moonlight等先进的专家模型(MoE)全注意力结构,充分展现了其结构设计的优势和效能。从技术视角审视,Jet-Nemotron通过将全注意力层与轻量级的线性和新型注意力模块相结合,实现了性能与速度的最佳均衡。一方面,关键层保留高精度的全注意力机制以保证语义理解的深度和广度,另一方面,辅助层采用计算效率更高的线性注意力降低总体计算量,这种混合策略为未来语言模型设计树立了新标准。此外,PostNAS的硬件感知设计更为Jet-Nemotron实现实际落地提供了坚实保障。通过针对目标硬件平台的资源利用率和运行效率进行优化,确保模型既能充分发挥最新芯片架构优势,又能满足应用需求,使得高性能语言模型不再是实验室的专属,而是真正走进工业界。

Jet-Nemotron的成功研发表明,未来语言模型的发展方向或将聚焦于架构与硬件协同设计,通过智能搜索和模块混合优化同时提升精度和效率。随着大规模预训练模型应用日益广泛,研究团队如何平衡计算资源与任务表现,如何通过创新方法持续突破性能瓶颈,将成为驱动行业进步的关键。综上所述,Jet-Nemotron代表了语言模型研究领域的一大突破,它通过后神经架构搜索技术实现了快速高效的模型设计,不仅保证甚至提升了模型的理解能力和推理准确率,更实现了前所未有的生成速度。对于希望提升人工智能交互体验和降低算力成本的企业和研究者而言,Jet-Nemotron为实现高性能与高效率的完美结合提供了宝贵的参考范例。未来,随着算法不断演进和计算平台升级,我们有理由相信,基于PostNAS的混合架构语言模型将成为推动人机交互智能化进程的重要引擎。 。