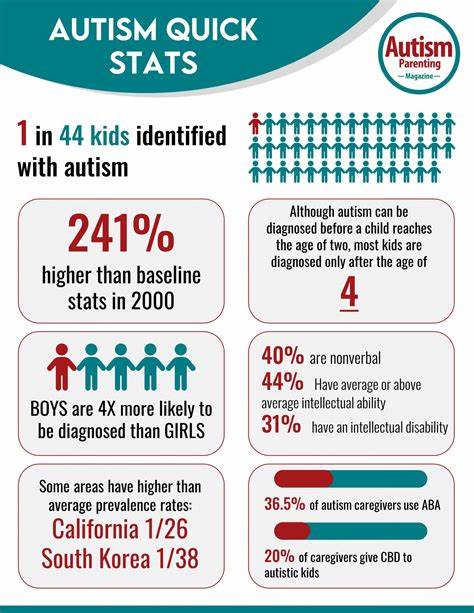

随着生成式人工智能技术的不断突破,越来越多的企业和开发者开始尝试将大型语言模型(LLM)应用到实际产品中,从聊天机器人到内容创作工具,无不展现出巨大的商业潜力。然而,许多项目在走出实验室的原型阶段,准备进入大规模生产环境时,却频频遭遇瓶颈甚至失败。究其根本,生成式AI项目失败的首要原因,是缺乏针对这一全新技术特点的专属生产运营策略,即GenAIOps。传统的机器学习运维(MLOps)方法难以适应生成式AI的高复杂性和极高资源消耗,导致运行不稳定、成本失控,进而影响产品的可持续发展。 生成式AI与传统机器学习场景有本质区别。其模型规模更大,推理计算资源消耗显著增加,且输出结果的随机性和不可预测性远超传统模型。

此外,模型需要不断更新、微调以适应多变的业务需求,这对系统架构的灵活性和扩展性提出了更高要求。若依旧沿用以往的MLOps流程,诸如简单的批量训练、周期性上线、单一监控维度,往往无法满足生成式AI对实时性能、响应时延和模型质量的严苛标准。 缺乏合适的GenAIOps框架,首先导致的是运行不稳定。生成式AI系统的复杂性容易引发各种异常,如模型推理超时、响应输出不合理,甚至因资源争抢导致系统崩溃。而这些问题不仅影响用户体验,更使得项目难以获得业务方的持续信任。再者,成本管理成为另一大难题。

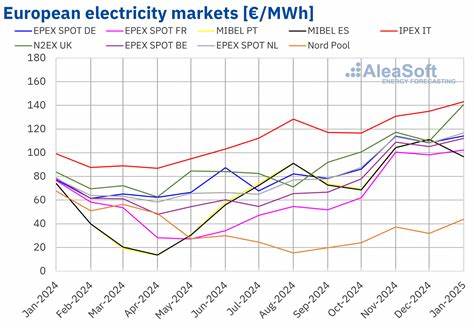

当前大型语言模型的推理成本令人望而却步,一次调用可能涉及数十美元的云服务费用。在生产环境中频繁调用,极易导致账单爆表,成为公司财务难以承受之重。一般没有针对性的成本优化策略,往往使得项目因预算限制被迫中止。 为了防止上述风险,企业需要构建专门针对生成式AI的运行与监控体系。首先,建立完善的模型性能监控是关键,这包括不仅仅是响应时长和成功率,还要监控输出文本的质量和安全性。通过持续收集用户反馈和自动化测试,快速发现模型偏差或异常结果,从而及时调整模型参数或调用策略。

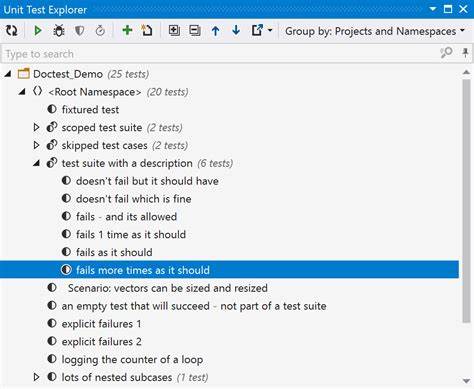

其次,采用分层缓存机制和推理流水线优化能够有效节省推理成本。例如,对于重复查询预先缓存答案,减少不必要的调用频率;或者使用小模型进行初筛,必要时才调用大型模型生成最终结果。这种混合推理策略已被多家顶级公司验证有效,大幅提升了成本效益比。 此外,自动化运维工具和智能调度系统的引入,可以帮助团队更加灵活地管理资源,动态调整计算能力应对流量波动,避免资源浪费。持续集成与持续部署(CI/CD)流程也需针对生成式AI进行改造,支持快速迭代和多版本模型并行测试,确保上线模型的稳定与安全。配合细粒度的权限管理和安全审计,保障企业数据和用户隐私的合规性。

从技术选型方面,企业应关注支持生成式AI的专用基础设施,包括具备高带宽低延迟的GPU集群、定制推理芯片以及分布式计算框架。云服务商纷纷推出针对LLM的托管解决方案,也为不具备自建能力的团队提供了方便快捷的上云路径。然而,无论选择何种平台,合理的资源规划和预算管理必不可少,避免因盲目扩容带来的高昂费用。 运营层面,沟通协调也至关重要。生成式AI项目涉及数据科学家、工程师、产品经理以至财务和法律团队的多方协同,确保技术落地符合商业目标和法规要求。定期的项目复盘与经验总结,有助于快速识别问题根源,推动跨部门合作与持续优化。

总之,生成式AI项目是否能成功走向生产,关键在于是否认识到其与传统模型的根本差异,构建起面向未来的GenAIOps体系。技术与运营必须并重,既要搭建稳健高效的基础设施,也要构建灵活的监控与优化机制,积极应对成本和性能的挑战。未来随着技术的成熟和产业生态的发展,更多成熟工具和经验将涌现,帮助企业解锁生成式AI的巨大商业价值。面对变革浪潮,唯有拥抱创新、不断调整,才能避免成为众多先行者失败的案例之一,实现真正的规模化、可持续发展。