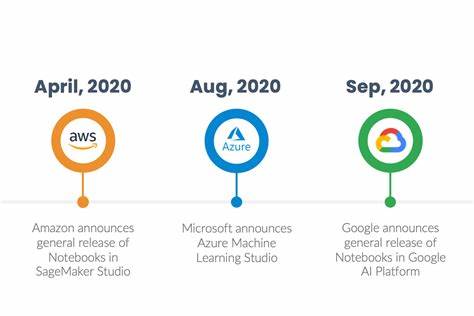

随着人工智能技术的飞速发展,医学教育领域迎来了前所未有的变革机遇。针对医学学生的学习需求,智能化、个性化的辅助工具逐渐成为焦点,尤其是在知识点迅速转换和海量信息管理方面表现突出。构建一款基于谷歌云平台(GCP)的AI驱动学习平台,不仅能极大提升学习效率,还能为医学学习注入精准的内容生成与智能问答功能。本文将深入剖析在GCP环境中实现AI与大语言模型(LLM)结合的最佳实践,助力开发团队实现低延迟、高准确度的智能医学学习助手。 选择谷歌云平台作为AI技术的落地平台,得益于其全面的云基础设施与丰富的人工智能产品生态。从计算资源到数据存储,再到人工智能API服务,GCP提供了一站式解决方案,满足高并发、低延迟的生产环境需求。

核心技术之一为检索增强生成(Retrieval-Augmented Generation, RAG)体系,RAG结合了大型语言模型的生成能力与外部知识库的检索优势,有效提升内容的准确性和关联度,适合医学这类高专业度领域的应用。 关于向量存储的选择,是构建RAG架构中的关键环节。目前市面上多种向量数据库均可搭配使用,包括AlloyDB支持的pgvector扩展、Pinecone、Weaviate以至于谷歌自家Vertex AI的向量搜索服务。针对规模约1000日活跃用户,预计一年内生成不超过千万级别的嵌入向量需求,且在准确率优先于成本的前提下,推荐采用Vertex AI向量搜索。其深度整合谷歌云生态,具备极佳的性能表现和稳定性,可以通过自动扩容确保低延迟查询,同时简化运维难度和集成复杂度。 技术框架的选择同样重要。

对于拥有Java后端团队,同时考虑引入Python微服务的开发者,LangChain和LlamaIndex是目前业界广泛采用的开源框架。LangChain提供了丰富的链式调用和数据流程管理能力,便于构建与大语言模型的灵活交互。而LlamaIndex则侧重于文档索引和知识库构建,适合做多源文档的整理和嵌入。两者均支持混合语言调用,方便Java团队通过gRPC或HTTP接口调用Python组件,实现架构解耦与职责分离。 架构设计层面,保留部分RAG业务逻辑在Java端有助于与现有系统无缝集成与统一运维,但复杂的模型调用和数据预处理往往需要Python生态丰富的AI支持库及社区,这时引入Python微服务成为合理选择。通过gRPC或HTTP协议通信,实现高效调用同时保证系统间的低耦合性,利于后续扩展与替换。

除此之外,利用Vertex AI Extensions或谷歌云函数,还能实现部分轻量级功能的事件驱动执行,进一步优化资源利用率和响应速度。 针对低延迟要求,embedding模型的选择至关重要。一方面,模型体积和计算开销需在保证语义表达力的前提下保持轻量化,另一方面应优先选用具备医学领域语义优化的预训练模型以提高精准度。智能分段与缓存策略有助于减少重复计算,提高查询效率。搜索索引的调优和异步、并行调用是提升并发处理能力的重要手段。此外,引入内存级的FAISS向量索引层,能够实现亚秒级规模检索,满足千人日活的应用场景。

在医学内容的准确性评估方面,基于自动化工具如RAGas和Promptfoo可实现初步的生成质量检测与监控,但最终的准确性判断仍需辅以人工设计的评分标准或专家抽查,确保符合医疗行业高标准的内容可信度。除事实正确率外,幻觉率(hallucination rate)、引用准确率和回答的相关性均为评价指标,有助于系统持续优化。 2025年,随着模型技术演进,基于大规模多模态预训练模型的embedding方案将逐渐成为主流,支持多种文本、图像等数据融合处理,极大提升医学复合信息理解与生成的能力。研发团队需密切关注嵌入模型更新动态,及时结合最新研究成果,确保平台在技术层面保持竞争优势。 实际项目运维经验显示,初期快速构建并验证RAG流程是关键。若有机会深入用户代码仓库,首要动作是搭建端到端的检索增强生成链路,重点验证文件解析后向量构建、索引查询与语言模型响应的整体闭环效果。

通过持续迭代改进,高效捕获各个环节潜在瓶颈,减小系统失误率与延迟,可显著降低后续开发风险。 总而言之,基于谷歌云平台构建AI驱动的医学学习平台,必须统筹向量存储、框架组件、微服务架构设计、性能优化及质量测评多个维度。通过合理选型Vertex AI向量搜索与LangChain生态,结合医学领域嵌入模型定制与细粒度性能调优,能够实现响应迅速、内容精准、用户体验优的智能辅助系统。随着医疗AI应用的蓬勃发展,掌握并应用上述关键技术和实践,必将站在行业前沿,推动医学教育的数字化智能变革。