随着人工智能技术的高速发展,大型语言模型(LLM)在自然语言处理领域展现出惊人的能力,推动了聊天机器人、文本生成、智能问答等应用的快速普及。如何在满足大规模用户请求的同时实现高效推理,成为行业亟需攻克的难题。作为前沿的推理系统,vLLM以其卓越的吞吐量和低延迟,赢得了广泛关注和实践验证。深入探究vLLM的设计和实现,有助于理解现代高性能LLM推理系统的核心架构和技术亮点。vLLM的设计理念最核心的目标是通过高度优化的流水线和资源管理,实现大规模并发请求的快速响应。其架构模块化且灵活,集成了多层次调度机制、缓存策略和并行计算支持,满足了不同场景的推理需求。

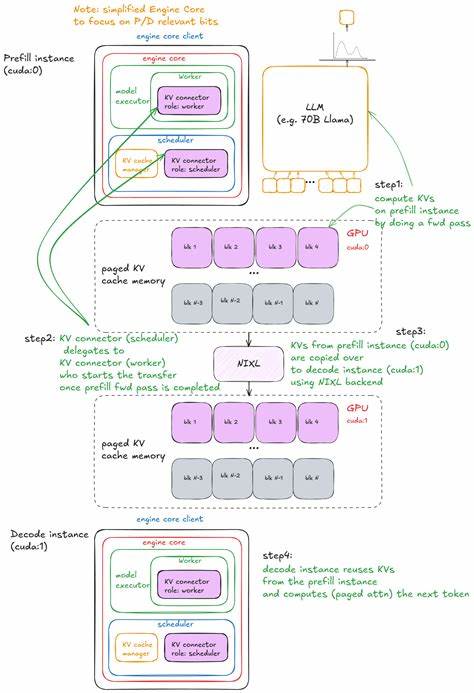

首先,vLLM的引擎层是整个系统的中枢,负责管理输入请求的排队、调度与批处理。它利用高效的调度算法,动态决定每一步推理的任务优先级和资源分配,支持先到先服务(FCFS)及优先级调度策略,保证系统响应的公平性和高效性。引擎通过请求处理器对外提供统一接口,将用户的原始输入转化为内部标准格式,确保后续计算阶段的数据一致性与高效传递。调度器不仅负责管理等待队列和运行队列,还集成了智能的键值缓存管理器(KV Cache Manager),核心地实现了"分页注意力"机制,极大地提升了长上下文的推理效率。KV缓存管理器通过维护缓存块池,实现对关键缓存内容的快速检索与复用,避免了重复计算大量历史上下文,大幅度降低了推理时间和显存压力。这种设计使得vLLM适合处理海量且复杂的文本输入,尤其在对长文本保持上下文相关性时表现出色。

模型执行器(Model Executor)是vLLM中执行核心的计算单元,其目前以单进程、单GPU的统一进程模式(UniProcExecutor)为主,确保了计算资源的最大化利用。执行器内嵌Worker组件,负责设备初始化、模型载入、内存分配、流水线管理等关键功能。Worker对GPU资源和显存使用进行细致监控,支持半精度(fp16)、混合精度和多种量化模式,平衡性能与资源消耗。模型执行流程中,vLLM采用了多种创新技术,如CUDA图加速(CUDA Graphs)、流水线并行、张量并行和张量调度等。通过动态的批次大小配置和多样化的张量操作调度,系统能够对用户请求实现高效整合和并行推理,推动整体吞吐率的提升同时确保响应延迟的最低化。vLLM的生成机制以其"generate"模式为代表,针对文本生成任务进行了专门优化。

生成函数支持多样输入格式,包括文本、令牌和嵌入向量,并允许针对不同请求定制采样参数。系统自动根据显存限制和模组性能,智能批量处理用户请求,确保所有生成任务被高效调度执行。内部生成函数流程包括请求添加、验证、批次管理和引擎迭代执行,调用引擎的step()函数逐步推进生成过程。每次step包含请求的选取、模型执行和结果缓存三个阶段,最终输出结构化的请求结果。此设计保证了多请求环境下的计算资源合理分配,并支持优先级调度使高优先级请求获得更快响应。系统的关键优化之一体现在KV缓存的精细管理上。

KV缓存块基于上下文块大小进行划分,当新生成的文本超出缓存块边界时,系统会自动刷新缓存,避免部分数据重算。缓存内容以缓存块池形式组织,每个缓存块维护引用计数,确保缓存资源的有效利用。缓存机制配合分层注意力结构,最大化减少冗余计算和GPU通信带来的性能瓶颈,对于长上下文的存储和访问尤为重要。在模型执行方面,vLLM引入了模块化的GPU模型运行器(GPUModelRunner),内部集成采样器和拒绝采样器,支持多样化的采样策略和自定义生成控制。模型执行时通过上下文管理器设置前向计算环境,结合动态张量批处理和流水线,确保每批次计算被高效执行后直接缓存结果。模型组件具有高度的分布式意识,支持数据并行、张量并行及管道并行,适合大规模分布式环境下的高效执行。

此外,系统内嵌了结构化输出管理器,用于支撑复杂的引导式解码和任务特定的输出控制。通过内建的日志采样、概率提示计算等功能,vLLM能为生成结果提供丰富的上下文分析数据,帮助开发者更好地调优和理解模型行为。为了满足工业级部署需求,vLLM充分考虑了多GPU、多进程和异步输出处理的兼容性。用户可根据实际资源配置切换单进程或多进程模式,多进程模式下借助DPLBAsyncMPClient实现横向扩展,高效处理百万级并发请求。同时,vLLM集成了丰富的监控和诊断能力,如请求状态追踪、缓存状态监控、GPU使用率记录和性能统计,支持基于Prometheus的指标采集,为稳定性优化和故障排查提供了坚实支撑。在整体架构层面,vLLM不仅仅是一个简单的推理引擎,更是一个高度工程化的端到端系统。

它涵盖了从输入预处理、动态调度、模型执行到结果后处理、异步输出和状态管理的完整闭环。此设计使得开发者能够在保持最高性能的同时,灵活定制生成策略,结合LoRA微调、量化模型支持和多模态扩展,实现多样场景的适配。总结来看,vLLM凭借其前瞻的缓存机制、灵活的调度策略和高效的执行框架,成功解决了大型语言模型推理速度与资源利用的矛盾。它不仅适合学术研究探索,更实现了工业级生产部署的严苛要求。未来,随着硬件技术和模型规模的不断升级,vLLM还将持续演进,提升计算效率、增强负载均衡能力和丰富辅助功能,助力打造更智能、更响应迅捷的语言智能服务。对于技术社区和企业用户而言,深入理解vLLM的架构设计和实现细节是实现高性能语言模型应用的必要基石,能够显著提升推理效率与用户体验,推动AI服务从原型到大规模生产的成功转型。

。