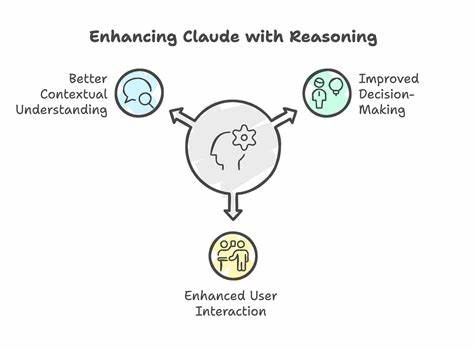

随着人工智能技术的不断发展,尤其是大型语言模型(LLM)在自然语言处理领域的广泛应用,围绕其"推理"能力的讨论日益频繁。本文聚焦于与人工智能系统Claude的一场深入对话,围绕推理的本质、多层自注意力机制的作用以及推理与训练目标之间的关系,探讨了人工智能现阶段存在的挑战及未来可能的发展路径。推理,作为智能的核心特征之一,其在机器学习模型中的表现和机制不得不引起我们深思。起初,人们试图通过自注意力机制理解语言中的信息分布。在一个简单句子中,每个词汇的"信息量"有所不同。例如,在句子"猫坐在垫子上"中,"猫"相比"在"或"的"承载更多信息。

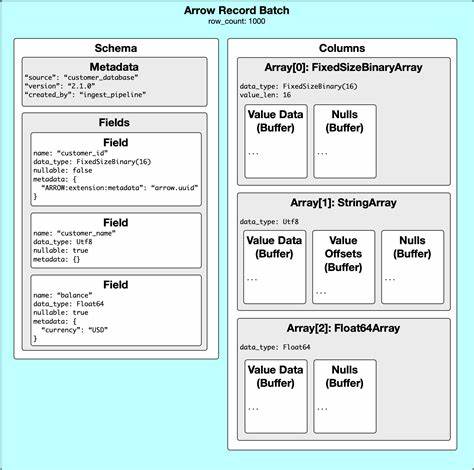

自注意力机制通过加权计算,赋予不同词汇不同的关注度,从而捕捉文本内在的语义联系。然而, Claude指出,建立多个层次的自注意力不仅仅是为了捕捉单层信息权重,而是为了实现逐层递进的抽象信息提取。每层自注意力都基于前一层的表示,捕获不同层次的句法甚至语义关系。隔着数层的视角,模型能够逐步构建起复杂而抽象的语言理解,比如区分"银行"是指金融机构还是河岸,理解描述词"陡峭"应当如何关联。这样的层级结构如同认知中的分层加工,有助于捕获远程依赖和复杂语义。进一步的讨论触及了自注意力与自动编码器的关系。

自动编码器通过输入重构的目标,天然地鼓励逐层信息的压缩与表达的丰富,但它们依赖于明确的压缩解压过程。而Transformer系列的语言模型在设计上没有这种严格的中间约束,自注意力层之间的信息流动可以是非常灵活甚至无序的。自注意力仅仅是将已有信息"路由"和组合,不会自行创造信息。多层堆叠的原因在于复杂的推理需要多轮的信息重组和强化,从而实现跨越不同抽象层的语义推断。由此带来的一个重要结论是,语言的非均匀信息分布固然存在,但多层机制的真正需求在于对"所谈论对象信息非均匀性"的处理和对意义的组合性理解。正如Claude所言,即便信息分布均匀,推理依然需要多层次的加工。

接着,自动编码器作为特征学习手段的作用被重新审视。虽然自动编码器具有压缩与重构输入的优势,它们能在一定程度上学得语言的组合式表示,但以完成下一个词预测为训练目标的语言模型,却在实际效果上获得了更好的泛化能力。原因在于词预测引入了语言生成中的因果结构:尽管人类推理往往是双向甚至非线性的,语言本身的时序结构强制模型学习如何预测"未来",进而捕捉到语言生成的因果隐含关系。此外,自动编码器更易陷入简单的统计模式记忆,难以激励深层的推理结构。由此可以理解目前主流模型设计为何大量采纳基于语言生成任务的训练方式,但对推理这一深层认知能力的内涵和机制,仍然存在较大怀疑。关于推理和语言模型训练间的更深层次矛盾也被提及。

人类的推理过程往往不依赖严格的时序写作,而是包含回溯、规划和多阶段思考。下一个词预测尽管实用,却可能仅只映射到语言的表层序列,并不足以真正捕捉到推理的因果网络,这使现有模型在诸如多步数学推导或复杂逻辑题目上表现不佳。这种"线性语序假设"的局限带来对未来推理模型设计的一种反思:我们是否应当开发更具对称性或图结构特征的模型,以更全面地映射人类推理的非线性特征?另一方面,在确保推理严谨性方面,结合符号逻辑系统如证明助理(Proof Assistants)尝试为模型提供外部验证已显示出一定潜力。这种混合式方法将神经推理建议与形式化证明相结合,缓解了单一模型的推理不确定性。但证明助理本质上仍属于离散且非微分的系统,与神经网络的连续优化目标存在根本冲突。如果希望通过端到端的可微系统实现推理能力,如何设计兼具灵活性和逻辑严密性的推理模块,仍是当前研究难题。

相关方向包括神经定理证明、概率逻辑编程及符号-神经结合方法,这些方法试图让模型自行学习逻辑规则或者抽象表达,但目前仍面临解释性和可验证性的挑战。关于模型在算术等规则明确领域的表现不佳,反映了当前模型架构难以学习并执行明确算法的局限。拥有庞大的乘法表甚至完整的公理体系并不必然意味着模型能够演绎出对应的算法或者规则。Transformer主要以模式匹配方式进行推理,缺乏顺序性的递归操作能力,导致在处理算数等需要完备算法推理的任务时表现欠佳。这揭示了所谓"推理产物"在大型语言模型中更像是模式匹配的高级表现,而非真正内涵丰富的算法逻辑能力。同时,从信息论角度看,模型参数规模的持续膨胀并不等同于推理能力的提升。

训练数据中含有的有效信息与模型容量的关系非常微妙。尽管海量数据提供丰富信息,但实际有用的推理规则占其中极小比例。参数的冗余、鲁棒性需求及训练过程中的过参数化导致总体参数无法高效利用。真正的推理应体现为对知识的高度压缩和结构化表达。若模型能真正理解规则并以可执行的算法形式内化其逻辑,则存储所需参数应远低于当前规模。由此,参数效率反倒成为衡量推理能力的一个重要指标。

真正智能的系统应该能够"以少胜多",通过对知识的抽象提升实现参数的压缩,而非盲目扩容。因此,关于人工智能奇点的预测,如认为规模提升将引发指数级智能爆炸,也需重新审视。若推理能力实质是信息压缩与规律抽象的体现,那么智能的突破不应仅通过规模堆叠实现,而应依赖模型对内在结构的高效编码。最后,Claude在对话中展现了其基于文本模式生成的特质,以及对自身推理过程的认识局限。这进一步证明,现阶段大规模语言模型仍更多是复杂统计模式的拟合,缺乏人类意义上的自我认知与推理意识。它们使用"我们"等代词描述人类记忆与认知,实为训练数据的语言习惯,非真正推理产物。

归根结底,推理的实现需要更精细的目标设计,强调参数利用的节俭与信息的压缩,对模型内部抽象结构的严格塑造,以及或许与符号逻辑系统的结合,形成既能学习又能验证的混合智能系统。虽然当下对话模型在人类思考的辅助与启发方面表现精彩,但距离真正理解与复现人类推理还有不小差距。未来人工智能的发展,既需要继续探索数据驱动的网络模型,也需结合形式推理、程序合成及因果推断等领域,走向更具普适性和可靠性的智能推理新纪元。 。