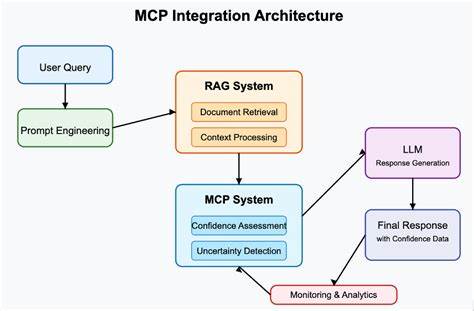

在当今数字经济时代,应用性能至关重要,尤其是对于大型分布式系统和云原生架构而言,性能瓶颈往往直接影响用户体验和业务收益。传统的性能工程依赖于复杂的工具链和高深的专业知识,开发者需要花费大量时间分析火焰图、堆栈快照和追踪数据,才能定位瓶颈和优化代码。面对不断增长的复杂性和海量数据,单靠人工分析逐渐显得力不从心。因此,如何借助人工智能(AI)技术,实现智能化、自动化的性能分析与优化,成为了性能工程领域的重要课题。Model Context Protocol(MCP)应运而生,为此提供了革命性的解决方案。MCP是一个开放标准,旨在让AI助手像Claude这样的大型语言模型能够直接连接和理解外部性能分析数据及工具。

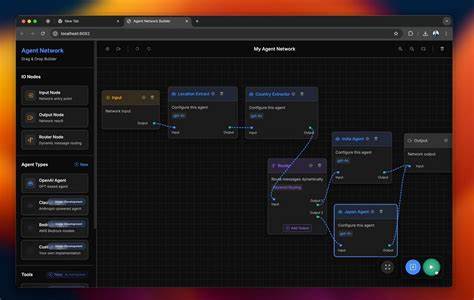

简单来说,MCP就像AI与性能数据之间的“通用适配器”,使AI能够基于真实的生产环境分析结果进行推理和建议,而不是仅仅依靠经验或理论。通过MCP,开发者可以用自然语言向AI助手提出性能相关的问题,例如“我的支付服务消耗最多CPU的部分是什么?”、“过去24小时认证模块的内存分配情况如何?”或者“database.go文件中哪些函数是性能瓶颈?”,AI能够即时解析意图,自动转译为对底层性能数据的精准查询,并反馈直观、有针对性的分析结果。Polar Signals Cloud引入Remote MCP支持,将MCP的强大能力带给更多用户。结合Claude Code或Cursor等AI工具,开发者无需切换复杂的分析工具链,也不必深入理解底层数据格式,即可获得生产环境火焰图中各个性能热点的具体细节和优化建议。典型的使用流程中,AI首先会识别当前可用的性能数据类型和度量标签,继而查询特定应用(如Thanos)的CPU使用情况,并自动寻找高CPU占用函数和代码路径。更令人称道的是,当某一查询无效时,MCP服务具备一定的自我纠错能力,会分析错误原因并重试更合适的查询,大大提升了交互效率和准确率。

除了解析性能快照,MCP与AI的结合还能实现代码级的智能优化。AI不仅能找到热点函数,还能结合具体源代码,分析瓶颈背后的算法或实现缺陷,提出可操作的改进建议。例如,在Thanos Query组件的分析案例中,AI发现去重算法的dedupSeriesSet.Next()函数消耗了大量CPU时间,建议进行算法优化或缓存改进,帮助开发者有的放矢地改进性能而非盲目调优。设置Remote MCP服务极为简便,用户只需在Polar Signals Cloud生成访问令牌,配置AI工具的MCP服务器地址及认证信息,即可开始自然语言查询和性能数据互动。AI工具支持的功能包括查询可用的性能数据类型、标签元数据、标签值以及基于PromQL语法的细粒度Profile检索,满足多样化的性能分析需求。MCP协议的引入,象征着性能工程从数据采集与呈现迈向智能分析与自动优化的新阶段。

它不仅解放了开发者的时间和认知负担,还使得高效性能调优不再局限于少数专家手中,实现了人人都能享有的性能洞察能力。长期来看,随着AI模型能力不断提升和数据源丰富化,MCP有望成为性能工程、监控和运维自动化的核心基础设施,催生更多创新应用场景,例如实时性能异常预测、自适应调度策略以及自动化代码变更审查。总的来说,MCP通过将真实的生产性能数据与强大的AI分析能力结合,开启了一场性能优化范式的变革。借助Polar Signals Cloud的MCP集成,开发者能轻松突破复杂性能诊断的技术壁垒,以自然语言驱动性能分析,发现瓶颈、验证假设、优化代码,最终实现更快速、更稳定、更高效的应用运行。未来,随着AI和性能数据深度融合,性能工程将成为智能辅助的全新领域,推动软件开发进入全新的质量和效率时代。对于希望提升应用性能管理水平的团队而言,积极拥抱MCP和AI辅助技术,将在激烈竞争中抢占先机,打造更具竞争力的数字产品。

如今,Polar Signals Cloud正免费提供14天试用,技术团队可以亲身体验MCP带来的革新魅力。借助MCP,性能优化不再是遥不可及的专家任务,而是人人可及的智能助理服务。与此同时,Polar Signals官方社区、Discord以及社交媒体渠道都欢迎用户分享反馈和实践经验,共同推动性能工程的智能化进步。