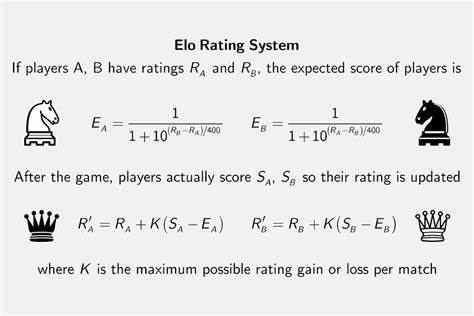

随着人工智能技术的高速发展,信息检索领域也迎来了前所未有的创新机会。传统的文本检索和排序方法虽然取得了显著进步,但在准确性和一致性方面仍存在挑战。针对这一痛点,Zbench应运而生,成为当前RAG(Retriever-Augmented Generation)评估领域中的一颗新星。Zbench的核心优势在于其独特地借鉴了国际象棋中的Elo评分机制,引入了基于对弈胜负的理念对文档相关性进行排序,显著提升了检索结果的精度和解释性。 Zbench是一款综合性的评估平台,它通过运用顶尖的大型语言模型(LLM)组合,对搜索查询与候选文档之间建立起成对的竞赛评价体系。这种两两对抗的方式源于国际象棋中的Elo评分理念,Elo评分本质上是根据选手之间的胜负关系计算排名积分,在文本检索领域被创新性地用来评价文档之间的相对相关性。

在该平台的运行过程中,对于给定的查询和多个候选文档,Zbench并不是简单地依赖单一模型做出判断,而是利用包括OpenAI的GPT-4、Anthropic的Claude以及Google的Gemini等多款先进LLM组成的集成体系,逐对比较文档对的相关性。每个模型都会对文档对给出区间在-1到1之间的评分,这个分值代表了模型对哪一篇文档更相关的看法。通过整合三款模型的共识判定,Zbench能够极大降低单一模型评判的噪声与偏差,进而提高整体评估的鲁棒性与可信度。 借助Bradley-Terry模型对这些成对比较的结果进行处理,Zbench最终计算出基于Elo算法的zELO分数,此分数是对每篇文档相关性的一种精确度量。相比于传统的单点评分,这种通过成对比赛得出的排名分数能够更好地反映出文档之间复杂的优劣关系,使得结果更加具有层次感且便于解释。 一个显著的优势是Zbench的高效率与可扩展性。

传统的两两比较算法计算量为N的平方级别,面对海量文档时,计算资源消耗极大。Zbench采用了优化的随机循环采样策略,只需对每篇文档进行少量(约4次)成对比较,便能还原出与密集矩阵结果相差无几的zELO排序。这不仅大幅降低了调用API的成本,也使得大规模数据集的评估成为可能。 从实际成本角度来看,目前Zbench的估算开销大约为每千次推理20美元。考虑到每对推理包含两篇文档,一百条查询,各含25篇文档的场景下,运行成本约为两百美元。这样对比人工标注不仅节省了大量的人力物力,还通过机器一致性带来了接近97%的高质量注释准确率。

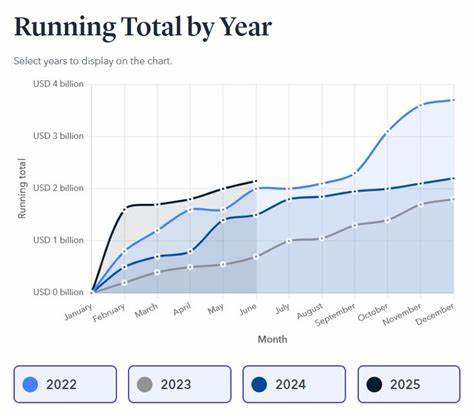

此外,Zbench提供了可视化工具,使研究人员可以直观观察不同文档之间的相关性对战矩阵。通过将文档根据zELO分数排序后,矩阵呈现出具有明确区分度的三角形分布,彰显了评分体系的自洽性与可靠性。用户还能进一步查看特定文档参与的所有配对评分,有助于深入剖析评价结果及潜在的异常情况,进行针对性的模型调优或提示工程优化。 值得一提的是,Zbench支持多型号自定义再排名器的集成。用户不仅能够调用平台内置的Zerank模型,还可以基于BaseReranker基类自行实现专属的评分函数,通过异步调用并发执行,有效防止API请求的速率限制,满足多样化的业务需求。 通过引入诸如NDCG(归一化折损累计增益)、成对准确率和Recall@K等多重指标,Zbench能够全面衡量再排名器在排序质量、相关文档捕捉率及准确率上的表现。

各指标结合使用,为研发团队提供更立体的评估视角,从而不断优化信息检索流程。 实际操作中,Zbench提供了便捷的注释流水线。用户只需提供基本格式符合规范的查询与文档数据,即可通过简单的命令行调用完成从数据加载、成对组合生成、AI模型评分再到最终Elo排序的全过程。注释结果以JSONL格式保存,结构清晰,兼容性强,方便进一步分析。 针对大规模数据,Zbench也推荐逐步扩展的方案。初次尝试时可设定较低的文档阈值和较少的循环次数,监控效果和成本,之后再逐步放开限制,以确保系统稳定高效地应对更复杂任务。

总体而言,Zbench在信息检索与文档排序领域开拓了一条利用国际象棋Elo评估系统的新路线。其创新性的组合多模型集成、高效稀疏采样及可解释的成对比较模式,使得检索结果的评估更加客观、可靠。未来,随着大型语言模型能力的持续提升以及应用场景的不断拓展,基于zELO评分的评估技术有望在搜索引擎优化、推荐系统增强以及智能问答等领域发挥更加重要的作用,助力实现更加精准且高效的知识获取体验。