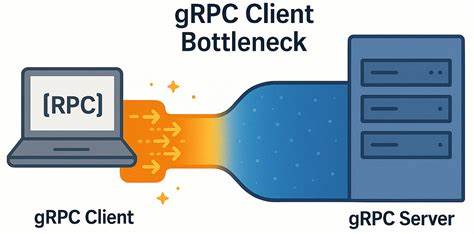

随着分布式系统和微服务架构的广泛应用,gRPC作为高性能的远程过程调用(RPC)框架,越来越受到开发者的青睐。gRPC基于HTTP/2协议,支持多路复用流,能够在单一TCP连接上并行处理多个RPC调用,理论上大幅提升通信效率。然而,在实际应用中,尤其是在低延迟、高带宽的网络环境下,开发者却发现gRPC客户端往往成为性能瓶颈,影响整个系统的吞吐量和响应速度。本文将深入解析这一现象的根本原因,结合权威的性能数据和实验,揭示gRPC客户端瓶颈的机制,以及如何通过合理的多连接和多通道设计突破瓶颈,提升RPC性能。 首先,我们需要了解gRPC通信的基本架构及其性能最佳实践。gRPC客户端通过创建一个或多个“通道”(Channel)与服务器建立连接,每个通道内部基于HTTP/2协议管理多个“流”(Stream),每个流对应一个独立的RPC调用。

官方文档指出,单个HTTP/2连接对并发流的数量存在限制,默认最多支持100个并发流,超过该限制的调用会被客户端排队等待资源释放。为应对高负载应用,最佳建议是为不同的高负载业务区域创建多个通道,或维护通道池,通过在多个TCP连接间分散RPC请求,减少排队堵塞现象。 然而,YDB团队在实际压力测试中发现,尽管严格遵循官方的最佳实践,即为每个工作线程创建独立通道,客户端性能依然未达预期。实验显示,在拥有高速低延迟网络支持以及多核强大CPU服务器的条件下,随着并发请求数量增多,客户端的响应延迟呈线性增长,而吞吐量提升幅度远低于理论预期。深入分析发现,客户端的所有RPC请求实际上通过单条TCP连接传输,导致HTTP/2多路复用反而成为瓶颈。这种情形下,客户端在发送请求和接收回应之间存在约150到200微秒的空闲延迟,严重制约了系统的整体性能表现。

为了揭示具体问题,研究团队使用C++实现了一套gRPC微型性能基准工具,采用闭环测试方式模拟大量快速RPC请求反馈。服务器端运用了异步API和多完成队列机制,保证极高的响应能力。客户端在每个工作线程启用独立通道,并测试不同并发请求量(in-flight请求)的吞吐量和延迟表现。测试结果异常鲜明,随着并发请求数从1攀升至20,吞吐量增幅远低于理想线性增长,客户端延迟则以近乎线性方式攀升,说明瓶颈非网络或服务器端原因,而是客户端自身的gRPC实现导致的资源竞争和请求排队。 进一步借助网络抓包工具确认,TCP连接状态良好,无拥塞、无丢包,且开启了TCP_NODELAY选项避免Nagle算法引起延迟。由此排除网络传输原因,重点聚焦gRPC的内部连接管理。

通过调整通道的创建参数和启用GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL选项,实际效果得以显著改善。该选项强制每个通道使用本地子通道池,防止通道参数相同导致连接复用,从而避免流的串行排队。测试显示,多通道管理、每个工作线程独立连接的设计,使整体吞吐量提升约六倍,延迟增长幅度大幅降低,达到性能与低延迟的理想平衡。 此现象在网络延迟较高(如5毫秒级别)环境下则不明显,表明低延迟网络条件放大了客户端内部瓶颈的问题。换言之,在高延迟链路上,网络本身的延时掩盖了客户端管理多流连接的开销,而在高速低延迟环境中,客户端实现的不足成为限制系统性能的关键因素。 从技术角度分析,gRPC客户端的瓶颈主要归因于HTTP/2单连接内多路复用流的争用,尤其是在多线程环境下,通道和流的内部调度存在竞争和排队,导致不必要的等待时间。

默认参数及通道复用策略让不同工作线程共享TCP连接,无法真正并行处理大量RPC请求。通过调优通道参数,强制每个工作线程使用独立连接,解除流的争用,能显著减少内部排队和互斥等待,极大提升通信效率。 对于开发者而言,实践中的关键经验在于合理设计gRPC通道策略。首先,应当避免在高性能需求场景下所有RPC都复用单一TCP连接,尤其是在并发请求数超出100个流限制时。其次,使用不同的通道配置参数(如通道编号等自定义参数)确保每个通道拥有独立的TCP连接,打破复用限制。最后,启用GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL是一种简单而有效的技术手段,帮助客户端管理独立子通道池,避免资源竞用。

这一策略不只是理论上的最佳实践,而是在真实高性能系统中验证过的有效方案。随着云原生、高性能数据库以及实时微服务应用的不断兴起,gRPC通信的性能优化成为不可忽视的课题。本文讨论的低延迟网络下客户端瓶颈与优化策略,既为分布式数据库提供了技术借鉴,也为广大分布式系统开发者指明了提升RPC性能的方向。 展望未来,gRPC生态预计将在多核多线程环境调度和连接管理方面持续优化,带来更智能的流控与资源分配机制。此外,更多细粒度的连接池和多路复用机制调整,将有助于系统充分释放硬件性能,满足对吞吐量和低延迟的双重诉求。希望本文的分析和实验方法能为读者深入理解gRPC性能瓶颈提供参考,也欢迎社区贡献更多优化经验,共同推动RPC技术进步。

。