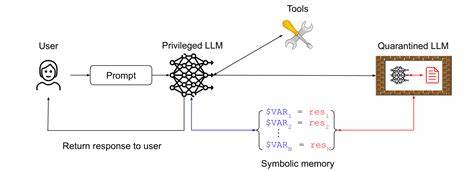

随着人工智能技术的高速发展,AI代理作为能够自主执行任务和决策的智能系统,正逐渐融入我们的日常生活和工业生产。谷歌作为全球领先的科技巨头,积极致力于推动安全AI系统的研究与应用,其最新发布的安全AI代理策略为业界树立了重要的标杆。谷歌倡导的安全AI代理方案以“混合防御深入策略”为核心,融合了传统的确定性安全控制与动态的推理式防御机制,旨在打造既强大又安全的智能代理。 谷歌强调,安全的AI代理必须基于三个核心原则。首先,AI代理必须拥有明确的人类控制者。人类操作员不仅负责赋予AI任务目标和权限,还需持续监督其行为,保证系统在预定范围内运作。

这种明确的控制关系有效防止AI代理在未经授权的情况下偏离目标,减少潜在的滥用风险。其次,AI代理的能力必须受到严格的限制。谷歌主张通过技术手段和制度规范确保代理的权限边界清晰且不可轻易突破,从根本上避免AI掌握过度权限带来的安全隐患。最后,AI代理的行为和规划需保持完全的可观察性。建立透明的监控及日志系统使得其决策流程和执行细节可追踪、可审计,增强系统对异常和潜在威胁的及时响应能力。 这三大原则共同支撑起谷歌的防御体系,通过多层次、多维度的防护构筑一道坚固的安全壁垒。

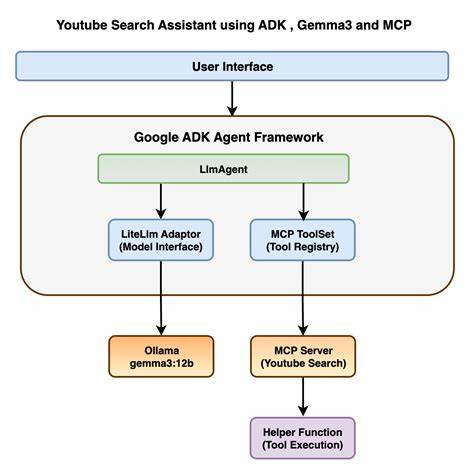

在传统的安全控制方面,谷歌依靠经过验证的身份认证、访问管理和漏洞检测技术保障系统基础安全。与之结合的是动态推理式防御,这种方法利用先进的机器学习和人工智能技术,实时分析AI代理的行为模式,通过异常检测、风险评估和行为约束等机制,主动预防和遏制可能的攻击和失控情况。 谷歌的这一战略不仅注重技术层面的安全,还强调在研发和应用过程中贯彻安全的设计理念。安全性成为AI代理开发的基础要求,而非事后补救的附加功能。这种“安全默认”理念确保在设计初期就将安全风险纳入考量,提升系统的整体鲁棒性和可信度。同时,谷歌积极推动开源项目与学术界合作,促进安全技术的透明共享和持续创新,构建开放且协作的AI安全生态环境。

此外,谷歌深知安全AI代理的实施需要兼顾效率与用户体验,特别是在面对复杂任务和多变环境时,如何在保障安全的前提下发挥代理的最大效能。为此,谷歌投入大量资源优化代理的决策算法,确保其在遵守安全约束的同时,能够灵活应对现实挑战,实现高效与安全的平衡。 随着AI应用场景的不断扩展,从智能助理、自动驾驶到医疗诊断和工业自动化,安全AI代理的重要性日益凸显。谷歌的安全框架为相关企业和研究机构提供了宝贵的参考方向,推动整个行业建立共识和标准,减少AI潜在风险带来的负面影响。 未来,谷歌计划持续深化这一领域的研究,探索更智能、更可靠的安全防御技术,力图实现AI系统的自适应防护与人机协同控制。同时,谷歌强调政策制定者、技术开发者和用户的紧密合作,共同打造安全、可信赖的AI生态,确保人工智能技术造福社会。

总的来说,谷歌的安全AI代理方法体现了现代人工智能发展的趋势和挑战,通过清晰的人类监督、严格的权限限制和全面的行为可观察性,有效应对安全风险。这一策略不仅推动了AI技术的健康发展,也为构建更加智能、可信赖的未来铺平了道路。随着技术的不断进步及应用的不断拓展,安全AI代理必将成为引领智能时代安全保障的核心力量。