人工智能技术的快速发展正在深刻改变我们的生活和工作方式,尤其是在自然语言处理领域中,大语言模型(LLM)扮演了极为关键的角色。然而,传统的大语言模型在实际应用中存在一个显著问题 - - 非确定性。每当用户多次询问同一个问题时,模型往往会给出略有不同的回答,这种随机性给企业、科研及用户体验带来了不小的挑战。近期,科技界一项由Thinking Machines Lab提出的确定性大语言模型(Deterministic LLM)技术受到广泛关注,引发了业界对于AI响应稳定性的新一轮思考。确定性大语言模型的核心目标是使AI在面对相同输入时能够产生一致且可复现的输出,彻底改变目前大多数模型回答多样化的现状。这一突破不仅提升了用户信任感,也为基于AI的业务决策、科研数据分析及强化学习训练带来了积极影响。

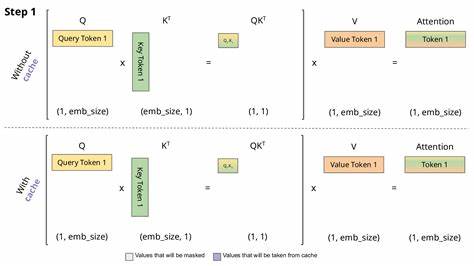

Understanding这个问题的根源可以从深层硬件架构 - - 尤其是GPU核(GPU kernels)的运行机制上展开。GPU作为AI模型推断过程中的计算核心,其内部核程序的随机调度和浮点计算精度可能引入微妙的非确定性。这些细微差别在多次推断中积累后,导致模型最终输出的多样化。Thinking Machines Lab的研究团队通过仔细分析和控制GPU核的组织方式,尝试在推断阶段实现完全可控的计算路径,进而消除非预期的随机因素。这一技术层面的创新使模型输出趋于稳定,极大提升了回答的可预测性与一致性。确定性大语言模型对强化学习(Reinforcement Learning, RL)的改进尤为关键。

强化学习依赖于对模型输出的奖励机制,而当同一个输入产生的输出千差万别时,奖励反馈会变得噪声重重,削弱训练效果。通过确保每次推断的输出一致,RL过程变得更清晰、更有效,模型能够更准确地调整策略,从而实现更优的性能表现。此外,在企业级AI应用中,确定性为数据合规、审计及监管带来了便利。例如,金融、医疗等行业对于数据处理的可追溯和稳定性有着严格要求,确定性模型能够保证每次查询的结果一致,避免因模型"随机应答"产生的风险。Thinking Machines Lab计划通过不断公开研究成果,推动确定性AI技术的普及和应用,这种开放姿态有助于提升整个AI生态的透明度和合作效率。该实验室的创始人之一,前OpenAI首席技术官Mira Murati强调,未来的产品不仅适用于科研人员,也将惠及初创企业,让更多开发者能够基于确定性模型进行创新。

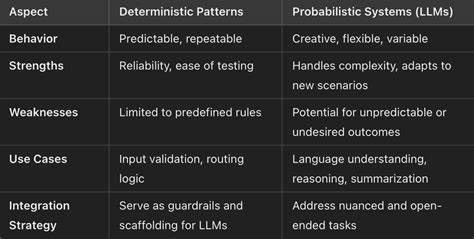

值得注意的是,随着AI领域竞争日益激烈,许多领先企业开始关注更精细的模型控制技术。确定性LLM有望成为行业的下一个技术风口,催生低噪声、高信赖度的智能应用方案。它不仅是算法层面的革新,更涉及硬件调度、软件编程和系统架构的多维度协作。未来,随着计算硬件的进步以及算法优化的深入,确定性大语言模型有望在机器翻译、自动摘要、法律辅助、智能问答等多个领域展示其独特优势。对用户而言,使用确定性AI意味着获得更稳定、更可信的交互体验,减少误导和偏差的可能。结束语中可以预见,随着该技术不断成熟和推广,人工智能将逐渐摆脱随机性束缚,向更理性、更可控的方向发展。

确定性大语言模型不仅提升了AI响应的一致性,也为科学研究和工业应用带来了更为坚实的基础。未来数年间,这项技术有望引领新一轮AI革新浪潮,推动全行业迈向更高的智能化水平。 。