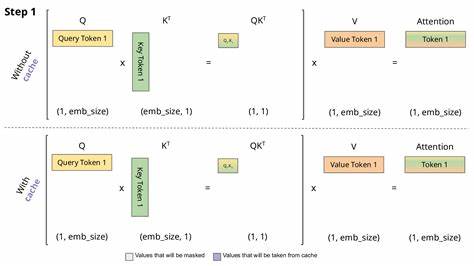

随着深度学习模型的不断发展,尤其是在自然语言处理和计算机视觉领域,对计算资源的需求也在持续增加。大型模型虽然具备强大的表达能力,但其计算复杂度和内存消耗成为实际应用中的瓶颈。分页注意力机制(Paged Attention)因此应运而生,成为解决长序列处理和大规模模型计算效率问题的重要创新方法。分页注意力通过将长序列划分为多个小块,限制了注意力计算的范围,有效降低了时间和空间复杂度。首先,分页注意力的核心思想在于局部化计算,避免传统全局自注意力机制对序列全部位置进行交互计算,从而大幅减少运算量。该方法不仅提高了模型的处理速度,还降低了显存消耗,特别适合于处理超长文本和大规模图像数据。

性能分析表明,分页注意力在保持较高性能的同时,显著缩短了训练和推理的时间。与全局注意力机制相比,分页注意力在长序列上的效果表现尤为突出,能够在不牺牲精度的前提下,提升模型的效率和可扩展性。具体而言,分页注意力通过划分窗口和重叠机制,使得不同窗口间的信息得到一定程度的交互,提高信息传递的连贯性。这种设计有效缓解了传统局部注意力可能带来的信息断层问题,更适合复杂任务和多层次特征的提取。此外,分页注意力结合硬件加速,能够更充分利用GPU和TPU的计算能力,进一步增强模型的执行效率。研究还显示,分页注意力在多模态学习和序列建模中具备广泛的适用性,其灵活的结构设计适合不同任务需求,满足实时性和精度的双重要求。

实践应用中,分页注意力被广泛应用于文本生成、机器翻译、语音识别和图像处理等领域。在文本生成任务中,分页注意力有效减少了推理延迟,使得长文本生成更加流畅自然。机器翻译中,该机制帮助处理长距离依赖,提高了翻译质量和速度。语音识别方面,分页注意力优化了时间序列数据的建模精度,提升了识别准确率。图像处理应用中,分页注意力促使模型能够精准捕捉局部与全局特征,增强了图像分类和目标检测的表现。分页注意力的改进版本也在不断涌现,例如结合稀疏注意力机制和动态窗口调整策略,进一步优化了计算资源的分配和注意力模式的适应性。

这些改进推动了大规模模型的普及和应用,为深度学习领域带来了新的突破。值得注意的是,分页注意力在实际应用中仍面临一些挑战,例如窗口划分策略的优化、跨窗口信息融合的复杂性以及动态序列长度的适配问题。相关研究正在针对这些问题进行深入探索,力求实现更高效、更智能的注意力机制。总结来看,分页注意力机制凭借其独特的计算优势和灵活的设计,成为解决长序列和大规模数据处理瓶颈的关键技术。通过优化结构和算法实现,该机制促进了深度学习模型在多领域的广泛应用和性能提升。未来,随着相关研究的推进和技术的进步,分页注意力将在提升模型效率、降低计算成本以及扩展应用场景方面发挥更加重要的作用,助力人工智能技术迈向更高水平的发展。

。